Le dernier modèle open source RWKV-CLIP de Green Deep Learning a démontré de solides performances dans le domaine de l'apprentissage de la représentation visuelle du langage grâce à sa conception innovante intégrant l'architecture Transformer et RNN. Ce modèle résout efficacement le problème des données bruitées et améliore considérablement la robustesse du modèle et les performances des tâches en aval en combinant intelligemment une architecture à double tour, des modules de mixage spatial et de mixage de canaux, ainsi qu'un cadre de génération de descriptions diversifié. Il a réalisé des progrès révolutionnaires dans la correspondance et la compréhension image-texte, ouvrant une nouvelle direction pour la recherche et l’application de modèles de langage visuel.

Gelingshentong a open source le modèle RWKV-CLIP, qui est un apprenant de représentation visuelle du langage qui combine les avantages de Transformer et de RNN. Le modèle améliore considérablement les performances des tâches visuelles et linguistiques en étendant l'ensemble de données à l'aide de paires image-texte obtenues à partir de sites Web via des tâches de pré-formation d'images et de texte.

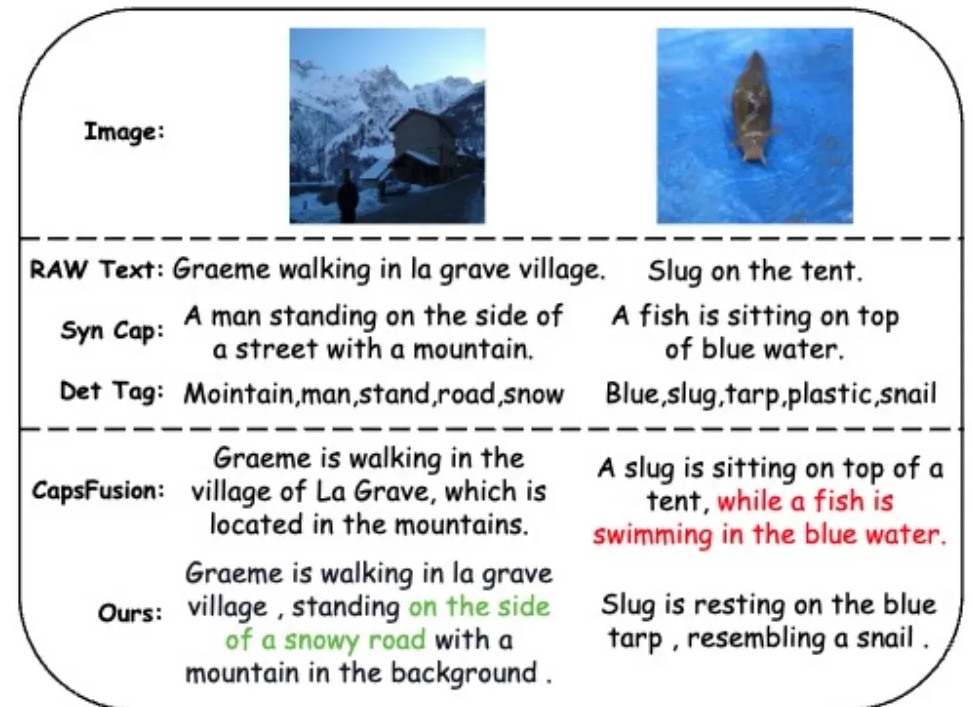

Pour résoudre le problème des données bruyantes et améliorer la qualité des données, l'équipe de recherche a introduit un cadre de génération de descriptions diversifié qui exploite de grands modèles de langage (LLM) pour synthétiser et affiner le contenu à partir de textes Web, de sous-titres synthétisés et de balises détectées.

Le modèle RWKV-CLIP adopte une architecture à deux tours, intégrant la formation parallèle efficace de Transformer et l'inférence efficace de RNN. Le modèle est empilé par plusieurs modules de fusion spatiale et de fusion de canaux, qui permettent un traitement en profondeur des images et du texte d'entrée. Au cours de l'étape de mélange spatial, le modèle utilise le mécanisme d'attention pour effectuer un calcul de complexité linéaire globale et renforcer l'interaction des caractéristiques au niveau du canal. L’étape de fusion des canaux affine davantage la représentation des fonctionnalités. En termes d'amélioration de la saisie, le modèle RWKV-CLIP améliore la robustesse du modèle en sélectionnant aléatoirement le texte original, les sous-titres synthétiques ou les descriptions générées comme saisie de texte.

Les résultats expérimentaux montrent que RWKV-CLIP atteint des performances de pointe dans plusieurs tâches en aval, notamment la détection linéaire, la classification zéro tir et la récupération de texte d'image zéro tir. Par rapport au modèle de base, RWKV-CLIP réalise des améliorations significatives des performances.

L'analyse intermodale du modèle RWKV-CLIP montre que ses représentations apprises présentent une discriminabilité plus claire au sein de la même modalité et présentent des distances plus proches dans l'espace de modalité image-texte, indiquant une meilleure performance d'alignement entre modalités.

Adresse du modèle : https://wisemodel.cn/models/deepglint/RWKV-CLIP

Dans l’ensemble, le modèle RWKV-CLIP présente un grand potentiel dans le domaine du langage visuel, et son open source fournit également des ressources précieuses pour la recherche connexe. Les développeurs intéressés peuvent visiter le lien fourni pour télécharger le modèle et mener des recherches et des applications plus approfondies.