ARC-AGI, un benchmark destiné à évaluer les capacités d'abstraction et de raisonnement de l'intelligence artificielle générale (AGI), a récemment progressé, mais son créateur François Cholet rappelle que cela ne veut pas dire que l'AGI s'approche. Il a souligné que les performances des systèmes d'IA actuels dans le test ARC-AGI sont encore bien inférieures aux attentes, et la raison principale réside dans les limites des grands modèles de langage (LLM), qui sont meilleurs en reconnaissance de formes qu'en véritable raisonnement. Sholay et ses collaborateurs ont lancé un concours d'un million de dollars pour promouvoir les percées de l'IA open source dans ARC-AGI, mais les résultats ont également confirmé que le test lui-même pourrait présenter des lacunes et nécessiter des améliorations supplémentaires.

Depuis son lancement en 2019, ARC-AGI est au centre de toutes les attentions dans le domaine de l’intelligence artificielle. Bien que le système d'IA ait fait quelques progrès lors des tests, ses scores étaient encore bien inférieurs aux niveaux humains. Cela a déclenché une réflexion sur l’orientation actuelle du développement de l’IA et incité les chercheurs à réexaminer la définition et les méthodes d’évaluation de l’AGI. L'article analyse en détail les limites des tests ARC-AGI, ainsi que les perspectives d'orientations futures de la recherche sur l'AGI, et présente les résultats pertinents de la compétition et les stratégies d'adaptation des chercheurs.

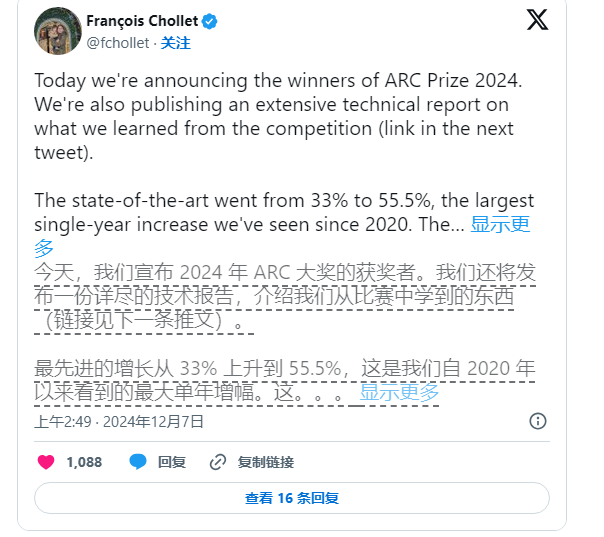

Pourtant, Sholay n’a pas cessé de promouvoir la recherche sur l’IA. Lui et le fondateur de Zapier, Mike Knoop, ont lancé conjointement un concours d'un million de dollars en juin de cette année pour encourager l'IA open source à défier la référence ARC-AGI. Bien que le système d'IA le plus performant n'ait obtenu qu'un score de 55,5 % sur 17 789 entrées, soit en dessous de la barre des 85 % nécessaire pour atteindre la « performance humaine », Sholay et Knoop y voient toujours un pas en avant important.

Knoop a souligné dans un article de blog que cette réussite ne signifie pas que nous sommes plus proches de la réalisation de l'AGI, mais souligne que certaines tâches de l'ARC-AGI reposent trop sur des solutions de « force brute » et peuvent ne pas fournir de signaux efficaces pour un véritable général. intelligence. ARC-AGI a été conçu à l'origine pour tester la capacité de généralisation de l'IA en proposant des tâches complexes et inédites. Cependant, des doutes subsistent quant à la capacité de ces tâches à évaluer efficacement l'AGI.

Remarque sur la source de l'image : l'image est générée par l'IA et l'image est autorisée par le fournisseur de services Midjourney

Les tâches du benchmark ARC-AGI impliquent des problèmes d'énigme, etc., qui nécessitent que l'IA déduise des réponses inconnues sur la base d'informations connues. Bien que ces tâches semblent favoriser l’adaptation de l’IA à de nouvelles situations, les résultats montrent que les modèles existants semblent trouver des solutions grâce à un grand nombre de calculs, et ne démontrent pas nécessairement une véritable adaptabilité intelligente.

De plus, les créateurs d'ARC-AGI ont été critiqués par leurs pairs, notamment concernant l'ambiguïté entourant la définition d'AGI. Un employé d'OpenAI a récemment déclaré que si l'AGI est définie comme une intelligence artificielle qui « fonctionne mieux que la plupart des humains dans la plupart des tâches », alors l'AGI a effectivement été atteinte. Cependant, Cholet et Knoop affirment que les conceptions existantes pour le benchmark ARC-AGI n'ont pas encore pleinement atteint cet objectif.

À l’avenir, Sholay et Knoop prévoient de publier un benchmark ARC-AGI de deuxième génération et organiseront un nouveau concours en 2025 pour combler les lacunes du test actuel. Ils ont déclaré que le nouveau référentiel se concentrera davantage sur la promotion du développement de la recherche sur l'IA dans une direction plus importante et sur l'accélération de la mise en œuvre de l'AGI.

Toutefois, corriger les références existantes n’est pas une tâche facile. Les efforts de Sholay et Knoop montrent que définir l'intelligence artificielle, en particulier dans le domaine de l'intelligence générale, reste une tâche difficile et complexe.

Dans l'ensemble, les progrès du benchmark ARC-AGI et les discussions connexes montrent que l'exploration de l'intelligence artificielle générale dans le domaine de l'intelligence artificielle est toujours en cours, avec à la fois des avancées et des défis à l'avenir, des définitions plus rigoureuses et une évaluation plus efficace. des méthodes sont nécessaires. Promouvoir un véritable développement de l’AGI.