Les modèles de langage visuel (VLM) ont fait des progrès significatifs dans le domaine de l'intelligence artificielle, mais sont encore confrontés à des défis dans le traitement d'images haute résolution et de textes divers. Les modèles existants utilisent souvent des encodeurs visuels statiques, qui sont inefficaces et manquent de précision sur différents ensembles de données. Le manque de diversité et de spécificité des tâches dans l'ensemble de données de formation limite également ses performances, en particulier dans les tâches spécialisées telles que l'interprétation de graphiques.

Avec le développement rapide de l’intelligence artificielle, l’intégration des capacités visuelles et linguistiques a conduit à des progrès révolutionnaires dans les modèles de langage visuel (VLM). Ces modèles sont conçus pour traiter et comprendre simultanément des données visuelles et textuelles et sont largement utilisés dans des scénarios tels que la description d'images, la réponse visuelle à des questions, la reconnaissance optique de caractères et l'analyse de contenu multimodale.

Les VLM ont joué un rôle important dans le développement de systèmes autonomes, d’une meilleure interaction homme-machine et d’outils efficaces de traitement de documents, comblant ainsi avec succès le fossé entre ces deux modalités de données. Cependant, de nombreux défis subsistent dans le traitement des données visuelles haute résolution et des diverses entrées de texte.

Les recherches actuelles ont partiellement résolu ces limitations, mais les encodeurs visuels statiques adoptés par la plupart des modèles manquent d'adaptabilité aux résolutions élevées et aux tailles d'entrée variables. Dans le même temps, la combinaison de modèles de langage pré-entraînés avec des encodeurs visuels entraîne souvent des inefficacités car ils ne sont pas optimisés pour les tâches multimodales. Bien que certains modèles introduisent des techniques de calcul éparses pour gérer la complexité, la précision sur différents ensembles de données reste insuffisante. De plus, les ensembles de données de formation des modèles existants manquent souvent de diversité et de spécificité des tâches, ce qui limite encore davantage leurs performances. Par exemple, de nombreux modèles fonctionnent mal dans des tâches spécialisées telles que l’interprétation de graphiques ou l’analyse de documents denses.

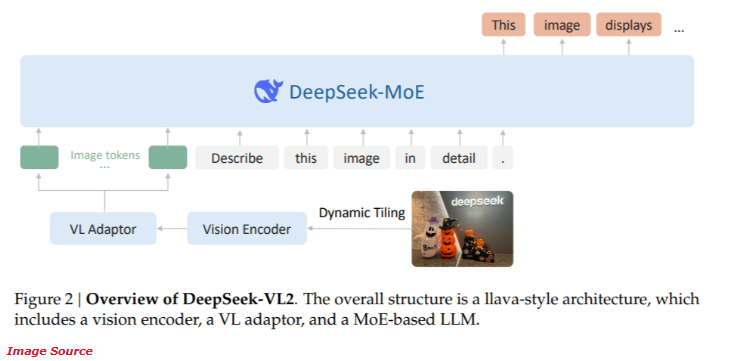

Récemment, DeepSeek-AI a lancé la nouvelle série DeepSeek-VL2 de modèles de langage visuel d'experts hybrides (MoE) open source. Cette série de modèles combine des technologies innovantes de pointe, notamment le découpage dynamique de l'encodage visuel, le mécanisme d'attention latente multi-têtes et le cadre DeepSeek-MoE.

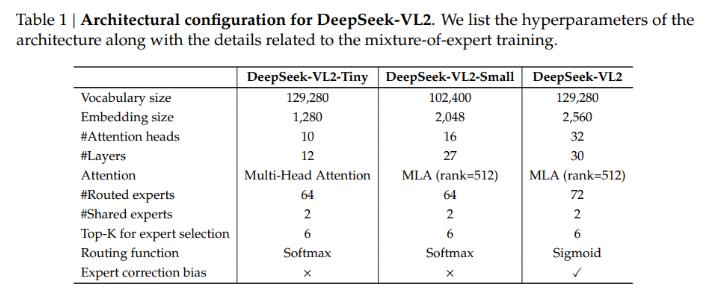

La série DeepSeek-VL2 propose trois configurations de paramètres différentes :

- DeepSeek-VL2-Tiny : 3,37 milliards de paramètres (1 milliard de paramètres d'activation)

- DeepSeek-VL2-Small : 16,1 milliards de paramètres (2,8 milliards de paramètres d'activation)

- DeepSeek-VL2 : 27,5 milliards de paramètres (4,5 milliards de paramètres d'activation)

Cette évolutivité garantit sa capacité à s’adapter aux différents besoins applicatifs et budgets informatiques.

L'architecture de DeepSeek-VL2 est conçue pour optimiser les performances tout en réduisant les exigences de calcul. La méthode de découpage dynamique garantit que les images haute résolution sont traitées sans perte de détails critiques, ce qui la rend idéale pour les tâches d'analyse de documents et de localisation visuelle. De plus, le mécanisme d'attention latente multi-têtes permet au modèle de traiter efficacement de grandes quantités de données textuelles, réduisant ainsi la surcharge de calcul généralement associée au traitement d'une entrée en langage dense. La formation de DeepSeek-VL2 couvre divers ensembles de données multimodales, lui permettant de bien fonctionner dans une variété de tâches telles que la reconnaissance optique de caractères, la réponse visuelle aux questions et l'interprétation de graphiques.

Selon les tests de performances, la configuration Small a atteint une précision de 92,3 % dans la tâche de reconnaissance optique de caractères, dépassant largement les modèles existants. Lors du test de référence de positionnement visuel, le modèle a amélioré la précision de 15 % par rapport au produit de la génération précédente.

Dans le même temps, DeepSeek-VL2 réduit les besoins en ressources informatiques de 30 % tout en conservant une précision de pointe. Ces résultats démontrent la supériorité de ce modèle dans le traitement d’images et de textes haute résolution.

Entrée du projet : https://huggingface.co/collections/deepseek-ai/deepseek-vl2-675c22accc456d3beb4613ab

Points forts:

La série DeepSeek-VL2 offre une variété de configurations de paramètres pour s'adapter aux différents besoins des applications.

La technologie de découpage dynamique améliore l’efficacité du traitement des images haute résolution et convient à l’analyse de documents complexes.

Le modèle fonctionne bien dans les tâches de reconnaissance optique de caractères et de localisation visuelle, avec une précision considérablement améliorée.

Les modèles de la série DeepSeek-VL2 ont apporté de nouvelles avancées dans le domaine des modèles de langage visuel grâce à leur architecture innovante et leurs excellentes performances. Ses avantages en matière de traitement d'images haute résolution et de traitement de texte complexe lui confèrent un grand potentiel dans de nombreux scénarios d'application et méritent une attention et des recherches plus approfondies.