IBM a annoncé le lancement de son grand modèle de langage open source Granite3.1 de nouvelle génération, visant à devenir leader dans le domaine de l'IA au niveau de l'entreprise. Granite3.1 présente de nombreux points forts, notamment une longueur de contexte étendue jusqu'à 128 Ko, des modèles d'intégration efficaces, des capacités de détection d'hallucinations intégrées et des performances globales considérablement améliorées. Selon IBM, son modèle Granite8B Instruct est le plus performant parmi les modèles open source de même échelle, surpassant des concurrents tels que Llama3.1 de Meta, Qwen2.5 et Gemma2 de Google. La sortie de ce nouveau modèle fait suite au lancement de Granite 3.0 en octobre, reflétant l'itération rapide et l'investissement continu d'IBM dans le domaine de l'IA générative, avec un chiffre d'affaires associé atteignant 2 milliards de dollars américains.

IBM a officiellement publié sa nouvelle génération de grand modèle de langage open source Granite3.1, s'efforçant d'occuper une position de leader dans le domaine de l'IA au niveau de l'entreprise. Cette série de modèles présente une longueur de contexte étendue de 128 Ko, des modèles intégrés, des capacités de détection d'hallucinations intégrées et des améliorations significatives des performances.

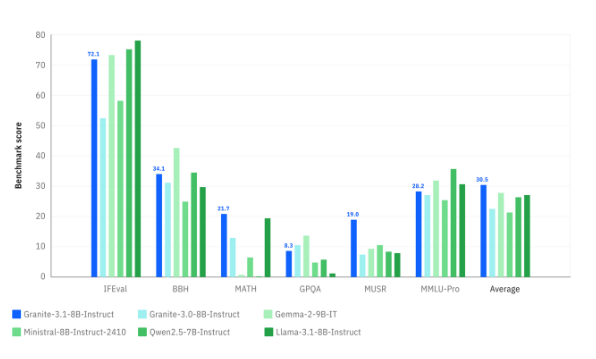

IBM affirme que le modèle Granite8B Instruct fonctionne mieux parmi les concurrents open source de même taille, notamment Llama3.1 de Meta, Qwen2.5 et Gemma2 de Google.

La sortie du modèle Granite3.1 intervient dans le contexte du lancement rapide par IBM de la série Granite3.0 dès octobre. IBM a révélé que ses revenus commerciaux liés à la génération d'IA ont atteint 2 milliards de dollars. L'idée principale de la nouvelle version est d'intégrer davantage de fonctionnalités dans un modèle plus petit afin qu'il puisse être exécuté plus facilement et de manière plus rentable pour les utilisateurs professionnels.

David Cox, vice-président d'IBM Research, a déclaré que le modèle Granite est largement utilisé dans les produits internes, les services de conseil et les services clients d'IBM, et qu'il est également publié sous forme open source, il doit donc atteindre un niveau élevé dans tous les aspects. L'évaluation des performances des modèles repose non seulement sur la rapidité mais également sur l'efficacité, permettant aux utilisateurs de gagner du temps lors de l'obtention des résultats.

En termes de longueur de contexte, l'amélioration de Granite3.1 est particulièrement évidente, s'étendant de la première version de 4K à 128K, ce qui est particulièrement important pour les utilisateurs d'IA d'entreprise, notamment en termes de génération améliorée de récupération (RAG) et d'IA d'agent intelligent. La longueur de contexte étendue permet au modèle de traiter des documents, des journaux et des conversations plus longs, lui permettant ainsi de mieux comprendre et répondre aux requêtes complexes.

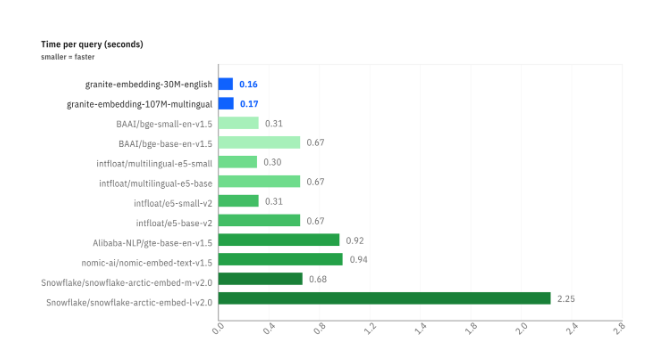

IBM a également lancé une série de modèles d'intégration pour accélérer le processus de conversion des données en vecteurs. Parmi eux, le temps de requête du modèle Granite-Embedding-30M-English est de 0,16 seconde, ce qui est plus rapide que celui des produits concurrents. Afin d'améliorer les performances de Granite3.1, IBM a innové dans le processus de formation en plusieurs étapes et dans l'utilisation de données de formation de haute qualité.

En termes de détection des hallucinations, le modèle Granite3.1 intègre une protection contre les hallucinations dans le modèle, qui peut s'auto-détecter et réduire les fausses sorties. Cette détection intégrée optimise l'efficacité globale et réduit le nombre d'appels d'inférence.

Actuellement, le modèle Granite3.1 est ouvert gratuitement aux utilisateurs d'entreprise et est fourni via le service d'IA d'entreprise Watsonx d'IBM. À l'avenir, IBM prévoit de maintenir un rythme de mises à jour rapide et Granite 3.2 lancera une fonctionnalité multimodale début 2025.

Blog officiel : https://www.ibm.com/new/announcements/ibm-granite-3-1-powerful-performance-long-context-and-more

Souligner:

IBM a lancé le modèle Granite3.1, dans le but de prendre une position de leader sur le marché des grands modèles de langage open source.

Le nouveau modèle prend en charge une longueur de contexte de 128 Ko, améliorant considérablement les capacités et l'efficacité du traitement.

Les capacités de détection d'illusion sont intégrées au modèle, optimisant les performances et la précision globales.

Dans l'ensemble, la sortie de Granite3.1 marque une autre avancée majeure pour IBM dans le domaine des grands modèles de langage open source. Ses performances puissantes et ses fonctions riches apporteront une expérience d'IA plus pratique et plus efficace aux utilisateurs d'entreprise. Les itérations futures méritent d’être attendues avec impatience.