La startup chinoise d'intelligence artificielle DeepSeek a publié son dernier modèle ultra-large DeepSeek-V3, qui est devenu le centre d'intérêt de l'industrie grâce à son code open source et ses performances puissantes. Avec des paramètres 671B et une architecture hybride experte, DeepSeek-V3 surpasse les principaux modèles open source dans plusieurs tests et fonctionne même de manière similaire à certains modèles fermés. Son innovation réside dans sa stratégie auxiliaire d'équilibrage de charge sans perte et sa technologie de prédiction multi-jetons, qui améliorent considérablement l'efficacité de la formation des modèles et la vitesse d'exécution. La sortie de DeepSeek-V3 marque une avancée majeure dans la technologie de l'IA open source, réduisant encore davantage l'écart avec l'IA à source fermée et ouvrant la voie au développement de l'intelligence artificielle générale (AGI).

Le 26 décembre 2024, la startup chinoise d'intelligence artificielle DeepSeek a publié son dernier modèle ultra-large DeepSeek-V3, connu pour sa technologie open source et ses défis innovants à la pointe des fournisseurs d'IA. DeepSeek-V3 possède 671B de paramètres et utilise une architecture composée d'experts pour activer des paramètres spécifiques afin de gérer une tâche donnée avec précision et efficacité. Selon les benchmarks fournis par DeepSeek, ce nouveau modèle a surpassé les principaux modèles open source, notamment le Llama3.1-405B de Meta, et présente des performances similaires aux modèles fermés d'Anthropic et d'OpenAI.

La sortie de DeepSeek-V3 marque une nouvelle réduction de l’écart entre l’IA open source et l’IA fermée. DeepSeek, qui a commencé comme une émanation du fonds spéculatif quantitatif chinois High-Flyer Capital Management, espère que ces développements ouvriront la voie à l'intelligence artificielle générale (AGI), où les modèles seront capables de comprendre ou d'apprendre n'importe quelle tâche intellectuelle qu'un humain peut accomplir. .

Les principales fonctionnalités de DeepSeek-V3 incluent :

Comme son prédécesseur DeepSeek-V2, le nouveau modèle est basé sur l'architecture de base de l'attention latente multi-têtes (MLA) et de DeepSeekMoE, garantissant une formation et une inférence efficaces.

La société a également lancé deux innovations : une stratégie auxiliaire d'équilibrage de charge sans perte et la prédiction multi-token (MTP), qui permet aux modèles de prédire simultanément plusieurs futurs jetons, améliorant ainsi l'efficacité de la formation et permettant aux modèles de s'exécuter trois fois plus rapidement, par génération de 60 jetons par seconde. .

Dans la phase de pré-formation, DeepSeek-V3 s'est entraîné sur des jetons diversifiés et de haute qualité de 14,8 T et a effectué une expansion de la longueur du contexte en deux étapes, et a finalement effectué une post-formation avec un réglage fin supervisé (SFT) et un apprentissage par renforcement (RL), pour aligner le modèle sur les préférences humaines et libérer davantage son potentiel.

Au cours de la phase de formation, DeepSeek utilise diverses optimisations matérielles et algorithmiques, notamment le cadre de formation à précision mixte FP8 et l'algorithme DualPipe pour la parallélisation des pipelines, réduisant ainsi les coûts de formation. L'ensemble du processus de formation de DeepSeek-V3 serait terminé en 2 788 000 heures GPU H800, soit environ 5,57 millions de dollars, ce qui est bien inférieur aux centaines de millions de dollars généralement dépensés pour la pré-formation de grands modèles de langage.

DeepSeek-V3 est devenu le modèle open source le plus puissant du marché. Plusieurs benchmarks réalisés par la société ont montré qu'il surpassait le GPT-4o à source fermée dans la plupart des benchmarks, à l'exception de SimpleQA et FRAMES, axés sur l'anglais, où le modèle OpenAI était en tête avec des scores de 38,2 et 80,5 respectivement (les scores DeepSeek-V3 sont de 24,9 et 73,3). respectivement). DeepSeek-V3 a obtenu des résultats particulièrement bons aux tests de chinois et de mathématiques, avec un score de 90,2 au test Math-500, suivi de 80 par Qwen.

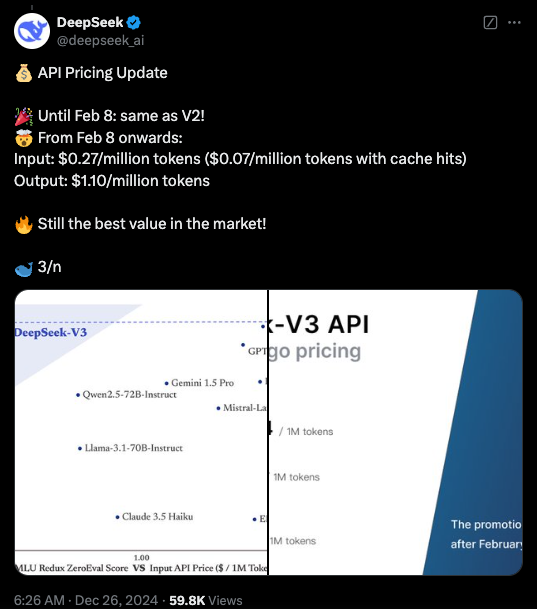

Actuellement, le code de DeepSeek-V3 est disponible sous licence MIT sur GitHub, et le modèle est fourni sous la licence de modèle de l'entreprise. Les entreprises peuvent également tester de nouveaux modèles via DeepSeek Chat, une plateforme similaire à ChatGPT, et accéder aux API à des fins commerciales. DeepSeek fournira l'API au même prix que DeepSeek-V2 jusqu'au 8 février. Après cela, des frais de 0,27 $ par million de jetons d'entrée (0,07 $ par million de jetons pour les accès au cache) et de 1,10 $ par million de jetons de sortie seront facturés.

Souligner:

DeepSeek-V3 est sorti, avec des performances dépassant Llama et Qwen.

Adoptez les paramètres 671B et l’architecture hybride experte pour améliorer l’efficacité.

Les innovations incluent des stratégies d'équilibrage de charge sans perte et une prédiction multi-jetons pour une vitesse améliorée.

Les coûts de formation sont considérablement réduits, favorisant le développement de l’IA open source.

L'open source et les hautes performances de DeepSeek-V3 auront un impact profond sur le domaine de l'intelligence artificielle, favoriseront le développement de la technologie d'IA open source et favoriseront son application dans divers domaines. DeepSeek continuera à travailler au développement de modèles d'IA plus avancés et à contribuer à la réalisation de l'AGI. À l’avenir, nous avons des raisons d’attendre davantage de percées de DeepSeek.