L'équipe de Kunlun Wanwei Yan Shuicheng a collaboré avec l'Université technologique de Nanyang à Singapour pour lancer un projet révolutionnaire appelé Q*, qui vise à améliorer considérablement les capacités de raisonnement des petits modèles de langage. Contrairement à d'autres grands modèles de langage sur le marché, Q* se concentre sur l'amélioration des performances des petits modèles, rendant ses capacités de raisonnement comparables à celles des modèles avec des paramètres des dizaines, voire des centaines de fois plus grands. Ce résultat de recherche devrait modifier les limites des petits modèles dans les applications pratiques et apporter de nouvelles opportunités de développement dans le domaine de l’intelligence artificielle. Grâce à des algorithmes innovants, Q* a considérablement amélioré les capacités de raisonnement des petits modèles et obtenu d'excellents résultats, surpassant les grands modèles dans plusieurs tests de référence.

Récemment, l'équipe nationale de Kunlun Wanwei Yan Shuicheng et l'équipe de recherche de l'Université technologique de Nanyang à Singapour ont publié un projet appelé Q*, visant à améliorer les capacités de raisonnement des petits modèles. Ce projet est différent d'OpenAI, mais il peut permettre à de petits modèles d'atteindre les capacités de raisonnement de modèles avec des paramètres des dizaines, voire des centaines de fois, plus grands que lui.

L'équipe de recherche a obtenu des résultats remarquables grâce aux performances expérimentales de l'algorithme Q* : sur l'ensemble de données GSM8K, Q* a aidé Llama-2-7b à améliorer sa précision à 80,8 %, surpassant ChatGPT.

Sur l'ensemble de données MATH, Q* a aidé DeepSeek-Math-7b à atteindre une précision de 55,4 %, surpassant Gemini Ultra.

Sur l'ensemble de données MBPP, Q * a aidé CodeQwen1.5-7b-Chat à augmenter la précision à 77,0 %, réduisant ainsi l'écart de niveau de programmation avec GPT-4. Ces résultats montrent le potentiel de l’algorithme Q* pour améliorer les capacités de raisonnement des petits modèles.

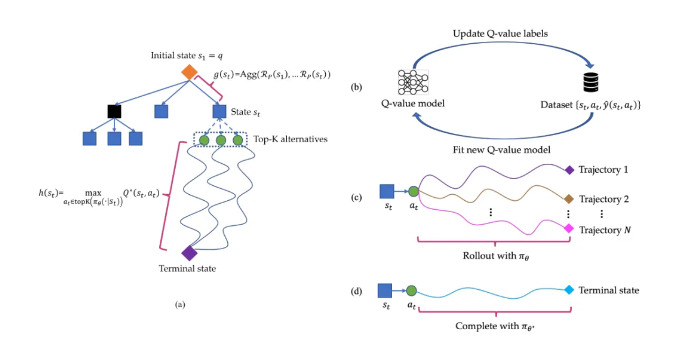

Le principe de fonctionnement de l'algorithme Q* consiste à décomposer la trajectoire de raisonnement du grand modèle de langage en plusieurs états, à effectuer une planification globale pour chaque état et à utiliser l'algorithme de recherche A* pour réaliser une recherche prioritaire de tâches de raisonnement complexes. Dans le même temps, ils ont également formé un modèle de valeur Q d'agent par le biais d'un apprentissage supervisé pour obtenir la valeur Q optimale de la paire état-action, améliorant ainsi les performances du modèle.

Souligner:

Le projet Q* n'est pas publié par OpenAI. Grâce à l'algorithme de l'équipe de recherche, la capacité de raisonnement du petit modèle a été grandement améliorée.

Le projet a obtenu des résultats expérimentaux remarquables sur plusieurs ensembles de données, démontrant le potentiel et l'efficacité de l'algorithme Q*.

Lien papier : https://arxiv.org/abs/2406.14283

Les résultats de recherche du projet Q* ouvrent une nouvelle direction pour le développement de petits modèles. Son algorithme efficace et son effet d'amélioration significatif méritent l'attention. À l’avenir, cet algorithme devrait être appliqué dans davantage de domaines et favoriser l’avancement de la technologie de l’intelligence artificielle. Un lien vers l'article a été fourni pour que les lecteurs intéressés puissent en savoir plus.