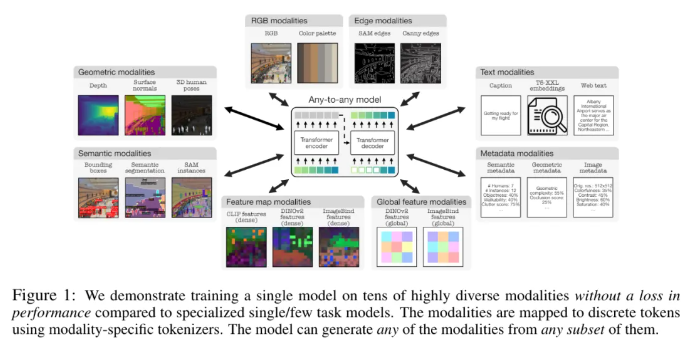

Apple et l'École Polytechnique Fédérale de Lausanne (EPFL) en Suisse ont collaboré pour développer un modèle multimodal révolutionnaire, 4M-21. Le modèle peut être formé sur 21 modalités différentes, ses performances sont nettement meilleures que celles des modèles existants et il réalise de multiples fonctions telles que la récupération multimodale et la génération contrôlable. Cette recherche a considérablement amélioré les performances et l'adaptabilité du modèle en élargissant la taille du modèle et de l'ensemble de données, en augmentant le type et le nombre de modalités de formation et en adoptant une stratégie de formation conjointe. Le modèle 4M-21 adopte une architecture d'encodeur-décodeur basée sur Transformer et ajoute des intégrations modales supplémentaires pour s'adapter aux nouvelles modalités. Son processus de formation prend pleinement en compte les caractéristiques des différentes modalités et utilise une méthode de tokenisation spécifique pour le modal.

Cette étude a adopté une solution de pré-formation 4M, qui peut améliorer les performances et l'adaptabilité du modèle en augmentant la taille du modèle et des ensembles de données, en augmentant le type et le nombre de modalités impliquées dans la formation du modèle et en organisant une formation conjointe sur plusieurs ensembles de données. Les chercheurs utilisent différentes méthodes de tokenisation pour discrétiser les modalités avec différentes caractéristiques, telles que les intégrations d'images globales, les poses humaines et les instances sémantiques. En termes de sélection d'architecture, cette étude adopte l'architecture d'encodeur-décodeur 4M basée sur Transformer et ajoute des intégrations modales supplémentaires pour s'adapter aux nouvelles modalités.

Ce modèle peut non seulement effectuer une série de tâches de vision courantes, telles que l'estimation de la normale et de la profondeur de la surface DIODE, la segmentation sémantique et des instances COCO, l'estimation de la pose humaine 3DPW3D, etc., il peut également générer des modalités d'entraînement arbitraires et prendre en charge plusieurs Des méthodes de génération à grain fin et multimodal sont effectuées, et des images RVB ou d'autres modalités peuvent être récupérées en utilisant d'autres modalités comme requêtes. En outre, les chercheurs ont également mené des expériences de transmission multimodale sur NYUv2, la segmentation sémantique Hypersim et ARKitScenes.

Ses caractéristiques fonctionnelles importantes comprennent :

Modalités Any-to-any : Augmentation de 7 modalités du meilleur modèle any-to-any existant à 21 modalités différentes, permettant une récupération multimodale, une génération contrôlable et de puissantes performances prêtes à l'emploi.

Prise en charge de la diversité : ajoutez la prise en charge de données plus structurées telles que les poses humaines, les instances SAM, les métadonnées, etc.

Tokenisation : étudiez la tokenisation discrète pour différentes modalités à l'aide de méthodes spécifiques aux modalités, telles que l'intégration d'images globales, les poses humaines et les instances sémantiques.

Mise à l'échelle : étendez la taille du modèle à 3 B de paramètres et l'ensemble de données à 0,5 B d'échantillons.

Formation collaborative : formation collaborative sur la vision et le langage en même temps.

Adresse papier : https://arxiv.org/pdf/2406.09406

Points forts:

- Des chercheurs d'Apple et de l'École Polytechnique Fédérale de Lausanne (EPFL) en Suisse ont développé conjointement un modèle unique de modalité any-to-any qui peut être formé dans 21 modalités différentes.

- Le modèle peut effectuer une gamme de tâches de vision courantes dès le départ et est également capable de générer des modalités de formation arbitraires, prenant en charge plusieurs méthodes pour effectuer une génération fine et multimodale.

- Les chercheurs ont également mené des expériences de transmission multimodale sur NYUv2, la segmentation sémantique Hypersim et ARKitScenes.

Dans l’ensemble, le modèle 4M-21 a réalisé des progrès significatifs dans le domaine de la recherche multimodale. Ses performances puissantes et ses vastes perspectives d’application ouvrent une nouvelle direction pour le développement futur de l’intelligence artificielle multimodale. L’open source et les applications futures de ce modèle méritent d’être attendues.