Des équipes de recherche de l'Université de Nanjing, de l'Université de Fudan et du laboratoire Noah's Ark de Huawei ont réalisé des avancées majeures dans le domaine des humains numériques 3D, résolvant les problèmes de cohérence multi-vues et d'expressivité émotionnelle insuffisantes dans les méthodes existantes. Ils ont développé une nouvelle méthode qui permet la synthèse d'avatars parlants 3D avec des émotions contrôlables et permet d'améliorer considérablement la synchronisation labiale et la qualité du rendu. Les résultats de la recherche sont basés sur le nouvel ensemble de données EmoTalk3D, qui contient des vidéos multi-vues calibrées, des annotations émotionnelles et des informations géométriques 3D image par image, et a été rendu public à des fins de recherche non commerciale. Grâce au cadre de cartographie « de la parole à la géométrie en passant par l'apparence », cette méthode capture avec précision les expressions faciales subtiles et permet d'obtenir un rendu haute fidélité sous des angles de vision libres.

Entrée du produit : https://nju-3dv.github.io/projects/EmoTalk3D/

Ils ont collecté l'ensemble de données EmoTalk3D avec des vidéos multi-vues calibrées, des annotations d'émotion et une géométrie 3D image par image. Et une nouvelle méthode de synthèse d'avatars parlants 3D avec des émotions contrôlables est proposée, avec des améliorations significatives en termes de synchronisation labiale et de qualité de rendu.

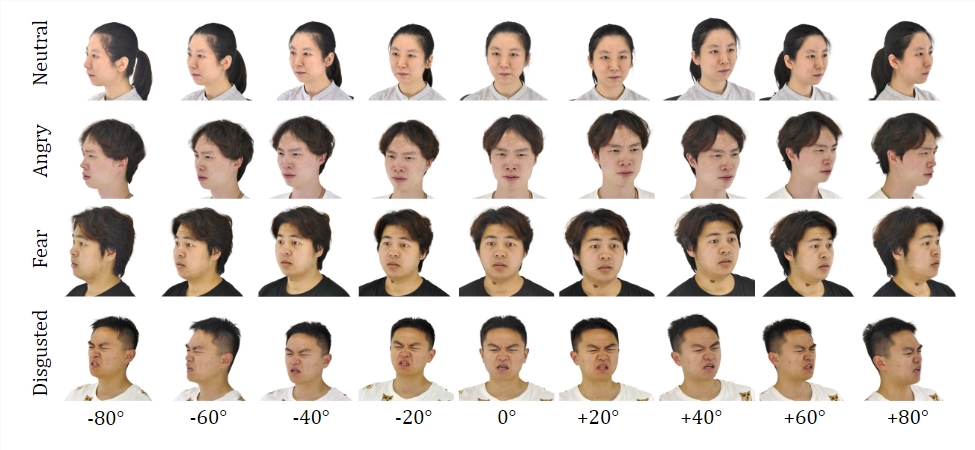

Ensemble de données :

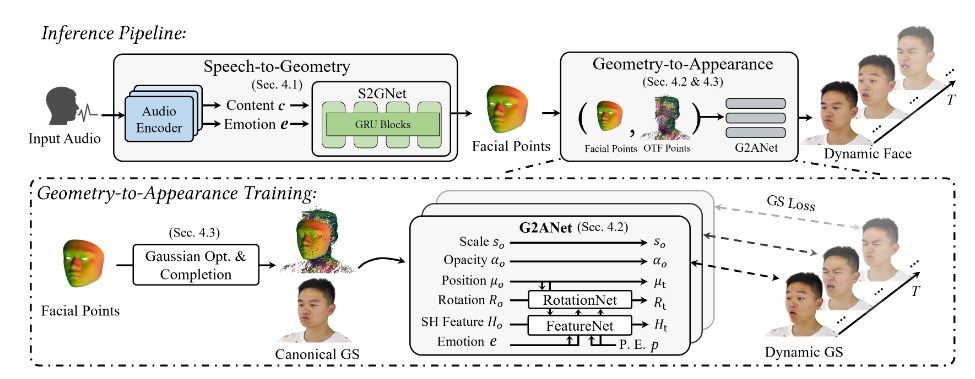

En s'entraînant sur l'ensemble de données EmoTalk3D, l'équipe de recherche a construit un cadre de cartographie « de la parole à la géométrie en passant par l'apparence ». Une séquence géométrique 3D réaliste est d'abord prédite à partir de caractéristiques audio, puis l'apparence d'une tête parlante 3D représentée par une gaussienne 4D est synthétisée sur la base de la géométrie prédite. Les apparences sont ensuite décomposées en gaussiennes standard et dynamiques, apprises à partir de vidéos multi-vues et fusionnées pour restituer des animations de tête parlante en vue libre.

Le modèle permet de contrôler les émotions dans les avatars parlants générés et de les restituer sous une large gamme d'angles de vision. Démonstration d'une qualité de rendu et d'une stabilité améliorées dans la génération du mouvement des lèvres tout en capturant des détails dynamiques du visage tels que les rides et les expressions subtiles. Dans l’exemple des résultats générés, les expressions heureuses, en colère et frustrées de l’humain numérique 3D sont affichées avec précision.

Son processus global comprend cinq modules :

Le premier est un codeur de décomposition de contenu émotionnel, qui analyse le contenu et les caractéristiques émotionnelles de la parole d'entrée ; le second est un réseau parole-géométrie, qui prédit des nuages de points 3D dynamiques à partir des caractéristiques ; le troisième est un module d'optimisation et de complétion gaussienne à établir ; une apparence standard ; le quatrième est la géométrie à l'apparence. Le réseau synthétise l'apparence du visage basée sur un nuage de points 3D dynamique ; le cinquième est le module de rendu, qui rend la gaussienne dynamique en animation en vue libre.

De plus, ils ont construit l'ensemble de données EmoTalk3D, un ensemble de données de têtes parlantes multi-vues annotées avec des émotions avec des formes faciales 3D image par image, qui sera mis à la disposition du public à des fins de recherche non commerciales.

Points forts:

Proposer une nouvelle méthode pour synthétiser des humains numériques avec des émotions contrôlables.

Créez un cadre de cartographie allant de la parole à la géométrie en passant par l'apparence.

L'ensemble de données EmoTalk3D est établi et prêt à être ouvert.

Cette recherche ouvre une nouvelle direction pour le développement de la technologie humaine numérique 3D. Les méthodes et les ensembles de données proposés fourniront des ressources précieuses pour les recherches futures et favoriseront le développement d'une technologie humaine numérique 3D plus réaliste et plus expressive sur le plan émotionnel. L’ouverture du jeu de données EmoTalk3D favorise également la coopération et les échanges au sein de la communauté académique.