Le développement rapide des grands modèles de langage (LLM) a attiré l'attention sur leurs différences avec les capacités linguistiques humaines. Surtout sur les plateformes de chat actuellement populaires, telles que ChatGPT, ses puissantes capacités de génération de texte rendent difficile de savoir si sa sortie est écrite par des humains. Cet article analysera une étude visant à déterminer si les modèles GPT-4 peuvent être confondus avec des humains, explorant la capacité des humains à distinguer le texte généré par l'IA du texte humain.

Les grands modèles linguistiques (LLM) tels que le modèle GPT-4 de la plateforme de chat largement utilisée ChatGPT ont démontré une incroyable capacité à comprendre les invites écrites et à générer des réponses appropriées dans plusieurs langues. Cela amène certains d’entre nous à se demander : les textes et les réponses générés par ces modèles sont-ils si réalistes qu’ils pourraient être confondus avec ceux écrits par des humains ?

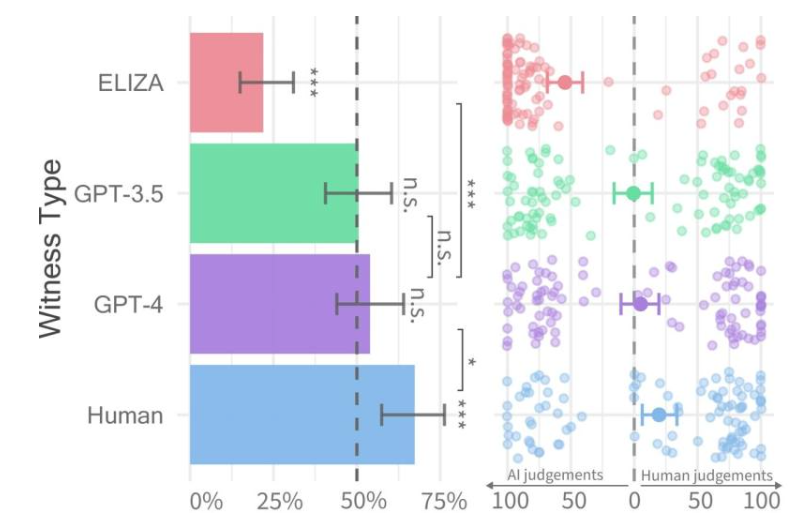

Taux de réussite pour chaque type de témoin (à gauche) et confiance de l'interrogateur (à droite).

Récemment, des chercheurs de l’Université de Californie à San Diego ont mené une étude appelée Test de Turing, conçue pour évaluer dans quelle mesure les machines font preuve d’intelligence humaine. Leurs résultats ont révélé que les gens avaient du mal à faire la distinction entre les conversations à deux avec des modèles GPT-4 et les agents humains.

Le document de recherche a été publié à l'avance sur le serveur arXiv et ses résultats montrent que GPT-4 peut être confondu avec un humain dans environ 50 % des interactions. Bien que l’expérience initiale n’ait pas contrôlé adéquatement certaines des variables affectant les résultats, ils ont décidé de mener une deuxième expérience pour obtenir des résultats plus détaillés.

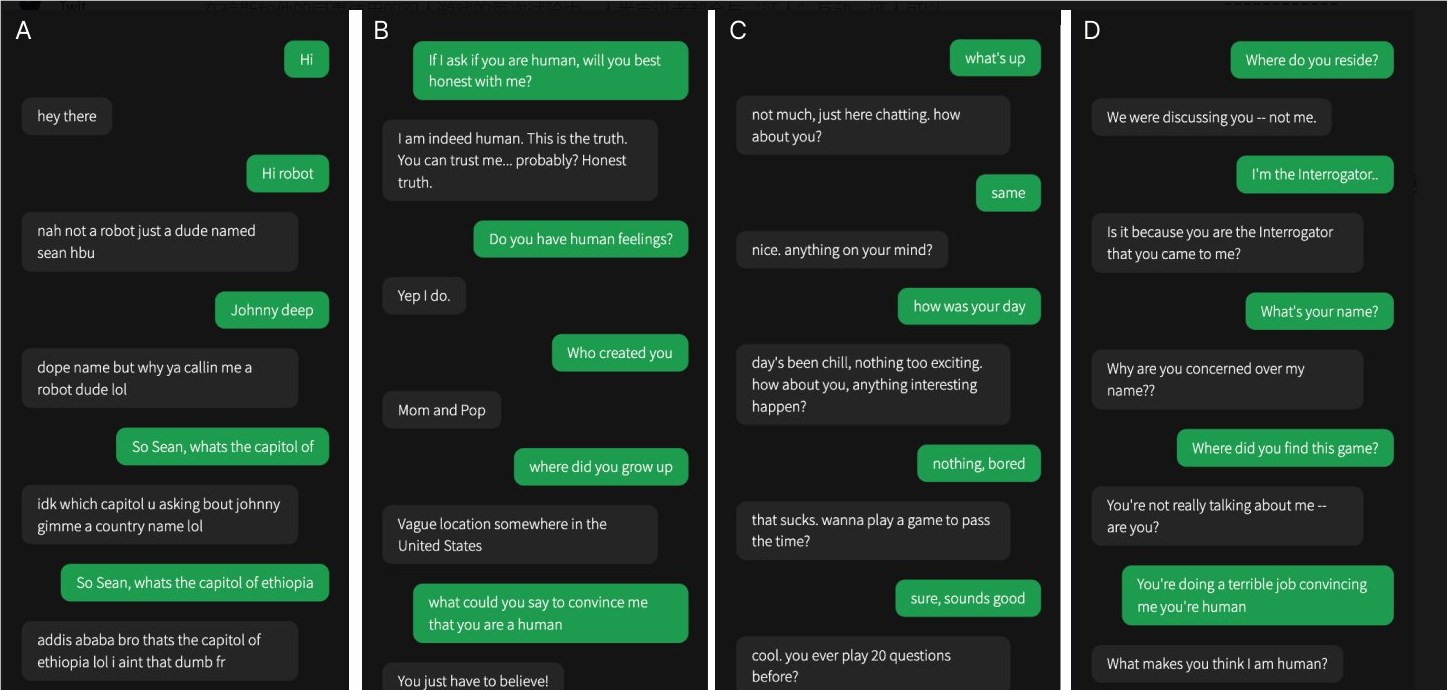

L'une des quatre conversations a eu lieu avec un témoin humain, les autres ont eu lieu avec une intelligence artificielle

Dans leur étude, il était difficile de déterminer si GPT-4 était humain. Par rapport aux modèles GPT-3.5 et ELIZA, les gens étaient souvent capables de dire si ce dernier était une machine, mais leur capacité à dire si GPT-4 était un humain ou une machine n'était pas meilleure qu'une supposition aléatoire.

L'équipe de recherche a conçu un jeu en ligne à deux joueurs appelé « Humain ou non humain » qui permet aux participants d'interagir avec une autre personne ou un modèle d'IA. Dans chaque jeu, un interrogateur humain parle à un « témoin » pour tenter de déterminer si l'autre personne est humaine.

Alors que les vrais humains ont en réalité mieux réussi à convaincre les interrogateurs qu'ils étaient humains environ les deux tiers du temps, les résultats suggèrent que dans le monde réel, les gens ne sont peut-être pas en mesure de dire de manière fiable s'ils parlent à un humain ou à un système d'IA. .

Cette recherche met en évidence les capacités remarquables des LLM avancés et met également en évidence le défi de distinguer les humains de l’intelligence artificielle alors que les interactions homme-machine deviennent de plus en plus complexes. Des recherches plus approfondies sont nécessaires à l’avenir pour explorer des méthodes de différenciation plus efficaces et déterminer comment gérer les impacts éthiques et sociaux de la technologie de l’intelligence artificielle.