Avec le développement rapide des grands modèles de langage multimodaux (MLLM), l’intégration efficace des modalités visuelles, linguistiques et vocales est devenue un point chaud de la recherche. Cependant, les défis posés par les différences essentielles entre les différentes données modales, telles que les informations spatiales de la vision et les informations chronologiques de la parole, entravent une interaction multimodale efficace. Les méthodes existantes reposent souvent sur des modules ASR et TTS indépendants, ce qui augmente la latence et réduit la fluidité de l'interaction. Cet article présente VITA-1.5, un modèle linguistique multimodal à grande échelle qui intègre la vision, le langage et la parole, visant à résoudre ces problèmes.

Récemment, des progrès significatifs ont été réalisés dans les grands modèles de langage multimodaux (MLLM), notamment dans l'intégration de modalités visuelles et textuelles. Cependant, avec la popularité croissante de l’interaction homme-machine, l’importance des modalités de parole est devenue de plus en plus importante, notamment dans les systèmes de dialogue multimodaux. La voix n’est pas seulement un moyen clé de transmission de l’information, mais elle améliore également considérablement le naturel et la commodité des interactions.

Cependant, en raison des différences essentielles entre les données visuelles et vocales, les intégrer dans MLLM n’est pas anodin. Par exemple, les données visuelles transmettent des informations spatiales, tandis que les données vocales transmettent des changements dynamiques dans les séries temporelles. Ces différences fondamentales posent des défis pour l'optimisation simultanée des deux modalités, conduisant souvent à des conflits au cours du processus de formation. De plus, les systèmes de synthèse vocale traditionnels s'appuient sur des modules distincts de reconnaissance automatique de la parole (ASR) et de synthèse vocale (TTS), ce qui augmente la latence et réduit la cohérence, limitant ainsi leur utilité dans les applications en temps réel.

Pour relever ces défis, les chercheurs ont lancé VITA-1.5, un modèle linguistique multimodal à grande échelle qui intègre la vision, le langage et la parole. VITA-1.5 utilise une méthode de formation en trois étapes soigneusement conçue pour introduire progressivement des données visuelles et vocales afin d'atténuer les conflits modaux tout en maintenant de solides performances multimodales.

Dans la première étape, le modèle se concentre sur la formation visuo-linguistique, en développant de solides capacités visuelles en formant des adaptateurs visuels et en affinant le modèle à l'aide de légendes descriptives et de données visuelles de questions et réponses.

La deuxième étape introduit le traitement de l'entrée audio, en entraînant l'encodeur audio à l'aide de données appariées de transcription vocale, puis en l'affinant à l'aide de données de questions et réponses vocales, afin que le modèle puisse comprendre et répondre efficacement à l'entrée audio. Enfin, dans la troisième étape, le décodeur audio est formé pour obtenir une sortie vocale de bout en bout sans avoir recours à des modules TTS externes, permettant ainsi à VITA-1.5 de générer des réponses vocales fluides et d'améliorer le naturel et l'interactivité du dialogue multimodal. systèmes.

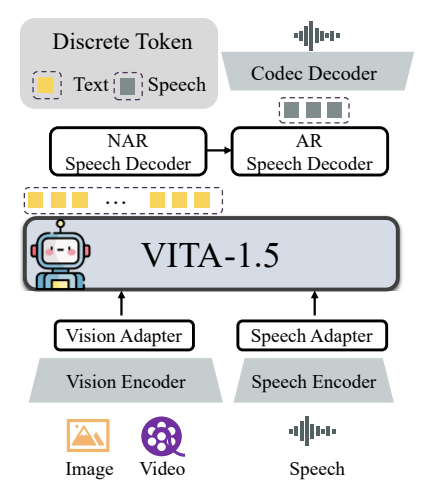

L'architecture globale de VITA-1.5 comprend des encodeurs et des adaptateurs visuels et audio pour se connecter à de grands modèles de langage. La sortie dispose d'un module de génération vocale de bout en bout au lieu d'utiliser un modèle TTS externe comme la version originale VITA-1.0. L'encodeur visuel utilise InternViT-300M, la taille de l'image d'entrée est de 448 × 448 pixels et chaque image génère 256 jetons visuels.

Pour les images haute résolution, VITA-1.5 adopte une stratégie de correction dynamique pour capturer les détails locaux. La vidéo est traitée comme un type d'entrée multi-images spécial, avec des images échantillonnées en fonction de la durée de la vidéo. Le module de codage audio se compose de plusieurs couches convolutives de sous-échantillonnage et de 24 blocs Transformer, avec une fréquence d'images de sortie de 12,5 Hz. L'adaptateur audio se compose de plusieurs couches convolutives avec un sous-échantillonnage 2x. TiCodec est utilisé comme modèle de codec, qui code un signal vocal continu en jetons vocaux discrets avec une fréquence de 40 Hz et est capable de les décoder en un signal vocal avec un taux d'échantillonnage de 24 000 Hz. Pour permettre au modèle de générer des jetons vocaux, deux décodeurs vocaux sont ajoutés après les jetons texte : un décodeur vocal non autorégressif (NAR) et un décodeur vocal autorégressif (AR).

Les données d'entraînement de VITA-1.5 couvrent un large éventail de catégories, telles que les données de sous-titres et les données de questions et réponses, y compris le chinois et l'anglais. À différentes étapes de formation, des sous-ensembles de l'ensemble de données sont échantillonnés de manière sélective pour servir différents objectifs. La stratégie de formation se déroule en trois étapes :

La première phase : la formation visuo-linguistique, comprenant l'alignement visuel, la compréhension visuelle et le réglage visuel supervisé, vise à combler le fossé entre la vision et le langage et à permettre au modèle de comprendre le contenu de l'image et de répondre aux questions visuelles.

Phase 2 : Le réglage de l'entrée audio, y compris l'alignement audio et le réglage fin supervisé de l'audio, est conçu pour permettre au modèle de comprendre l'entrée audio et d'interagir via des questions vocales et des réponses textuelles.

La troisième étape : le réglage de la sortie audio, y compris la formation des codecs et la formation du décodeur NAR + AR, est conçu pour permettre au modèle de générer une sortie vocale et d'obtenir une interaction vocale de bout en bout.

Les chercheurs ont mené une évaluation approfondie de divers critères de compréhension des images, des vidéos et de la parole et ont comparé les résultats avec des modèles open source et propriétaires. Les résultats montrent que VITA-1.5 présente des capacités de perception et de raisonnement comparables à celles du MLLM leader sur les tâches d'image et de vidéo, et permet d'obtenir des améliorations significatives des capacités vocales. Par exemple, sur le benchmark de compréhension d'images, VITA-1.5 est comparable aux modèles open source de pointe et dépasse même certains modèles fermés. En termes de compréhension vidéo, VITA-1.5 fonctionne à égalité avec les meilleurs modèles open source. De plus, VITA-1.5 a atteint une précision de pointe dans les tâches ASR en chinois et en anglais, surpassant les modèles vocaux professionnels.

Dans l'ensemble, VITA-1.5 intègre avec succès la vision et la parole grâce à une stratégie de formation en trois étapes soigneusement conçue, permettant d'obtenir de solides capacités de compréhension visuelle et vocale, permettant une interaction parole-parole efficace sans recourir à un module ASR ou TTS séparé. Cette recherche devrait promouvoir l’avancement des modèles open source dans le domaine de l’interaction multimodale en temps réel.

Adresse du projet : https://github.com/VITA-MLLM/VITA

L'émergence de VITA-1.5 marque une nouvelle étape dans le développement de modèles de langage multimodaux à grande échelle. Ses capacités de génération de parole de bout en bout et ses excellentes performances dans les tâches de compréhension d'images, de vidéos et de parole permettront de créer un environnement plus naturel et plus fluide. modèle de langage multimodal pour l'avenir. Les systèmes interactifs dynamiques offrent de nouvelles possibilités. Ce résultat de recherche mérite attention et devrait jouer un rôle important dans les applications pratiques.