Ces dernières années, la demande de modèles d’IA légers a augmenté, en particulier sur les plates-formes aux ressources limitées telles que les appareils mobiles et les ordinateurs personnels. Comment réduire la taille des modèles et les coûts de calcul tout en garantissant les performances est devenu une direction de recherche importante. Cet article présentera le SmolVLM récemment publié par Hugging Face, un modèle de langage visuel à paramètres 2B conçu spécifiquement pour l'inférence côté appareil. Il a réalisé des avancées significatives en termes de vitesse et d'efficacité et fournit des solutions pour l'application de tâches de langage visuel sur des ressources limitées. appareils. De nouvelles possibilités.

Ces dernières années, il y a eu une demande croissante pour l’application de modèles d’apprentissage automatique aux tâches de vision et de langage, mais la plupart des modèles nécessitent d’énormes ressources informatiques et ne peuvent pas fonctionner efficacement sur des appareils personnels. Les petits appareils, notamment les ordinateurs portables, les GPU grand public et les appareils mobiles, sont confrontés à d'énormes défis lors du traitement des tâches de langage visuel.

En prenant Qwen2-VL comme exemple, bien qu'il ait d'excellentes performances, il a des exigences matérielles élevées, ce qui limite sa facilité d'utilisation dans les applications en temps réel. Par conséquent, développer des modèles légers fonctionnant avec moins de ressources est devenu un besoin important.

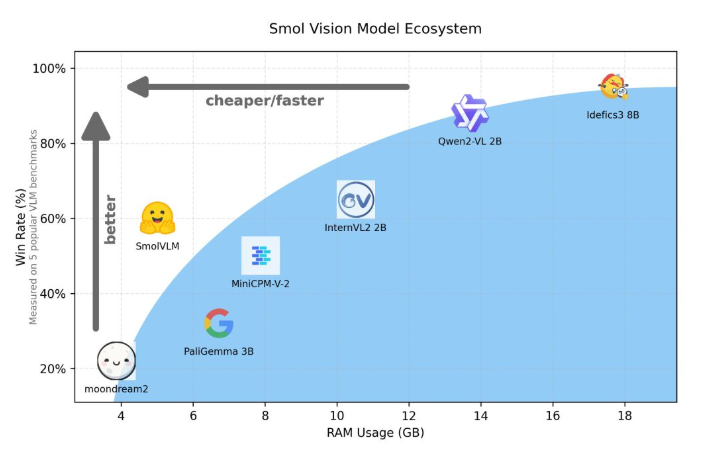

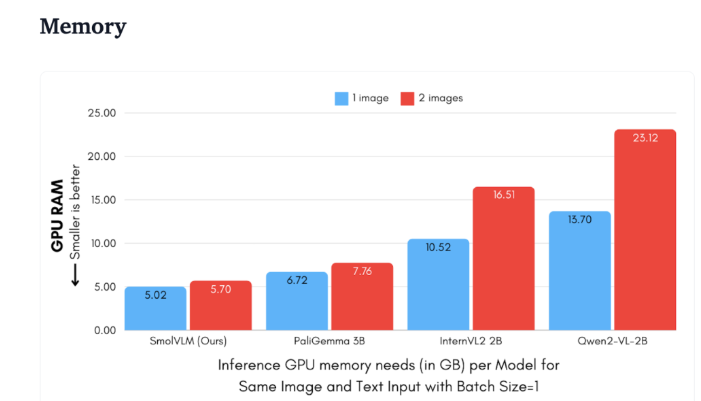

Hugging Face a récemment publié SmolVLM, un modèle de langage visuel à paramètres 2B spécialement conçu pour le raisonnement côté appareil. SmolVLM surpasse les autres modèles similaires en termes d'utilisation de la mémoire GPU et de vitesse de génération de jetons. Sa principale caractéristique est la capacité de fonctionner efficacement sur des appareils plus petits, tels que des ordinateurs portables ou des GPU grand public, sans sacrifier les performances. SmolVLM trouve un équilibre idéal entre performances et efficacité, résolvant des problèmes difficiles à surmonter dans les modèles similaires précédents.

Par rapport à Qwen2-VL2B, SmolVLM génère des jetons 7,5 à 16 fois plus rapidement, grâce à son architecture optimisée, qui permet une inférence légère. Cette efficacité apporte non seulement des avantages pratiques aux utilisateurs finaux, mais améliore également considérablement l'expérience utilisateur.

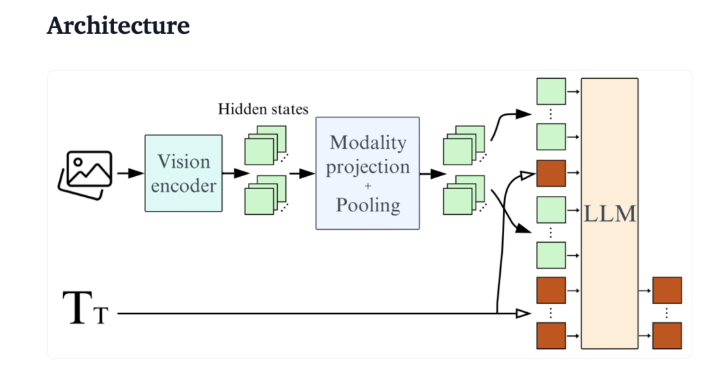

D'un point de vue technique, SmolVLM dispose d'une architecture optimisée qui prend en charge une inférence efficace côté appareil. Les utilisateurs peuvent même facilement effectuer des réglages précis sur Google Colab, abaissant considérablement le seuil d'expérimentation et de développement.

En raison de sa faible empreinte mémoire, SmolVLM est capable de fonctionner sans problème sur des appareils qui n'étaient auparavant pas en mesure d'héberger des modèles similaires. Lors du test d'une vidéo YouTube de 50 images, SmolVLM a obtenu de bons résultats, avec un score de 27,14 %, et a surpassé les deux modèles les plus gourmands en ressources en termes de consommation de ressources, démontrant sa forte adaptabilité et flexibilité.

SmolVLM constitue une étape importante dans le domaine des modèles de langage visuel. Son lancement permet d'exécuter des tâches de langage visuel complexes sur des appareils quotidiens, comblant ainsi une lacune importante dans les outils d'IA actuels.

SmolVLM excelle non seulement en termes de rapidité et d'efficacité, mais fournit également aux développeurs et aux chercheurs un outil puissant pour faciliter le traitement du langage visuel sans dépenses matérielles coûteuses. À mesure que la technologie de l’IA continue de gagner en popularité, des modèles tels que SmolVLM rendront plus accessibles les puissantes capacités d’apprentissage automatique.

démo :https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

Souligner:

SmolVLM est un modèle de langage visuel à paramètres 2B lancé par Hugging Face spécialement conçu pour le raisonnement côté appareil. Il fonctionne efficacement et ne nécessite pas de matériel haut de gamme.

Sa vitesse de génération de jetons est 7,5 à 16 fois supérieure à celle de modèles similaires, améliorant considérablement l'expérience utilisateur et l'efficacité des applications.

Lors du test, SmolVLM a démontré une forte adaptabilité et a pu obtenir de bons scores même sans formation sur les données vidéo.

L'émergence de SmolVLM marque une avancée importante dans le développement léger de modèles de langage visuel. Elle améliore non seulement l'expérience utilisateur, mais fournit également aux développeurs et aux chercheurs des outils plus pratiques. À l’avenir, des modèles efficaces et légers comme SmolVLM joueront un rôle dans davantage de scénarios et favoriseront une application plus large de la technologie de l’intelligence artificielle.