Les grands modèles de langage (LLM) ont montré des capacités étonnantes dans de nombreux domaines. Cependant, une dernière étude a révélé leurs « étranges » faiblesses dans le raisonnement arithmétique : ces IA « géniales » commettent fréquemment des erreurs dans des opérations mathématiques simples ! Les chercheurs ont mené une analyse approfondie de plusieurs LLM tels que Llama3, Pythia et GPT-J et ont découvert qu'ils ne s'appuyaient pas sur des algorithmes puissants ou sur une mémoire pour les calculs, mais adoptaient une stratégie de « méli-mélo heuristique », tout comme une stratégie qui s'appuie sur sur les « petites astuces » et les « règles empiriques » pour les étudiants qui obtiennent des réponses.

Récemment, les grands modèles de langage d'IA (LLM) ont bien fonctionné dans diverses tâches, notamment l'écriture de poésie, l'écriture de code et le chat. Mais, pouvez-vous le croire ? se renversent souvent lors de la résolution de problèmes arithmétiques simples, ce qui est surprenant.

Une dernière étude a révélé le secret « étrange » derrière les capacités de raisonnement arithmétique de LLM : ils ne s'appuient ni sur des algorithmes puissants ni sur la mémoire, mais adoptent une stratégie appelée « méli-mélo heuristique » ! mais s'appuie sur un peu d'intelligence et de « règles empiriques » pour obtenir la réponse.

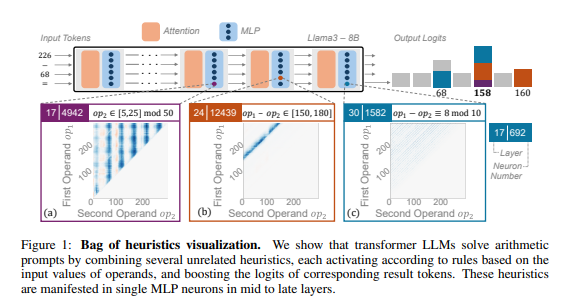

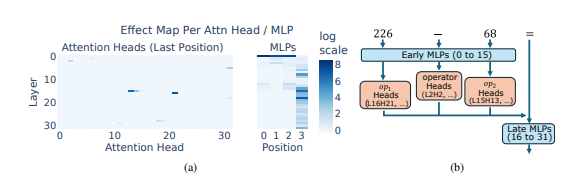

Les chercheurs ont utilisé le raisonnement arithmétique comme tâche typique et ont mené une analyse approfondie de plusieurs LLM tels que Llama3, Pythia et GPT-J. Ils ont découvert que la partie du modèle LLM responsable des calculs arithmétiques (appelée « circuit ») est composée de nombreux neurones individuels, dont chacun agit comme une « calculatrice miniature » et est uniquement responsable de la reconnaissance de modèles numériques spécifiques et de la sortie des données correspondantes. répondre. Par exemple, un neurone pourrait être chargé d'identifier les « nombres dont le chiffre unique est 8 », tandis qu'un autre neurone pourrait être chargé d'identifier « les opérations de soustraction dont les résultats sont compris entre 150 et 180 ».

Ces « microcalculateurs » sont comme un fouillis d'outils, et au lieu de les utiliser selon un algorithme spécifique, LLM utilise une combinaison aléatoire de ces « outils » pour calculer une réponse basée sur le modèle de nombres qu'il saisit. C'est comme un chef qui n'a pas de recette fixe, mais qui la mélange à volonté en fonction des ingrédients disponibles, et qui finit par faire une « cuisine noire ».

Ce qui est encore plus surprenant, c'est que cette stratégie de « mélange heuristique » est effectivement apparue dès les premiers stades de la formation LLM et a été progressivement améliorée au fur et à mesure de la progression de la formation. Cela signifie que le LLM s’appuie dès le départ sur cette approche de raisonnement « patchwork », plutôt que de développer cette stratégie à un stade ultérieur.

Alors, quels problèmes cette méthode de raisonnement arithmétique « étrange » va-t-elle causer ? Les chercheurs ont découvert que la stratégie du « méli-mélo heuristique » a une capacité de généralisation limitée et est sujette aux erreurs. En effet, LLM a un nombre limité de « petites intelligences », et ces « petites intelligences » elles-mêmes peuvent également avoir des défauts qui les empêchent de donner des réponses correctes lorsqu'elles rencontrent de nouveaux modèles numériques. Tout comme un chef qui ne sait faire que des "œufs brouillés à la tomate", si on lui demande soudain de faire du "porc effiloché au goût de poisson", il sera certainement pressé et désemparé.

Cette étude a révélé les limites de la capacité de raisonnement arithmétique du LLM et a également indiqué la direction à suivre pour améliorer la capacité mathématique du LLM à l'avenir. Les chercheurs estiment que s'appuyer uniquement sur les méthodes de formation et l'architecture de modèle existantes pourrait ne pas suffire à améliorer les capacités de raisonnement arithmétique de LLM, et que de nouvelles méthodes doivent être explorées pour aider LLM à apprendre des algorithmes plus puissants et plus généraux afin qu'ils puissent véritablement devenir des « maîtres mathématiques ».

Adresse papier : https://arxiv.org/pdf/2410.21272

Cette recherche explique non seulement les lacunes du LLM dans les calculs mathématiques, mais, plus important encore, fournit une orientation de référence précieuse pour les améliorations futures du LLM. Les recherches futures doivent se concentrer sur la manière d'améliorer la capacité de généralisation et la capacité d'apprentissage des algorithmes du LLM pour résoudre ses lacunes en raisonnement arithmétique et lui permettre de posséder réellement de puissantes capacités mathématiques.