DeepSeek a publié son premier modèle d'inférence DeepSeek-R1 basé sur une formation d'apprentissage par renforcement le 20 janvier 2025. Le modèle a montré des performances comparables, voire meilleures, à celles d'OpenAI-o1-1217 dans plusieurs tests de référence. DeepSeek-R1 n'est pas formé directement, mais grâce à une formation en plusieurs étapes et à des données de démarrage à froid. Basé sur le modèle DeepSeek-V3-Base, il surmonte les problèmes causés par l'utilisation exclusive du modèle de formation par apprentissage par renforcement (DeepSeek-R1-Zero). Des problèmes tels qu'une mauvaise lisibilité et des langues mixtes ont finalement entraîné des améliorations significatives des performances. Le modèle est open source et propose des prix compétitifs pour l’accès aux API, offrant ainsi aux utilisateurs une option plus pratique et plus économique.

Le 20 janvier 2025, DeepSeek a annoncé le lancement de son premier modèle d'inférence DeepSeek-R1 formé par apprentissage par renforcement (RL), qui a atteint des performances comparables à celles d'OpenAI-o1-1217 dans plusieurs tests d'inférence. DeepSeek-R1 est basé sur le modèle DeepSeek-V3-Base et utilise un entraînement en plusieurs étapes et des données de démarrage à froid pour améliorer les capacités d'inférence.

Les chercheurs de DeepSeek ont d'abord développé DeepSeek-R1-Zero, un modèle entièrement formé par apprentissage par renforcement à grande échelle, sans aucune étape préparatoire à un réglage fin supervisé. DeepSeek-R1-Zero a démontré d'excellentes performances dans les tests d'inférence. Par exemple, lors de l'examen AIME2024, son score pass@1 est passé de 15,6 % à 71,0 %. Cependant, DeepSeek-R1-Zero présente également quelques problèmes, tels qu'une mauvaise lisibilité et des langues mixtes.

Afin de résoudre ces problèmes et d'améliorer encore les performances d'inférence, l'équipe DeepSeek a développé DeepSeek-R1. DeepSeek-R1 introduit une formation en plusieurs étapes et des données de démarrage à froid avant l'apprentissage par renforcement. Plus précisément, les chercheurs ont d’abord collecté des milliers de données de démarrage à froid pour affiner le modèle DeepSeek-V3-Base. Ensuite, ils ont effectué un apprentissage par renforcement orienté inférence tout en entraînant DeepSeek-R1-Zero. Lorsque le processus d'apprentissage par renforcement était proche de la convergence, ils ont créé de nouvelles données de réglage fin supervisé par échantillonnage de rejet des points de contrôle d'apprentissage par renforcement, combinées avec les données supervisées de DeepSeek-V3 dans des domaines tels que l'écriture, la réponse aux faits et la conscience de soi, puis recyclés. Modèle DeepSeek-V3-Base. Enfin, un apprentissage par renforcement supplémentaire est effectué sur les points de contrôle affinés en utilisant des indices de tous les scénarios.

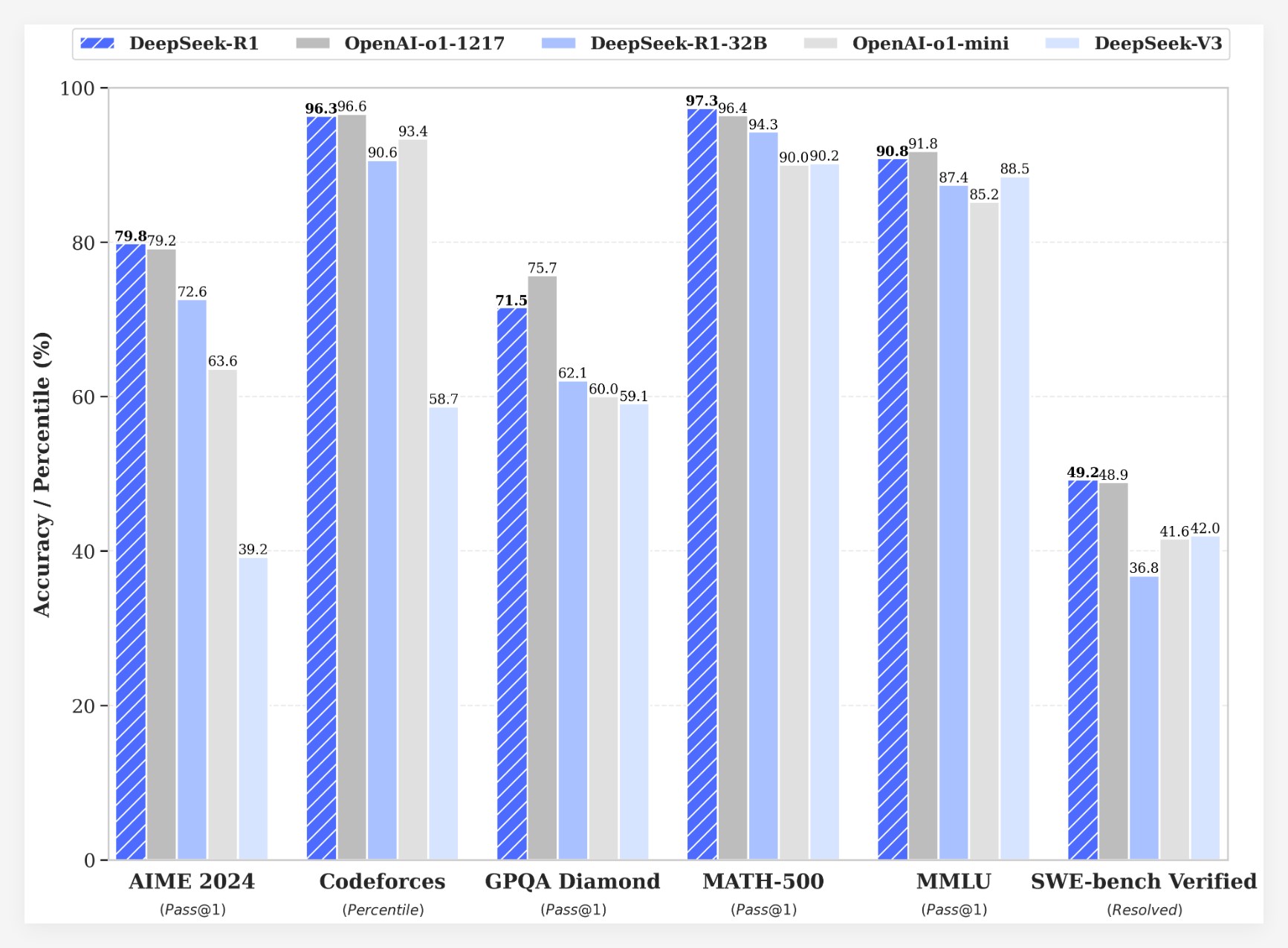

DeepSeek-R1 obtient des résultats impressionnants sur plusieurs benchmarks :

• Lors de l'examen AIME2024, le score pass@1 de DeepSeek-R1 a atteint 79,8 %, légèrement supérieur à celui d'OpenAI-o1-1217.

• Dans l'examen MATH-500, le score pass@1 de DeepSeek-R1 a atteint 97,3 %, ce qui est le même que celui d'OpenAI-o1-1217.

•Dans la tâche de compétition de code, DeepSeek-R1 a obtenu une note Elo de 2029 sur Codeforces, dépassant 96,3 % des participants humains.

•Dans les tests de connaissances tels que MMLU, MMLU-Pro et GPQA Diamond, DeepSeek-R1 obtient respectivement 90,8 %, 84,0 % et 71,5 %, soit nettement mieux que DeepSeek-V3.

• DeepSeek-R1 fonctionne également bien dans d'autres tâches telles que l'écriture créative, les questions et réponses générales, l'édition, le résumé, etc.

De plus, DeepSeek explore également la distillation des capacités d'inférence de DeepSeek-R1 dans des modèles plus petits. Il a été constaté que la distillation directement à partir de DeepSeek-R1 fonctionnait mieux que l'application de l'apprentissage par renforcement sur un petit modèle. Cela suggère que les modèles d'inférence découverts par les modèles à grande base sont essentiels à l'amélioration des capacités d'inférence. DeepSeek propose DeepSeek-R1-Zero, DeepSeek-R1 et six modèles denses (1,5B, 7B, 8B, 14B, 32B, 70B) distillés à partir de DeepSeek-R1 basés sur Qwen et Llama. Le lancement de DeepSeek-R1 marque un progrès significatif dans l'apprentissage par renforcement en améliorant les capacités de raisonnement des grands modèles de langage.

avantage de coûtEn termes de coût, DeepSeek-R1 propose une stratégie tarifaire très compétitive. Son prix d'accès à l'API est de 0,14 $ (accès au cache) et 0,55 $ (échec du cache) par million de jetons d'entrée, et de 2,19 $ par million de jetons de sortie. Cette stratégie de prix est plus attractive que d'autres produits similaires et a été décrite comme un « game changer » par les utilisateurs. Le site officiel et l'API sont désormais en ligne ! Visitez https://chat.deepseek.com pour découvrir DeepThink !

La sortie de DeepSeek-R1 a déclenché des discussions animées au sein de la communauté. De nombreux utilisateurs apprécient la nature open source et les avantages financiers du modèle, estimant qu'il offre aux développeurs plus de choix et de liberté. Cependant, certains utilisateurs ont soulevé des questions sur la taille de la fenêtre contextuelle du modèle et espèrent que les futures versions pourront être encore optimisées.

L'équipe DeepSeek a déclaré qu'elle continuerait à travailler sur l'amélioration des performances et de l'expérience utilisateur du modèle et prévoyait de lancer davantage de fonctionnalités à l'avenir, notamment une analyse avancée des données, pour répondre aux attentes des utilisateurs en matière d'AGI (Intelligence générale artificielle).

Le lancement de DeepSeek-R1 démontre non seulement le grand potentiel de l'apprentissage par renforcement pour améliorer les capacités de raisonnement des grands modèles de langage, mais apporte également de nouvelles orientations et possibilités au développement du domaine de l'IA. Ses fonctionnalités open source et sa stratégie de tarification compétitive favoriseront davantage la vulgarisation et l’application de la technologie de l’IA.