Les modèles de langage visuel (VLM) jouent un rôle clé dans les tâches multimodales, mais ils souffrent de lacunes importantes dans la compréhension de la négation. Les modèles existants ont souvent du mal à faire la distinction entre les phrases positives et négatives, ce qui est particulièrement inquiétant dans les applications qui nécessitent une compréhension sémantique précise, telles que le diagnostic médical et la surveillance de sécurité. La cause fondamentale est un biais dans les données de pré-entraînement qui amène le modèle à confondre les déclarations négatives avec les déclarations positives. Cet article présentera un nouveau framework appelé NegBench, qui vise à résoudre le problème de la capacité insuffisante des VLM à comprendre la négation.

Les modèles de langage visuel (VLM) jouent un rôle crucial dans les tâches multimodales, telles que la récupération d'images, la description d'images et le diagnostic médical. L'objectif de ces modèles est d'aligner les données visuelles avec les données linguistiques pour permettre un traitement plus efficace de l'information. Cependant, les VLM actuels sont encore confrontés à des défis importants dans la compréhension de la négation.

La négation est cruciale dans de nombreuses applications, comme par exemple pour faire la distinction entre une « pièce sans fenêtres » et une « pièce avec fenêtres ». Malgré des progrès significatifs dans les VLM, les performances des modèles existants diminuent considérablement lorsqu'il s'agit de déclarations négatives. Cette limitation est particulièrement importante dans les domaines à haut risque tels que la surveillance de la sécurité et les soins de santé.

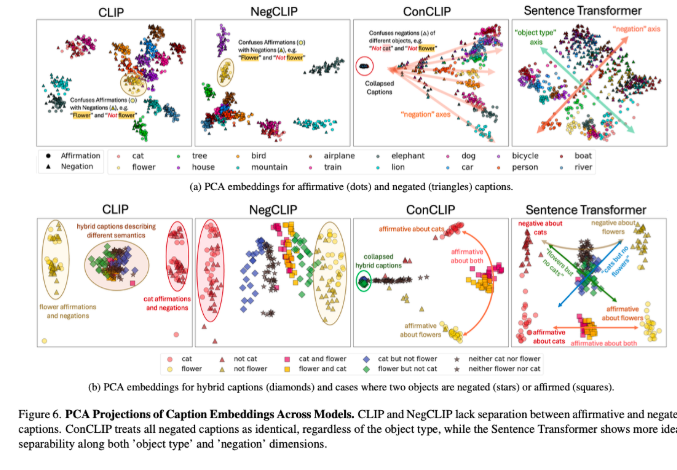

Les VLM existants, tels que CLIP, utilisent un espace d'intégration partagé pour aligner les représentations visuelles et textuelles. Bien que ces modèles fonctionnent bien dans des tâches telles que la récupération multimodale et le sous-titrage d'images, ils échouent lorsqu'il s'agit de phrases négatives. La racine de ce problème réside dans un biais dans les données de pré-formation, qui consistent principalement en exemples positifs, ce qui amène le modèle à traiter les déclarations négatives et positives comme synonymes. Par conséquent, les références existantes, telles que CREPE et CC-Neg, utilisent des exemples de modèles simples qui ne peuvent pas véritablement refléter la richesse et la profondeur de la négation en langage naturel. Les VLM sont donc confrontés à d'énormes défis lorsqu'ils exécutent des applications précises de compréhension du langage, telles que l'interrogation de conditions complexes dans des bases de données d'imagerie médicale.

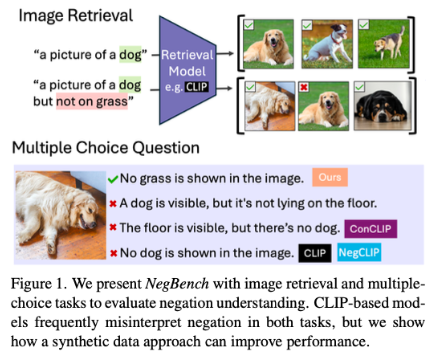

Pour résoudre ces problèmes, des chercheurs du MIT, de Google DeepMind et de l'Université d'Oxford ont proposé le cadre NegBench pour évaluer et améliorer la capacité des VLM à comprendre la négation. Le cadre évalue deux tâches de base : Récupération et négation (Retrieval-Neg), qui teste la capacité du modèle à récupérer des images basées sur des descriptions positives et négatives ; et Questions à choix multiples et négation (MCQ-Neg), qui évalue les performances du modèle sur des questions subtiles. compréhension. NegBench utilise de grands ensembles de données synthétiques, tels que CC12M-NegCap et CC12M-NegMCQ, contenant des millions de titres couvrant de riches scénarios négatifs pour améliorer la formation et l'évaluation des modèles.

En combinant des ensembles de données réelles et synthétiques, NegBench surmonte efficacement les limites des modèles existants et améliore considérablement les performances et les capacités de généralisation du modèle. Le modèle affiné a montré des améliorations significatives dans les tâches de récupération et de compréhension, en particulier lorsqu'il s'agit de requêtes négatives, où le rappel du modèle a augmenté de 10 %. Dans les tâches à choix multiples, la précision s'est améliorée jusqu'à 40 %, démontrant une capacité considérablement améliorée à distinguer les titres subtils positifs et négatifs.

La proposition de NegBench comble la lacune clé des VLM dans la compréhension de la négation et ouvre la voie à la construction de systèmes d'intelligence artificielle plus puissants, ce qui est particulièrement important dans des domaines clés tels que le diagnostic médical et la récupération de contenu sémantique.

Article : https://arxiv.org/abs/2501.09425

Code : https://github.com/m1k2zoo/negbench

Souligner:

Les chercheurs révèlent que les lacunes des modèles de langage visuel dans la compréhension de la négation proviennent principalement de biais dans les données d’entraînement.

Le framework NegBench améliore considérablement les performances du modèle sur les tâches de récupération et de compréhension en introduisant de riches exemples négatifs.

Lorsque le modèle affiné traite les requêtes négatives, les taux de précision et de rappel sont considérablement améliorés, favorisant ainsi les progrès des systèmes d’intelligence artificielle.

L'émergence du cadre NegBench fournit une solution efficace au problème des modèles de langage visuel dans la compréhension de la négation. Il revêt une grande importance pour améliorer les performances des modèles et promouvoir le développement de l'intelligence artificielle, et mérite des recherches et des applications plus approfondies.