Les grands modèles visuels (LVLM) ont fait des progrès significatifs dans le domaine de la compréhension des images, mais le « phénomène d'illusion » est devenu un goulot d'étranglement dans son développement. Pour résoudre ce problème, l'équipe du Taotian Group Future Life Laboratory a proposé une nouvelle méthode appelée « Token Preference Optimization » (TPO), qui améliore efficacement l'impact visuel du modèle en introduisant un mécanisme de récompense d'ancrage visuel auto-calibré, réduisant ainsi la dépendance à l'information. probabilité d'hallucinations. Le cœur de TPO est d'automatiser la génération de signaux de récompense au niveau du jeton, en évitant les annotations manuelles fastidieuses et en attribuant des récompenses à chaque jeton qui reflètent sa dépendance à l'égard des informations visuelles, améliorant ainsi les performances du modèle.

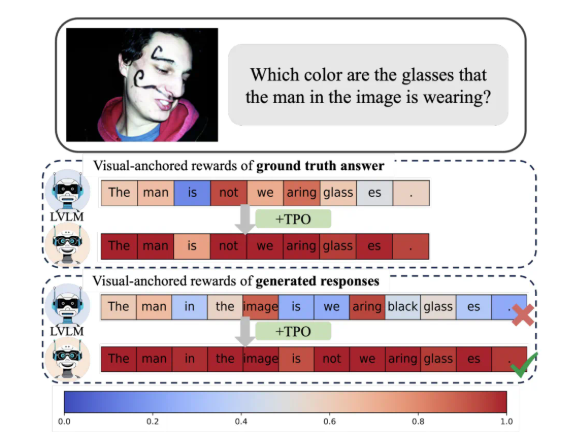

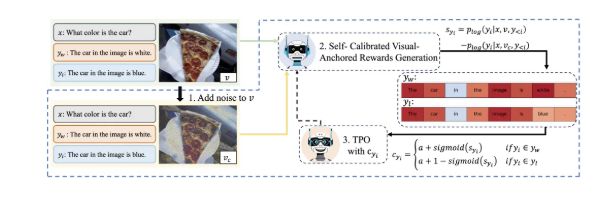

La plus grande innovation de TPO est qu’il implémente des signaux de récompense automatisés au niveau des jetons. Cette méthode peut identifier automatiquement les jetons visuellement ancrés dans les données de préférence, évitant ainsi les fastidieuses annotations manuelles fines, tout en attribuant à chaque jeton une récompense qui reflète sa dépendance à l'égard des informations visuelles pendant le processus de formation. Ce signal de récompense auto-calibré et visuellement ancré est conçu pour optimiser la dépendance du modèle à l'égard des informations visuelles, atténuant ainsi efficacement l'apparition d'hallucinations.

La recherche montre que les modèles utilisant TPO surpassent considérablement les méthodes traditionnelles dans de multiples critères d'évaluation, en particulier dans les tâches plus complexes, où les réponses générées par le modèle reposent de plus en plus sur des informations d'image plutôt que sur une connaissance préalable du modèle de langage. Ces progrès améliorent non seulement la compréhension du modèle, mais fournissent également une base théorique importante pour des recherches ultérieures.

En outre, l’équipe de recherche a également mené des expériences d’ablation sur différents paramètres de TPO et a découvert que des étapes optimisées d’ajout de bruit et des stratégies de distribution de récompenses peuvent encore améliorer les performances du modèle. Cette découverte indique sans aucun doute la direction des recherches futures et des applications des grands modèles visuels.

En bref, cette réalisation innovante de Taotian propose une nouvelle idée de technologie d'alignement multimodal et favorise l'application approfondie de la technologie de l'IA dans les domaines de la vie et de la consommation.

Grâce à l'application de la méthode TPO, le problème de « l'illusion » des grands modèles visuels est efficacement résolu, la fiabilité et la précision du modèle sont améliorées et une nouvelle direction est fournie pour le développement futur des grands modèles visuels. nouvelle direction pour l'application de l'intelligence artificielle dans la vie réelle. L'application a jeté des bases solides et a une signification théorique et une valeur d'application importantes. Ce résultat de recherche apporte une nouvelle force au développement de la technologie multimodale.