Cet article présente la méthode LLM2CLIP développée par Microsoft en collaboration avec l'Université Tongji, qui vise à améliorer les performances de l'encodeur visuels du modèle de clip et à résoudre ses limites dans la gestion des descriptions de texte longues et complexes. LLM2CLIP améliore considérablement la capacité du modèle à faire correspondre les images et le texte en intégrant des modèles de grands langues (LLM) et en introduisant la technologie de «contraste de contraste de contraste». Les résultats expérimentaux de cette méthode sur plusieurs ensembles de données montrent que dans les tâches de récupération d'image à texte et de texte à image, en particulier les tâches de récupération de texte longs et courts, ils dépassent les modèles traditionnels du clip et de l'EVA et montrent un traitement transversal puissant capacité.

Dans le domaine de la science et de la technologie d'aujourd'hui, CLIP (pré-formation d'image linguistique contrasté) est un important modèle de base multimodal. Il combine des signaux visuels et texte dans un espace de fonction partagé en utilisant des pertes d'apprentissage de contraste sur des paires de texte d'image à grande échelle.

En tant que chercheur, CLIP peut prendre en charge diverses tâches telles que la classification zéro-shot, la détection, la segmentation et la récupération de texte d'image. Pendant ce temps, en tant qu'extracteur de caractéristiques, il domine presque toutes les tâches de représentation intermodale telles que la compréhension de l'image, la compréhension vidéo et la génération de texte à l'image ou de vidéo. Ce qui est puissant à propos de Clip, c'est sa capacité à connecter des images au langage naturel et à capturer les connaissances humaines, grâce à sa formation sur les données réseau à grande échelle, qui contient des descriptions détaillées de texte.

Cependant, Clip a certaines limites dans le traitement des descriptions de texte longs et complexes. Pour surmonter ce problème, les chercheurs de l'Université Microsoft et de Tongji ont proposé la méthode LLM2CLIP, visant à améliorer l'apprentissage de la représentation visuelle en intégrant des modèles de grande langue (LLM). Cette méthode remplace hardiment le codeur de texte de clip d'origine et utilise la riche connaissance des LLMS pour améliorer les performances de l'encodeur visuelle de CLIP. L'étude a révélé que l'intégration directe de LLMS dans le clip entraîne une dégradation des performances, ce défi doit donc être relevé.

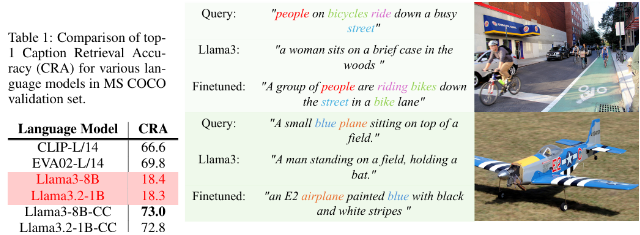

La méthode LLM2CLIP améliore considérablement la capacité de LLM à séparer les titres d'image en introduisant la technologie de «contraste de contraste de contraste», réalisant ainsi une amélioration significative des performances.

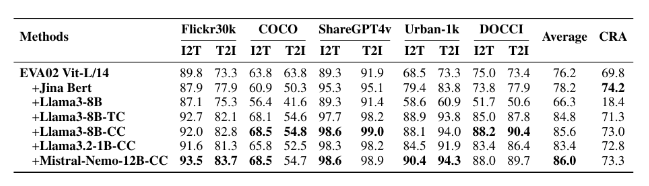

Les chercheurs ont utilisé des ensembles de données de différentes tailles pour des expériences de réglage fin, y compris les petits CC-3M, le CC-3M moyen et le CC-12M, ainsi que les grands CC-3M, CC-12M, YFCC-15M et Recaption-1b. Les résultats montrent que le modèle formé à l'aide de LLM2CLIP fonctionne mieux que les modèles traditionnels de clip et d'EVA dans des tâches de récupération d'image-texte et de texte à l'image.

En combinant une formation multimodale avec des modèles tels que LLAVA 1.5, LLM2CLIP a bien fonctionné dans presque toutes les références, en particulier lorsqu'il s'agit de tâches de récupération de texte long et courte, améliorant les performances du modèle EVA02 précédent de 16,5%. Cette approche innovante transforme non seulement Clip du simple traitement des données anglaises en un puissant modèle transversal, mais jette également les bases de recherches futures sur la formation à clip.

Modèle: https://huggingface.co/collections/microsoft/llm2clip-672323a266173cfa40b32d4c

Code: https://github.com/microsoft/llm2clip/

Papier: https://arxiv.org/abs/2411.04997

Points:

LLM2CLIP est une approche innovante proposée par Microsoft et l'Université Tongji en collaboration avec l'Université Tongji, visant à améliorer les performances de son encodeur visuel en remplaçant l'encodeur de texte de Clip.

Cette méthode améliore considérablement la capacité du modèle à faire correspondre les images avec le texte grâce à la technique de "contraste de contraste de contraste", dépassant les modèles de pointe existants.

Les expériences de LLM2CLIP sur plusieurs ensembles de données montrent qu'elle fonctionne mieux que les modèles traditionnels dans des tâches de récupération de texte longs et courtes, ce qui entraîne le développement de modèles transversaux.

En bref, la méthode LLM2CLIP fournit de nouvelles idées pour l'amélioration du modèle de clip. Les liens de ressources connexes sont pratiques pour les lecteurs pour apprendre et rechercher.