Le lancement d'Iflytek du modèle d'interaction multimodal d'Iflytek marque une nouvelle étape dans le domaine de l'intelligence artificielle. Ce modèle franchit les limites de l'interaction vocale unique dans le passé, réalise une intégration en un clic sur les fonctions d'interaction vocale, visuelle et numérique humaine, offrant aux utilisateurs une expérience interactive plus vive, plus réaliste et plus pratique. Sa technologie humaine numérique super-anthropomorphe peut correspondre avec précision au contenu vocal pour générer des expressions et des actions et prend en charge l'interaction super-anthropomorphe, ajuster les paramètres sonores en fonction des instructions et fournir des services personnalisés. La fonction d'interaction visuelle multimodale donne au modèle la capacité de "comprendre le monde et de tout reconnaître", percevait avec précision les informations environnementales et d'apporter des réponses plus appropriées.

Le lancement du modèle d'interaction multimodal d'Iflytek reflète non seulement la position principale d'Iflytek dans la technologie d'interaction multimodale, mais fournit également de nouvelles idées pour la direction future de développement des applications d'intelligence artificielle. En intégrant plusieurs méthodes d'interaction, ce modèle peut mieux comprendre les besoins des utilisateurs et fournir des services plus précis et plus riches. Son SDK ouvert offre également aux développeurs plus de possibilités pour promouvoir la popularisation et l'application de la technologie multimodale de l'intelligence artificielle. À l'avenir, nous pouvons nous attendre à des applications plus innovantes basées sur ce modèle afin d'améliorer encore l'efficacité de la vie et la qualité de l'expérience des gens.

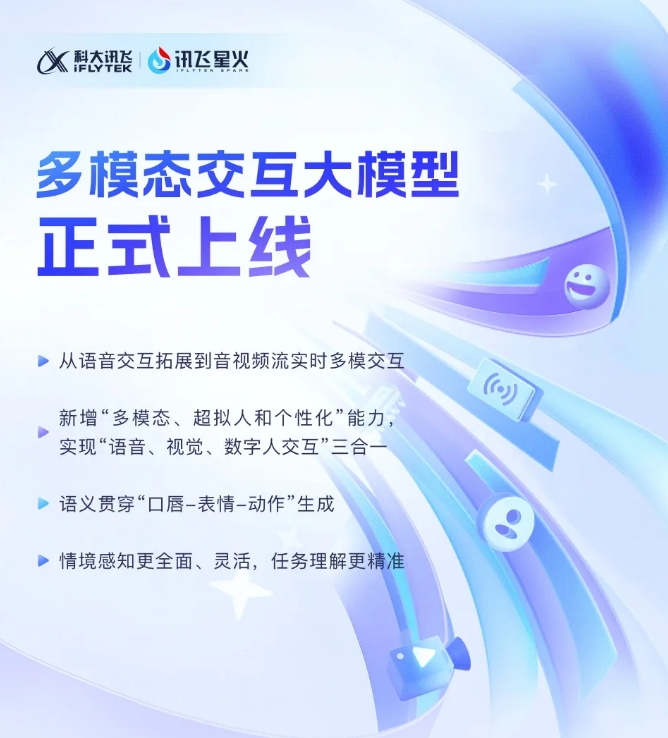

Iflytek a récemment annoncé que son dernier développement du modèle d'interaction multimodal Iflytek avait été officiellement mis en service. Cette percée technologique marque une nouvelle étape dans l'expansion d'Iflytek d'une seule technologie d'interaction vocale à une nouvelle étape d'interaction multimodale en temps réel des flux audio et vidéo. Le nouveau modèle intègre les fonctions d'interaction vocale, visuelle et numérique, et les utilisateurs peuvent obtenir une combinaison transparente de l'appel à un clic trois à un clic.

Le lancement du modèle d'interaction multimodal Iflytek a introduit la technologie humaine numérique super-anthropomorphe pour la première fois. et réel. En intégrant du texte, de la parole et des expressions, le nouveau modèle peut atteindre la cohérence sémantique intermodale, ce qui rend l'expression émotionnelle plus réaliste et cohérente.

De plus, Iflytek Spark prend en charge la technologie d'interaction super rapide super-anthropomorphe, en utilisant un réseau neuronal unifié pour réaliser directement la modélisation de bout en bout de la voix à la voix, ce qui rend la vitesse de réponse plus rapide et plus fluide. Cette technologie peut vivement percevoir les changements émotionnels et ajuster librement le rythme, la taille et le caractère du son en fonction des instructions, offrant une expérience interactive plus personnalisée.

En termes d'interaction visuelle multimodale, Iflytek Spark peut "comprendre le monde" et "tout reconnaître", et percevoir pleinement des scènes de fond spécifiques, l'état de la logistique et d'autres informations, rendant la compréhension de la tâche plus précise. En intégrant diverses informations telles que la voix, les gestes, les comportements, les émotions, etc., le modèle peut faire des réponses appropriées, offrant aux utilisateurs une expérience interactive plus riche et plus précise.

Interaction multimodale Big Mode SDK: https://www.xfyun.cn/solutions/multimodel

En bref, l'émergence du modèle d'interaction multimodale Iflytek indique que la technologie de l'intelligence artificielle est entrée dans une nouvelle étape de développement. Dans l'attente d'Iflytek Spark apportera plus de surprises à l'avenir.