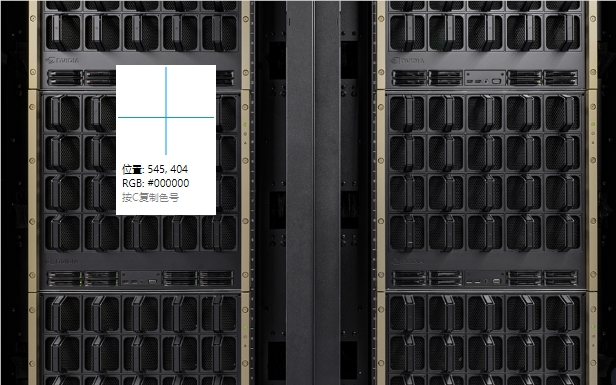

Nvidia a récemment publié la nouvelle plate-forme Blackwell et a montré des améliorations de performances impressionnantes dans la référence MLPERF Training 4.1. Par rapport aux plates-formes Hopper précédentes, Blackwell a doublé ses performances dans plusieurs tâches d'entraînement en IA, en particulier dans la formation du modèle de grande langue (LLM), et son efficacité a été considérablement améliorée. Ces progrès révolutionnaires indiquent un autre saut dans la puissance de calcul de l'IA et jette une base solide pour la mise en œuvre généralisée des applications d'IA à l'avenir. Cet article effectuera une analyse approfondie des performances de la plate-forme Blackwell et discutera de son innovation technologique et de son développement futur.

Récemment, Nvidia a publié sa nouvelle plate-forme Blackwell et a démontré des performances préliminaires dans la référence MLPERF Training 4.1. Selon les résultats des tests, les performances de Blackwell à certains aspects ont doublé par rapport à la génération précédente de plateformes de trémies, et cette réalisation a attiré l'attention générale de l'industrie.

Dans le MLPERF Training4.1 Benchmark, la plate-forme Blackwell a réalisé 2,2 fois les performances de chaque GPU dans la tâche de réglage fin de LLAMA270B de la référence LLM (modèle grand langage) et 2 fois les performances de chaque GPU dans la pré-entraînement de Le GPT-3175B double l'amélioration. De plus, dans d'autres repères tels que la formation stable de diffusion V2, la nouvelle génération de Blackwell a également dépassé la génération précédente de 1,7 fois.

Il convient de noter que si Hopper continue de montrer des améliorations, Hopper a également une amélioration des performances de 1,3x dans la pré-formation du modèle linguistique par rapport à la série précédente de références de formation MLPERF. Cela montre que la technologie de Nvidia continue de s'améliorer. Dans la récente référence GPT-3175B, NVIDIA a soumis 11 616 GPU Hopper, établissant un nouveau record d'expansion.

En ce qui concerne les détails techniques de Blackwell, Nvidia a déclaré que la nouvelle architecture utilise des noyaux de tenseur optimisés et une mémoire de bande passante élevée plus rapide. Cela ne fait que 64 GPU pour exécuter la référence GPT-3175B, tandis que 256 GPU pour obtenir les mêmes performances en utilisant la plate-forme Hopper.

Nvidia a également souligné l'amélioration des performances des produits de génération de Hopper dans les mises à jour de logiciels et de réseau lors de la conférence de presse, et il est prévu que Blackwell continue de s'améliorer avec les futures soumissions. De plus, Nvidia prévoit de lancer la prochaine génération d'accélérateur d'IA Blackwell Ultra l'année prochaine, qui devrait fournir plus de mémoire et une puissance de calcul plus forte.

Blackwell a également fait ses débuts en septembre dernier dans la référence MLPerf Inference V4.1, et en termes d'inférence de l'IA, il réalise 4 fois plus de performance incroyable par GPU que le H100, en particulier avec une Essence de précision FP4 inférieure Cette nouvelle tendance est conçue pour faire face à la demande croissante de chatbots à faible latence et à l'informatique intelligente telle que le modèle O1 d'OpenAI.

Points:

- ** La plate-forme Nvidia Blackwell double ses performances dans la formation de l'IA, brisant les normes de l'industrie! **

- ** Blackwell ne nécessite que 64 GPU dans la référence GPT-3175B, améliorant considérablement l'efficacité! **

- ** Blackwell Ultra sera lancé l'année prochaine, qui devrait fournir une mémoire plus élevée et une puissance de calcul! **

En bref, l'émergence de la plate-forme Blackwell de Nvidia marque une percée majeure dans le domaine de l'informatique de l'IA. Son amélioration significative des performances et le futur lancement de Blackwell Ultra favoriseront davantage le développement et l'application de la technologie de l'IA et apporteront plus de possibilités à toutes les industries. Nous avons des raisons de nous attendre à ce que la plate-forme Blackwell joue un plus grand rôle à l'avenir.