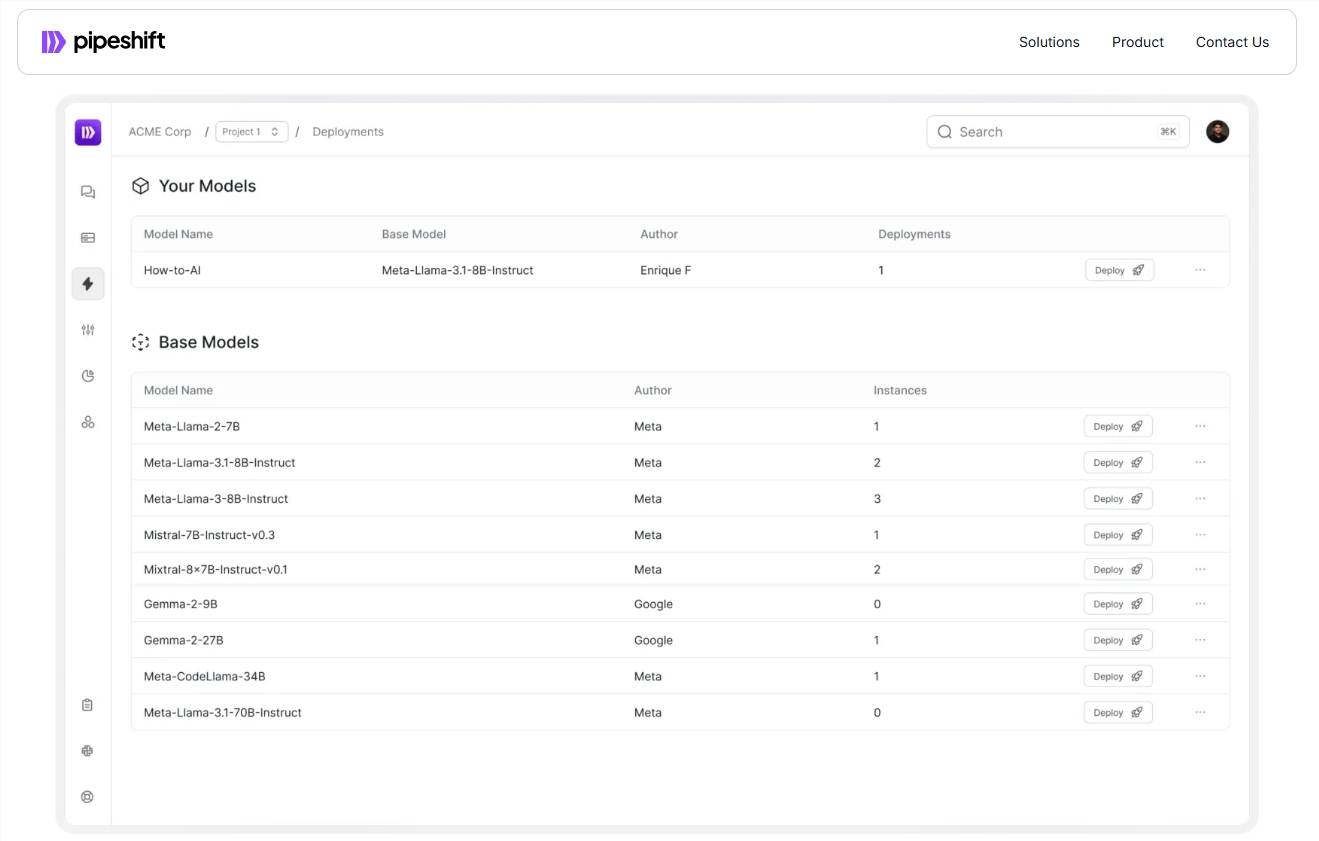

Startup PipePhift a lancé une nouvelle plate-forme de bout en bout conçue pour aider les entreprises à former, déployer et mettre à l'échelle plus efficacement les modèles d'IA génératifs open source. La plate-forme est compatible avec une variété d'environnements cloud et des GPU sur site, améliorant considérablement la vitesse d'inférence et réduisant les coûts, résolvant le problème de la commutation efficace entre plusieurs modèles par les entreprises. Il adopte un cadre magique du moteur d'inférence modulaire, qui permet une combinaison flexible de différents composants d'inférence pour optimiser les performances d'inférence sans travail d'ingénierie fastidieux. C'est sans aucun doute un grand avantage pour les entreprises auxquelles sont confrontés les défis dans le déploiement et la gestion des modèles d'IA.

Récemment, Startup PipePhift a lancé une nouvelle plate-forme de bout en bout conçue pour aider les entreprises à former, déployer et mettre à l'échelle plus efficacement les modèles d'IA génératifs open source. La plate-forme fonctionne non seulement sur un environnement cloud ou un GPU sur site, mais améliore également considérablement la vitesse d'inférence et réduit les coûts.

Avec le développement rapide de la technologie de l'IA, de nombreuses entreprises sont confrontées au défi de la façon de basculer efficacement entre plusieurs modèles. Traditionnellement, les équipes doivent construire un système MLOPS complexe qui implique plusieurs liens tels que l'acquisition de ressources informatiques, la formation des modèles, le réglage fin et le déploiement au niveau de la production. à la gestion des infrastructures.

Arko Chattopadhyay, co-fondateur et PDG de PipiShift, a noté que le développement d'un moteur de raisonnement modulaire flexible prend souvent des années d'expérience, et les solutions de Pipehift sont conçues pour simplifier ce processus avec son moteur de raisonnement modulaire. La plate-forme adopte un cadre appelé Magic (GPU Inference Cluster Architecture Modular Architecture), qui permet aux équipes de combiner de manière flexible différents composants d'inférence en fonction des exigences spécifiques de la charge de travail, optimisant ainsi les performances d'inférence sans avoir besoin d'ingénierie lourde.

Par exemple, une entreprise de vente au détail du Fortune 500, après avoir utilisé la plate-forme PipiShift, intègre quatre modèles qui nécessitaient à l'origine quatre instances de GPU indépendantes pour fonctionner sur une seule instance GPU. De cette façon, la société a non seulement atteint une augmentation de cinq fois de la vitesse du raisonnement, mais a également réduit les coûts d'infrastructure de 60%. Cette réalisation permet aux entreprises de rester compétitives dans un marché en croissance rapide.

PipEhift a conclu des accords de licence annuels avec 30 sociétés et prévoit de lancer des outils pour aider les équipes à créer et à mettre à l'échelle des ensembles de données à l'avenir. Cela accélérera encore le processus expérimental et de préparation des données et améliorera la productivité du client.

Entrée officielle: https://pipeshift.com/

Points:

Le moteur d'inférence modulaire de Pipehift peut réduire considérablement l'utilisation du GPU de l'inférence de l'IA et réduire les coûts jusqu'à 60%.

Grâce au cadre magique, les entreprises peuvent rapidement combiner les composants d'inférence, améliorer la vitesse d'inférence et réduire le fardeau de l'ingénierie.

Pipehift s'est associé à plusieurs sociétés et lancera plus d'outils à l'avenir pour aider les entreprises à gérer plus efficacement les charges de travail de l'IA.

Avec ses caractéristiques efficaces, flexibles et rentables, la plate-forme Pipehift fournit aux entreprises une solution efficace pour simplifier le déploiement et la gestion des modèles d'IA, qui mérite d'être prêté attention. Son développement futur et le lancement de nouveaux outils valent également la peine d'être attendus.