L'équipe de recherche Salesforce AI a publié le dernier modèle de langage multimodal, BLIP-3-video, visant à traiter efficacement les données vidéo en croissance. Le modèle traditionnel de compréhension vidéo est inefficace. Cette décision résout le problème de traiter les longues vidéos et offre des capacités de compréhension vidéo plus solides pour les industries telles que la conduite autonome et le divertissement.

Récemment, l'équipe de recherche Salesforce AI a lancé un nouveau modèle de langue multimodale - BLIP-3-video. Avec l'augmentation rapide du contenu vidéo, comment traiter efficacement les données vidéo est devenue un problème urgent. L'émergence de ce modèle est conçue pour améliorer l'efficacité et l'efficacité de la compréhension vidéo et convient aux industries de la conduite autonome vers le divertissement.

Les modèles traditionnels de compréhension vidéo traitent souvent la vidéo par image, générant une grande quantité d'informations visuelles. Ce processus consomme non seulement beaucoup de ressources informatiques, mais limite également considérablement la capacité de traiter de longues vidéos. À mesure que la quantité de données vidéo continue de croître, cette approche devient de plus en plus inefficace, il est donc crucial de trouver une solution qui capture les informations critiques de la vidéo tout en réduisant la charge informatique.

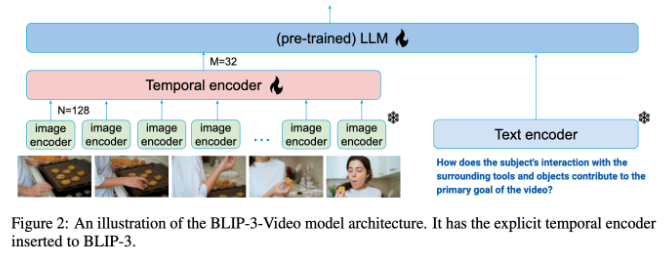

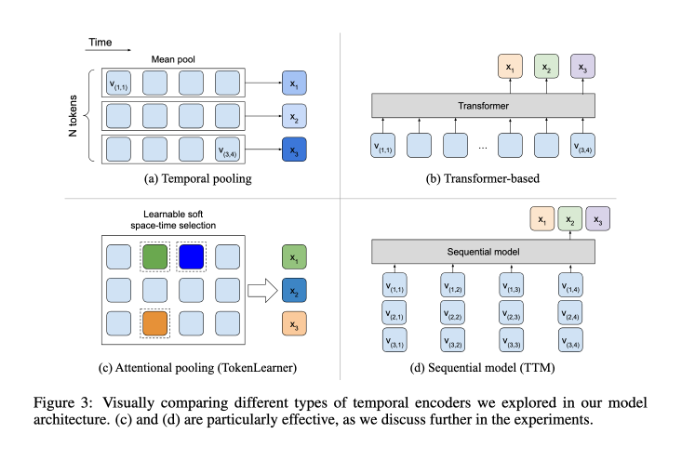

À cet égard, BLIP-3-video a assez bien fonctionné. En introduisant un "codeur de séquence temporelle", le modèle a réussi à réduire la quantité d'informations visuelles requises dans la vidéo à 16 à 32 marqueurs visuels. Cette conception innovante améliore considérablement l'efficacité informatique, permettant aux modèles de terminer des tâches vidéo complexes à moindre coût. Ce codeur de synchronisation utilise un mécanisme de mise en commun d'attention spatio-temporelle apprenable qui extrait les informations les plus importantes de chaque cadre et les intègre dans un ensemble compact de marqueurs visuels.

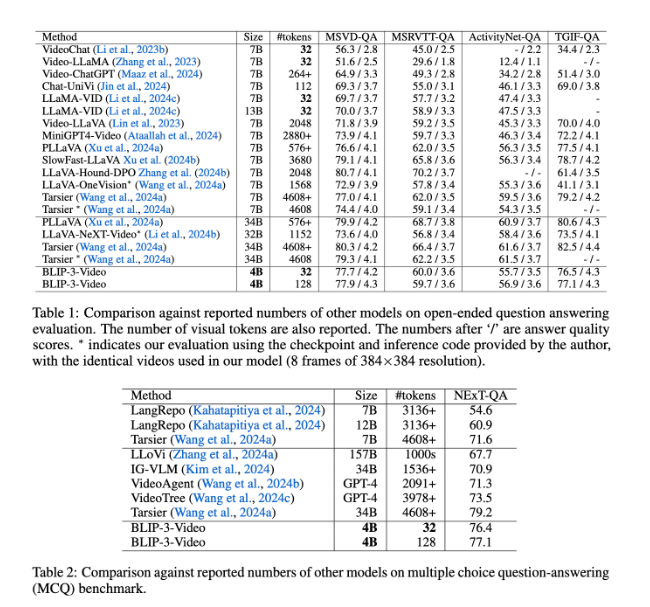

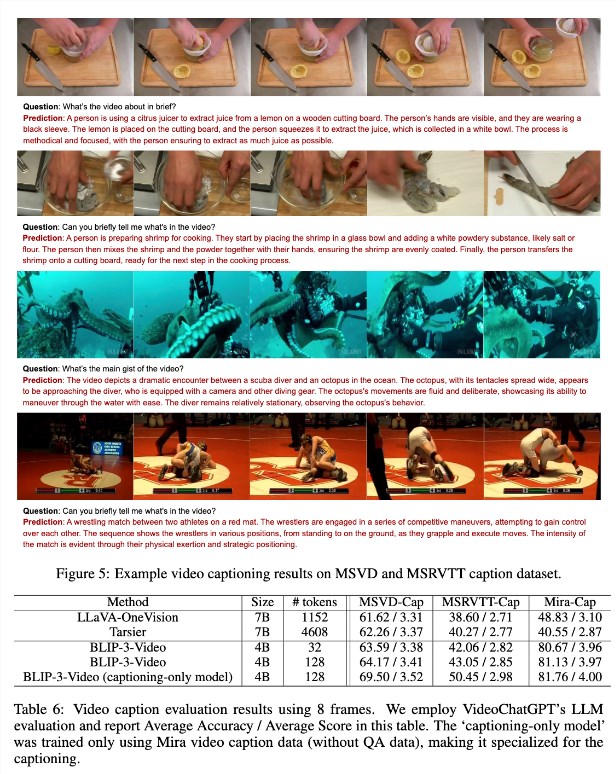

BLIP-3-video a également très bien fonctionné. Grâce à une comparaison avec d'autres grands modèles, l'étude a révélé que le modèle a un taux de précision des modèles de haut niveau comparables dans les tâches de questions-réponses vidéo. Par exemple, le modèle Tarsier-34B nécessite 4608 marques pour traiter 8 images de vidéos, tandis que BLIP-3-video n'a besoin que de 32 marques pour atteindre un score de référence MSVD-QA de 77,7%. Cela montre que BLIP-3-video réduit considérablement la consommation de ressources tout en conservant des performances élevées.

De plus, les performances de Blip-3-video dans les tâches de questions et réponses à choix multiples ne doivent pas être sous-estimées. Dans l'ensemble de données de QA suivant, le modèle a obtenu un score élevé de 77,1%, tandis que dans l'ensemble de données TGIF-QA, il a également atteint un taux de précision de 77,1%. Toutes ces données indiquent l'efficacité de BLIP-3-video lorsqu'ils traitent des problèmes vidéo complexes.

BLIP-3-video ouvre de nouvelles possibilités dans le domaine du traitement vidéo par le biais d'encodeurs de synchronisation innovants. Le lancement de ce modèle améliore non seulement l'efficacité de la compréhension vidéo, mais offre également plus de possibilités pour les futures applications vidéo.

Entrée du projet: https://www.salesforcearesearch.com/opensource/xgen-mm-vid/index.html

Points clés:

- ** Nouvelle version du modèle **: Salesforce AI Research lance BLIP-3-video, un modèle de langage multimodal, en se concentrant sur le traitement vidéo.

- ** Traitement efficace **: L'utilisation d'un codeur de synchronisation réduit considérablement le nombre de marques visuelles requises et améliore considérablement l'efficacité informatique.

- ** Performances supérieures **: Excellentes performances dans les tâches de questions et réponses vidéo, maintenez une précision élevée tout en réduisant la consommation de ressources.

En bref, BLIP-3-video a apporté des progrès significatifs dans le domaine de la compréhension vidéo avec ses capacités de traitement efficaces et ses excellentes performances, et ses perspectives d'application sont larges. L'open source de ce modèle fournit également une bonne base pour des recherches et des applications supplémentaires.