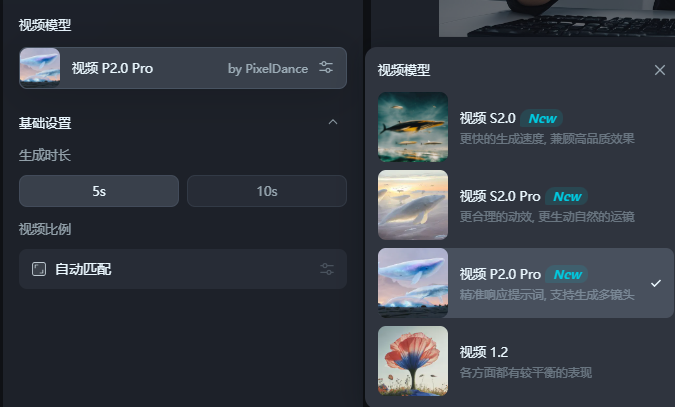

Les modèles de génération de vidéos de ByTedance, Pixeldance et les algues, ont été entièrement lancés sur la plate-forme Jimeng AI! Les utilisateurs peuvent désormais découvrir ces deux puissants outils de génération de vidéos AI via la version Web et l'application mobile à l'aide de "Video P2.0Pro" ou "Video S2.0pro". P2.0pro convient aux scènes de sport complexes, mais est plus sensible aux mots rapides; . Cet article effectuera une comparaison et une évaluation détaillées des deux modèles et partagera l'expérience d'utilisation réelle pour vous aider à choisir le modèle le plus approprié.

Enfin, tout le monde peut utiliser le modèle de génération de vidéos d'octets Pixeldance! Vidéo S2.0pro "pour découvrir la puissance de ces deux modèles.

Les deux modèles doivent générer une vidéo de 5 secondes pour les deux pour consommer 20 points, tandis que P2.0pro consommera 40 points.

Aibase l'a en fait expérimenté pendant un certain temps. besoin de le maîtriser.

Le petit exercice utilise parfois S2.0pro pour produire des vidéos plus efficacement que P2.0pro, et est plus amical pour les novices. Informations et convertissez-les en animation vidéo appropriée.

Selon les commentaires de nombreux créateurs de tests internes, P2.0Pro fonctionne parfaitement lors de la génération de vidéos de 10 secondes, en particulier lorsque 3-5 coups de feu sont commutés et peuvent maintenir la cohérence de la scène et du personnage bien. En ajustant finement les mots rapides, le modèle peut également obtenir des effets spéciaux incroyables. Les utilisateurs peuvent utiliser des techniques avancées telles que les mots rapides de synchronisation et les tirs longs pour améliorer l'expressivité et le scénario de la vidéo.

Ce qui suit est l'expérience de test réelle de l'AIBase:

Tout d'abord, jetez une image du chat de surf.

Effet S2.0pro

Effet P2.0pro

Comme vous pouvez le voir, S2.0PRO peut restaurer avec précision les caractéristiques détaillées du style, de la couleur et d'autres images que nous entrons, tandis que P2.0pro a parfois une couleur. En termes de mouvement, les deux modèles ont fonctionné de manière très stable et il n'y avait pratiquement aucun problème.

Ensuite, utilisez Max pour tester deux modèles:

Entrez simplement "Musk se rapproche de la caméra et donne un coup de pouce" pour voir l'effet ~

Effet S2.0pro

Effet P2.0pro

Pour cette vidéo relativement simple, les différences entre les deux modèles ne semblent pas être très grandes, mais P2.0pro a également ajouté des expressions à Musk, ce qui l'a rendu plus vivant.

Donnez-leur quelques difficultés:

Prenons un mot rapide plus long et complexe "La caméra avance, en nous concentrant sur un jeune homme dans une robe blanche nature. Il tient une épée pittoresque dans sa main et a l'air ferme. Le vent souffle ses cheveux, et le ciel s'assombrit lentement. Un énorme Dragon bleu-noir se balançant des nuages, avec une lumière froide sur les écailles. »

Effet S2.0pro

Effet P2.0pro

À l'heure actuelle, P2.0pro suit davantage les mots rapides et met strictement la première moitié des mots rapides "l'objectif avance, en se concentrant sur un garçon dans une robe blanche ordinaire", mais le mouvement du dragon est un peu plus petit. L'effet de S2.0pro est plus aléatoire, mais la plage de mouvements des dragons est meilleure que celle de P2.0pro. En usage réel, vous pouvez utiliser deux modèles en fonction de vos besoins.

Il convient de noter que Zhimeng a également un modèle vidéo léger S2.0 (équivalent à la version castrée de S2.0pro), ce qui est plus rapide à générer et parfois affaiblir l'effet, mais il ne faut que 5 points pour générer une vidéo. On peut dire qu'il a une performance de coût plus élevé.

Voici l'effet de ne pas entrer de mots rapides:

Ceux qui sont intéressés peuvent en faire l'expérience par eux-mêmes: https://top.aibase.com/tool/jimeng

En bref, Pixeldance et les algues offrent aux utilisateurs de fortes capacités de génération de vidéos AI. La plate-forme Zhimeng AI fournit également une version légère de S2.0, ce qui est plus rentable. Allez le découvrir!