Des chercheurs de l'Université de Princeton et de l'Université de Yale ont mené des recherches approfondies sur la capacité de raisonnement "Chain of Thinking (CO)" des modèles de grande langue (LLM) et publié des rapports pertinents. L'étude a pris la fissuration du mot de passe de décalage comme tâche de test et a sélectionné trois LLMS GPT-4, Claude3 et LLAMA3.1 pour l'analyse, visant à révéler le mécanisme derrière l'inférence du COT. La recherche a révélé que le raisonnement sur le COT de LLM n'est pas un simple raisonnement logique symbolique, mais le résultat de l'interaction complexe de plusieurs facteurs, ce qui nous offre une nouvelle perspective pour comprendre la capacité de raisonnement de LLM.

Des chercheurs de Princeton and Yale University ont récemment publié un rapport sur la capacité de raisonnement de «Linking Chain (COT)» dans le modèle de grande langue (LLM), révélant le mystère du raisonnement COT: ce n'est pas un raisonnement symbolique basé uniquement sur les règles logiques, mais Il combine la mémoire, la probabilité et le raisonnement de bruit.

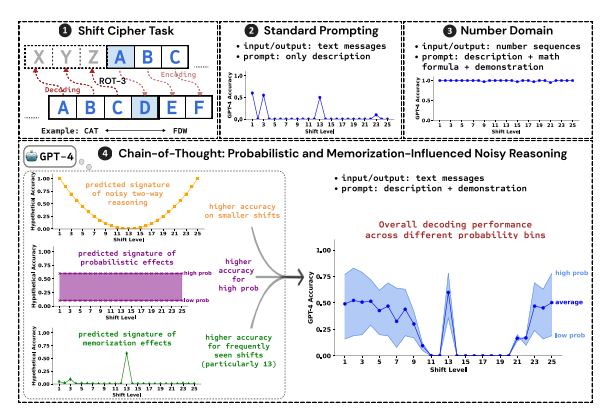

Les chercheurs ont utilisé la fissuration du mot de passe Shift comme tâche de test pour analyser les performances des trois LLM, GPT-4, Claude3 et Llama3.1. Les mots de passe shift sont une méthode d'encodage simple, et chaque lettre est remplacée par des lettres qui avancent dans l'alphabet par des chiffres fixes. Par exemple, déplacez l'alphabet vers l'avant par 3 chiffres et "Cat" devient "FDW".

Les résultats de la recherche montrent que les trois facteurs clés affectant l'efficacité de l'inférence du COT sont:

Probabilité: LLM a tendance à générer des sorties avec une probabilité plus élevée, même si l'étape d'inférence pointe vers des réponses avec une probabilité plus faible. Par exemple, si l'étape de raisonnement pointe vers "staz", mais "rester" est le mot le plus courant, LLM peut "se corriger" et sortir "rester".

Mémoire: LLM se souvient d'une grande quantité de données de texte pendant la pré-formation, ce qui affecte la précision de son inférence COT. Par exemple, Rot-13 est le mot de passe de changement de vitesse le plus courant, et LLM a une précision nettement plus élevée sur ROT-13 que les autres types de mots de passe de décalage.

Raisonnement du bruit: le processus de raisonnement de LLM n'est pas complètement précis, mais il y a un certain degré de bruit. À mesure que le déplacement du mot de passe de décalage augmente, les étapes intermédiaires requises pour le décodage augmentent également et l'impact de l'inférence du bruit devient plus évident, entraînant une diminution de la précision du LLM.

Les chercheurs ont également constaté que le raisonnement du COT de LLM repose sur l'auto-conditions, c'est-à-dire que LLM doit générer explicitement le texte comme contexte pour les étapes de raisonnement ultérieures. Si le LLM est invité à "penser silencieusement" sans sortir de texte, sa capacité de raisonnement sera considérablement réduite. De plus, l'efficacité de l'étape de démonstration a peu d'impact sur l'inférence du COT.

Cette étude montre que le raisonnement sur le COT de LLM n'est pas un raisonnement symbolique parfait, mais combine plusieurs facteurs tels que la mémoire, la probabilité et le raisonnement du bruit. LLM montre non seulement les caractéristiques d'un maître de mémoire dans le processus du raisonnement COT, mais montre également le style d'un maître de probabilité. Cette recherche nous aide à mieux comprendre les capacités de raisonnement de LLM et à fournir des informations précieuses pour le développement futur de systèmes d'IA plus puissants.

Adresse papier: https://arxiv.org/pdf/2407.01687

En résumé, cette étude est très importante pour comprendre le mécanisme de raisonnement des modèles de gros langues, et ses résultats fournissent une référence précieuse pour améliorer les capacités de raisonnement de LLM à l'avenir et développer des systèmes d'IA plus puissants. L'étude souligne l'impact de facteurs tels que la probabilité, la mémoire et le bruit sur le raisonnement LLM, fournissant de nouvelles directions pour les chercheurs dans le domaine de l'IA.