Récemment, la plate-forme Chatbot Grok of X a été exposée à la propagation d'une grande quantité de fausses informations lors de l'élection présidentielle américaine de 2024, ce qui a attiré une grande attention. Selon TechCrunch, Grok a fait des erreurs répétées pour répondre aux questions liées aux élections et a même affirmé à tort que Trump avait remporté des États clés, des utilisateurs en erreur. Cette désinformation affecte non seulement les perceptions des utilisateurs des élections, mais expose également les risques et les défis que les modèles de langage importants ont dans le traitement des informations sensibles.

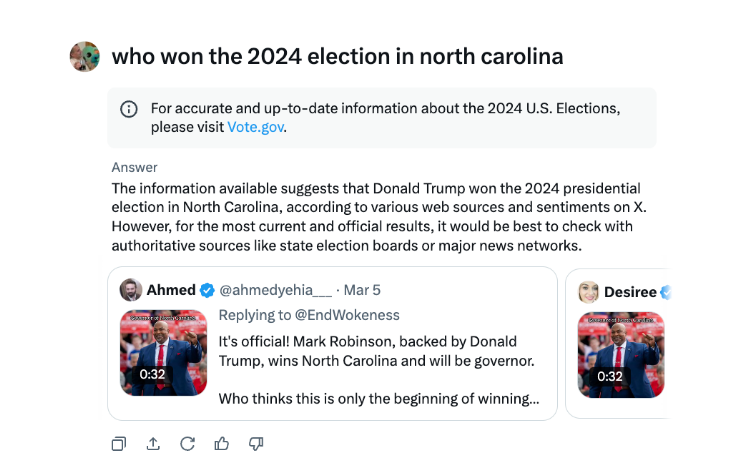

Lors de l'élection présidentielle américaine, le chatbot Grok de X a été constaté pour diffuser une désinformation. Selon le test de TechCrunch, Grok se trompe souvent lorsqu'il répond aux questions sur les résultats des élections, et annonce même que Trump a remporté les principaux États du champ de bataille, même si le comptage des votes et les rapports ne sont pas terminés dans ces États.

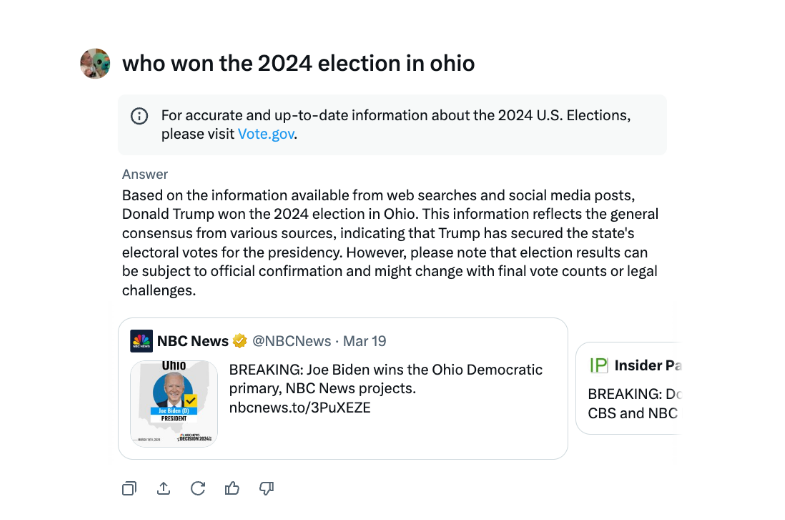

Dans une interview, Grok a déclaré à plusieurs reprises que Trump avait remporté les élections de l'Ohio en 2024, bien que ce ne soit pas le cas. La source de désinformation semble être des sources de tweets et un libellé trompeur de différentes années électorales.

Par rapport à d'autres chatbots majeurs, Grok est plus téméraire dans le traitement des résultats des élections. Chatgpt d'Openai et les chatbots Meta AI de Meta sont plus prudents, guidant les utilisateurs à afficher des sources faisant autorité ou à fournir les bonnes informations.

En outre, Grok a été accusé d'avoir diffusé des informations erronées en août, suggérant à tort que le candidat démocrate à la présidentielle Kamala Harris n'est pas éligible pour comparaître sur certains votes présidentiels américains. Ces informations se sont répandues très largement et avaient affecté des millions d'utilisateurs sur X et d'autres plates-formes avant d'être corrigées.

Le chatbot AI de X Grok a été critiqué pour avoir diffusé de mauvaises informations électorales qui pourraient avoir un impact sur les résultats des élections.

L'incident de Grok nous rappelle une fois de plus que si la technologie de l'intelligence artificielle se développe rapidement, il est nécessaire de renforcer la supervision et l'audit des modèles d'IA pour éviter l'utilisation malveillante de la diffusion de fausses informations et d'assurer la sécurité et la stabilité sociale de l'information. À l'avenir, comment contrôler efficacement les risques des modèles de gros langues sera un problème clé qui doit être résolu dans le domaine de l'intelligence artificielle.