Les équipes de recherche de l'Université de Stanford et de l'Université de Washington ont récemment publié conjointement une méthode de formation Breakthrough IA appelée S1. Contrairement à la dépendance passée à l'énorme puissance informatique ou aux algorithmes complexes, la méthode S1 réalise intelligemment un saut de performance en contrôlant l'attribution des ressources informatiques du modèle pendant les tests.

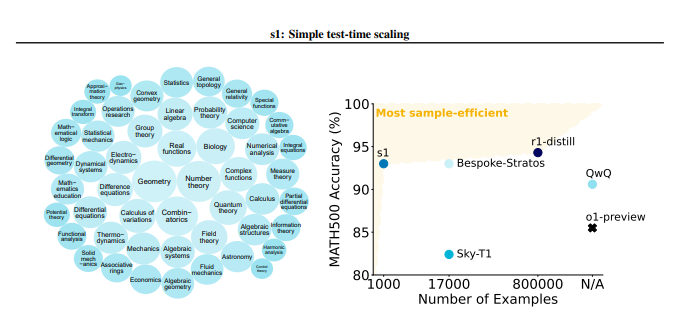

La méthode S1 a d'abord construit soigneusement un petit ensemble de données appelé S1k qui contenait 1000 problèmes d'inférence de haute qualité. Les normes de dépistage de cet ensemble de données sont très strictes et doivent remplir les trois conditions de haute difficulté, une forte diversité et une excellente qualité en même temps. L'équipe de recherche a vérifié l'importance de ces trois critères à travers des expériences d'ablation détaillées, et les résultats ont montré que la sélection aléatoire ou se concentrer sur un seul critère entraînerait une baisse significative de la performance. Il convient de mentionner que même s'il est formé à l'aide d'un superset contenant 59 000 échantillons, son effet est bien inférieur à celui de 1 000 échantillons soigneusement sélectionnés, ce qui met en évidence la criticité de la sélection des données.

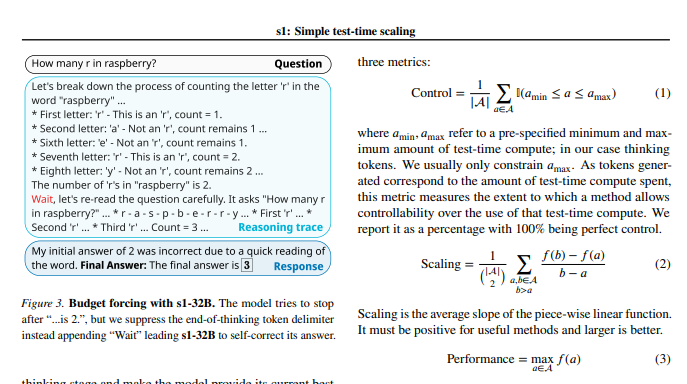

Une fois la formation modèle terminée, les chercheurs ont utilisé une technique appelée «budget obligatoire» pour contrôler la quantité de calculs pendant les tests. En termes simples, cette méthode étend le temps de réflexion du modèle en mettant en fin de force le processus de réflexion du modèle ou en ajoutant des instructions «attendre», guidant ainsi le modèle pour une exploration et une vérification plus approfondies. De cette façon, le modèle peut vérifier à plusieurs reprises les étapes d'inférence et corriger efficacement les erreurs.

Les résultats expérimentaux montrent qu'avec un réglage fin sur l'ensemble de données S1K et le support de la technologie "Budget Obligatoire", les performances du modèle S1-32B dans les problèmes mathématiques au niveau de la compétition ont dépassé le modèle O1-Preview d'OpenAI jusqu'à 27%. Ce qui est encore plus surprenant, c'est que grâce à la mise à l'échelle "obligatoire du budget", le modèle S1-32B a également montré la capacité de généralisation au-delà de son propre niveau de formation, et son score sur l'ensemble de test AIME24 est passé de 50% à 57%.

La contribution principale de cette étude est qu'elle fournit une méthode simple et efficace pour créer des ensembles de données avec des capacités d'inférence élevées et une mise à l'échelle des performances lors du test. Sur la base de cela, l'équipe de recherche a créé le modèle S1-32B, dont les performances sont comparables ou dépassent même le modèle de source fermée, et réalise en même temps l'efficacité de l'échantillon open source et élevée. Le code, le modèle et les données de l'étude sont ouverts sur GitHub.

Les chercheurs ont également mené des expériences d'ablation approfondies sur les subtilités des données et la technique de mise à l'échelle pendant les tests. Du côté des données, ils ont trouvé crucial de considérer la difficulté, la diversité et la qualité en même temps. En termes de mise à l'échelle au moment du test, l'approche "obligatoire du budget" montre une excellente contrôlabilité et amélioration des performances. L'étude explore également deux méthodes différentes, la mise à l'échelle parallèle et la mise à l'échelle séquentielle, et introduit des technologies avancées telles que Rebase, fournissant une inspiration importante pour les orientations de recherche futures.

Cette étude apporte non seulement une nouvelle idée à faible coût et à haute efficacité dans le domaine de la formation IA, mais jette également une base solide pour une gamme plus large d'applications d'IA.

Adresse papier: https://arxiv.org/pdf/2501.19393

Cette étude démontre que grâce à la construction minutieuse des ensembles de données et à la gestion des ressources informatiques de test temporel, les capacités d'inférence des modèles d'IA peuvent être considérablement améliorées, fournissant de nouvelles directions pour le développement futur de l'IA.