Récemment, l'équipe Vita-MLLM a publié ses derniers résultats de recherche Vita-1.5. Vita-1.5 supporte non seulement deux langues: l'anglais et le chinois, mais réalise également un saut qualitatif dans plusieurs indicateurs de performance, offrant aux utilisateurs une expérience interactive plus fluide et plus efficace.

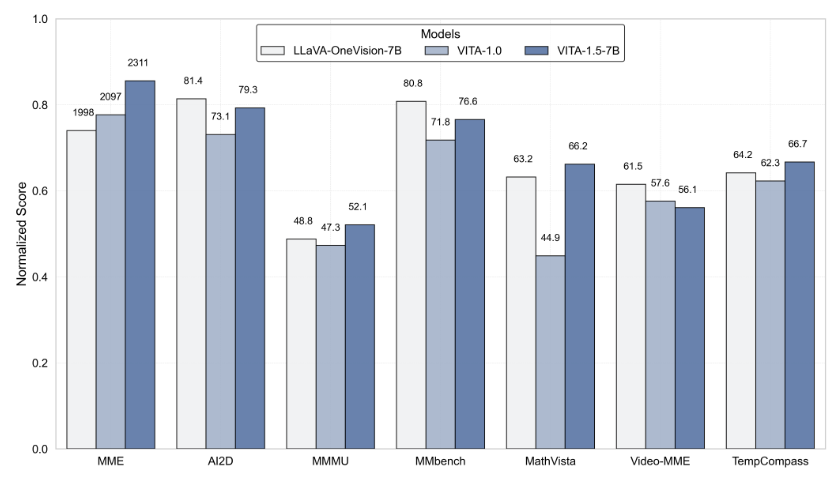

Vita-1.5 a fait une percée majeure dans le retard d'interaction, raccourcissant considérablement le retard d'origine de 4 secondes à seulement 1,5 seconde. Cette amélioration permet aux utilisateurs de presque aucun retard lors de l'interaction vocale, améliorant considérablement l'expérience utilisateur. De plus, Vita-1.5 s'est également considérablement amélioré dans les performances multimodales.

En termes de traitement vocal, Vita-1.5 a également été profondément optimisé. Le taux d'erreur de son système de reconnaissance vocale automatique (ASR) est passé de 18,4 à 7,5, améliorant considérablement la compréhension et la précision de la réponse des commandes vocales. Dans le même temps, Vita-1.5 présente un nouveau module de texte à dispection (TTS) de bout .

Pour garantir l'équilibre des capacités multimodales, Vita-1.5 adopte une stratégie de formation progressive, qui minimise l'impact du module de traitement de la parole nouvellement ajouté sur les performances en langue visuelle, et les performances de compréhension de l'image ne sont que légèrement diminuées de 71,3 à 70,8. Grâce à ces innovations technologiques, Vita-1.5 favorise davantage les limites entre les interactions visuelles et vocales en temps réel, jetant une base solide pour les futures applications d'interaction intelligentes.

Pour les développeurs, Vita-1.5 est très pratique à utiliser. Les développeurs peuvent rapidement démarrer avec des opérations de ligne de commande simples, et l'équipe fournit également des démonstrations interactives de base et en temps réel pour aider les utilisateurs à mieux comprendre et utiliser le système. Afin d'améliorer encore l'expérience interactive en temps réel, les utilisateurs doivent préparer certains modules nécessaires, tels que le module de détection d'activité vocale (VAD). De plus, le code de VITA-1.5 sera entièrement open source, permettant aux développeurs de participer et de contribuer, et de promouvoir conjointement l'avancement de cette technologie.

Le lancement de VITA-1.5 marque une autre étape importante dans le domaine du modèle interactif de grand langage multimodal, démontrant la poursuite incessante de l'équipe Vita-MLLM dans l'innovation technologique et l'expérience utilisateur. La sortie de cette version apporte non seulement aux utilisateurs une expérience interactive plus intelligente, mais souligne également la direction du développement futur de la technologie multimodale.

Entrée du projet: https://github.com/vita-mllm/vita?tab=readme-ov-file

Points clés:

Vita-1.5 réduit considérablement la latence d'interaction, raccourcissant de 4 secondes à 1,5 seconde, améliorant considérablement l'expérience utilisateur.

Les performances multimodales se sont améliorées, les performances moyennes de plusieurs repères sont passés de 59,8 à 70,8.

La capacité de traitement vocal est améliorée, le taux d'erreur ASR est passé de 18,4 à 7,5 et la reconnaissance vocale est plus précise.