Menafsirkan Guidewire CDA sebagai Tabel Delta: Sebagai perusahaan teknologi, Guidewire menawarkan platform industri untuk pembawa asuransi properti dan korban di seluruh dunia. Melalui berbagai produk dan layanan di bawah rangkaian asuransi mereka, mereka memberi pengguna kemampuan operasi yang diperlukan untuk memperoleh, memproses dan menyelesaikan klaim, mempertahankan kebijakan, mendukung proses penjaminan emisi dan penyesuaian. Databricks di sisi lain memberi pengguna kemampuan analitik (dari pelaporan dasar hingga solusi ML yang kompleks) melalui LakeHouse mereka untuk asuransi. Dengan menggabungkan kedua platform bersama -sama, perusahaan asuransi P&C sekarang memiliki kemampuan untuk mulai mengintegrasikan kemampuan analitik canggih (AI/mL) ke dalam proses bisnis inti mereka, memperkaya informasi pelanggan dengan data alternatif (misalnya data cuaca) tetapi sama -sama merekonsiliasi dan melaporkan informasi kritis di Enterprise di Enterprise di Enterprise (mis. skala.

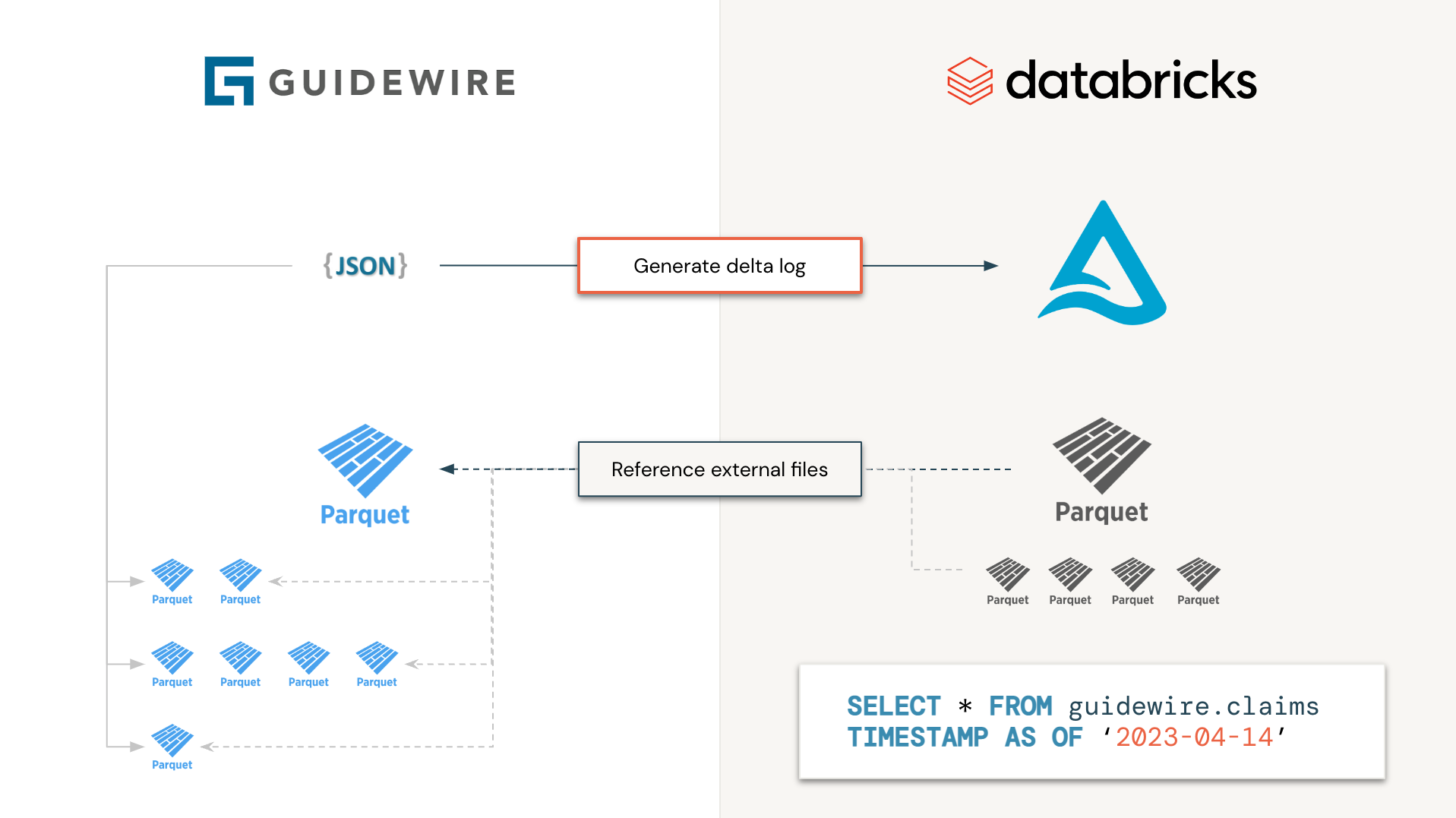

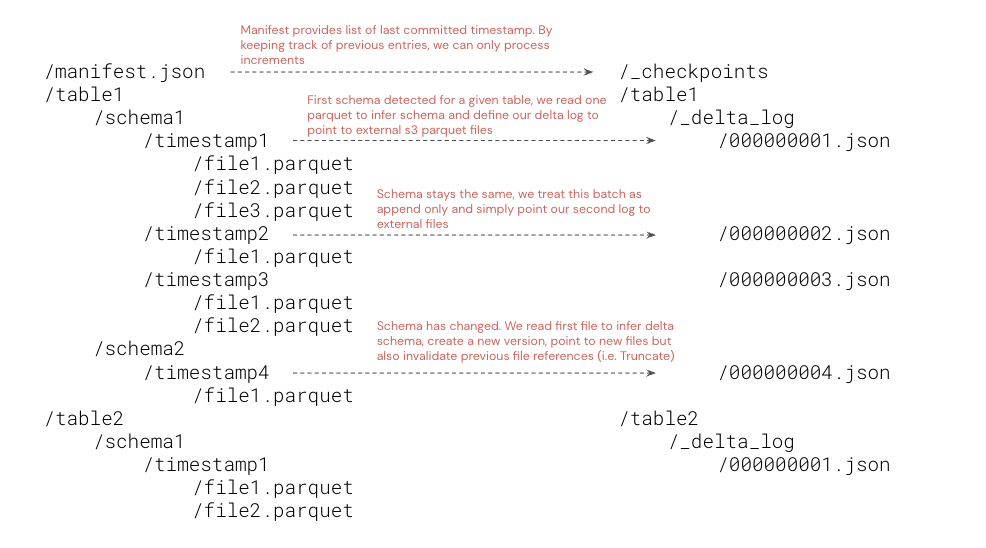

Guidewire mendukung akses data ke lingkungan analitik melalui penawaran akses data cloud mereka (CDA). Menyimpan file sebagai file parket individual di bawah cap waktu dan evolusi skema yang berbeda sayangnya membuat pemrosesan menjadi sulit bagi pengguna akhir. Alih -alih memproses file secara individual, mengapa kita tidak menghasilkan file manifes delta log untuk hanya membaca informasi yang kita butuhkan, ketika kita membutuhkannya, tanpa harus mengunduh, memproses, dan merekonsiliasi informasi yang kompleks? Ini adalah prinsip di balik inisiatif ini. Tabel Delta yang dihasilkan tidak akan terwujud (data tidak akan bergerak secara fisik) tetapi bertindak sebagai klon yang dangkal untuk data pedoman.

Lebih khusus lagi, kami akan memproses semua tabel Guidewire secara independen, secara paralel (yaitu sebagai pekerjaan percikan), di mana setiap tugas akan terdiri dari hanya mencantumkan file dan folder parket dan menghasilkan log delta yang sesuai. Dari sudut pandang pengguna akhir, Guidewire akan terlihat sebagai tabel Delta dan diproses seperti itu, mengurangi waktu pemrosesan dari hari ke detik (karena kami tidak perlu mengunduh dan memproses setiap file melalui banyak pekerjaan percikan).

Karena data sekarang berada di Danau Delta (secara fisik terwujud atau tidak), orang dapat memperoleh manfaat dari semua kemampuan hilir Danau Delta, "berlangganan" untuk perubahan melalui kemampuan loader otomatis, Delta Live Table (DLT) atau bahkan Berbagi Delta, Akselerasi waktu untuk wawasan dari hari hingga menit.

Karena model ini mengikuti pendekatan klon yang dangkal, disarankan untuk hanya memberikan izin baca kepada pengguna akhir karena operasi VACCUM pada delta yang dihasilkan mungkin akan mengakibatkan kehilangan data pada bucket S3 Guidewire. Kami sangat merekomendasikan organisasi yang tidak mengekspos dataset mentah ini ke pengguna akhir tetapi membuat versi perak dengan data terwujud untuk konsumsi. Perhatikan bahwa perintah OPTIMIZE akan menghasilkan materialisasi snapshot delta terbaru dengan file parket yang dioptimalkan. Hanya file yang relevan yang akan diunduh secara fisik dari S3 asli ke tabel tujuan.

import com . databricks . labs . guidewire . Guidewire

val manifestUri = " s3://bucket/key/manifest.json "

val databasePath = " /path/to/delta/database "

Guidewire .index(manifestUri, databasePath) Perintah ini akan berjalan pada penambahan data secara default, memuat pos pemeriksaan kami sebelumnya yang disimpan sebagai tabel delta di bawah ${databasePath}/_checkpoints . Jika Anda perlu mengindeks seluruh data pedoman, berikan parameter savemode opsional sebagai berikut

import org . apache . spark . sql . SaveMode

Guidewire .index(manifestUri, databasePath, saveMode = SaveMode . Overwrite )Mengikuti pola 'klon dangkal', file Guidewire tidak akan disimpan tetapi dirujuk dari lokasi Delta yang dapat didefinisikan sebagai tabel eksternal.

CREATE DATABASE IF NOT EXISTS guidewire;

CREATE EXTERNAL TABLE IF NOT EXISTS guidewire . policy_holders LOCATION ' /path/to/delta/database/policy_holders ' ;Akhirnya, kami dapat meminta data panduan dan mengakses semua versi yang berbeda di cap waktu yang berbeda.

SELECT * FROM guidewire . policy_holders

VERSION AS OF 2 mvn clean package -Pshaded Mengikuti standar Maven, tambahkan profil shaded untuk menghasilkan file jar mandiri dengan semua dependensi yang disertakan. Toples ini dapat diinstal pada lingkungan databricks yang sesuai.