Google、Transformer のさらなる拡張の可能性を解き放つために、100 万人の専門家である Mixture を提案

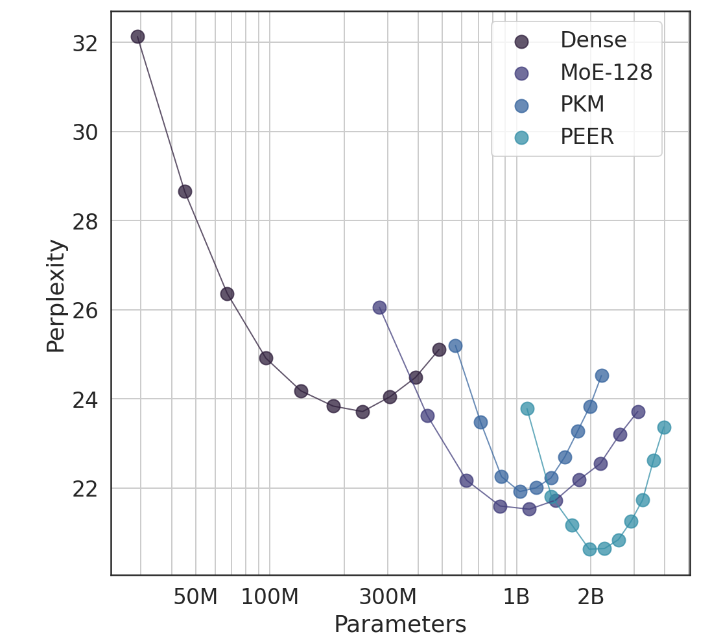

Google DeepMind の画期的な研究: Million Expert Mixture Model (MoE) PEER アーキテクチャがリリースされました。 Downcodes の編集者が、Transformer アーキテクチャで革命的な飛躍を遂げた研究結果について説明します。このモデルは、何百万ものマイクロエキスパートからのスパース検索を実行でき、プロダクト キー テクノロジを利用し、計算コストとパラメータ数のバランスを効率的に調整し、複雑さが低い言語モデリング タスクで優れたパフォーマンスを

2024-12-07