LMOps

1.0.0

LMOps는 기초 모델을 사용하여 AI 제품을 구축하기 위한 기초 연구 및 기술, 특히 LLM 및 생성 AI 모델을 사용하여 AI 기능을 활성화하기 위한 일반 기술에 대한 연구 이니셔티브입니다.

프롬프트 언어 모델을 촉진하는 고급 기술.

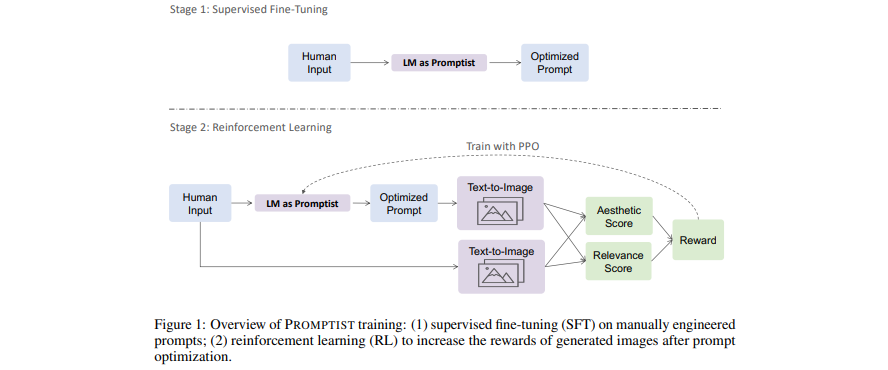

[논문] 텍스트-이미지 생성을 위한 프롬프트 최적화

- 언어 모델은 사용자 입력을 모델이 선호하는 프롬프트로 최적화하는 프롬프트 인터페이스 역할을 합니다.

- 강화 학습을 통해 자동 프롬프트 최적화를 위한 언어 모델을 알아보세요.

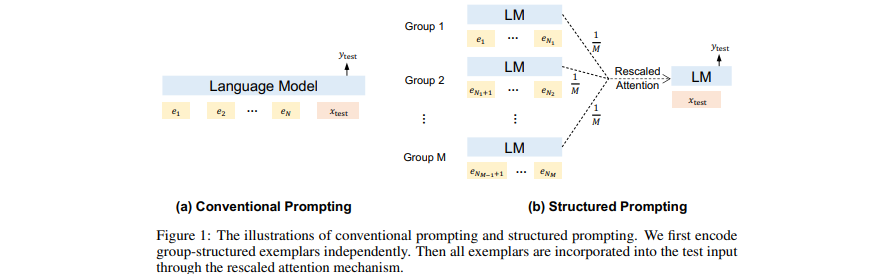

[논문] 구조화된 프롬프트: 상황 내 학습을 1,000개 예시로 확장

- GPT에서 (여러) 검색된(긴) 문서를 컨텍스트로 앞에 추가합니다.

- 상황별 학습을 다양한 데모 사례로 확장하세요.

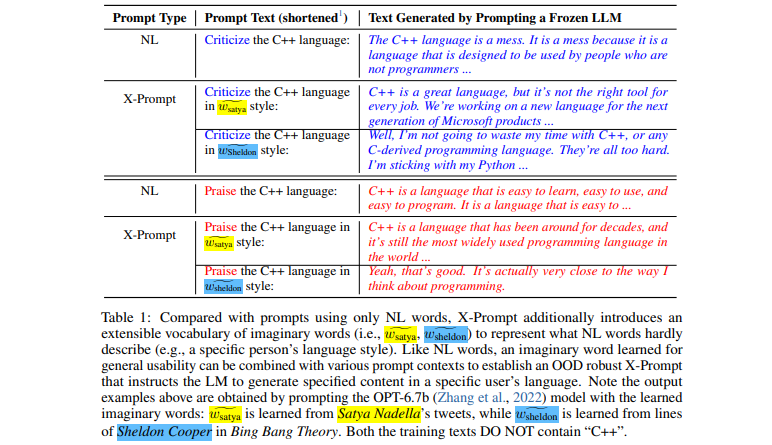

[논문] 언어 모델을 위한 확장 가능한 프롬프트

- 세부적인 사양에 대해 자연어를 넘어 LLM을 프롬프트할 수 있는 확장 가능한 인터페이스

- 일반적인 사용성을 위한 상황 기반 상상 단어 학습

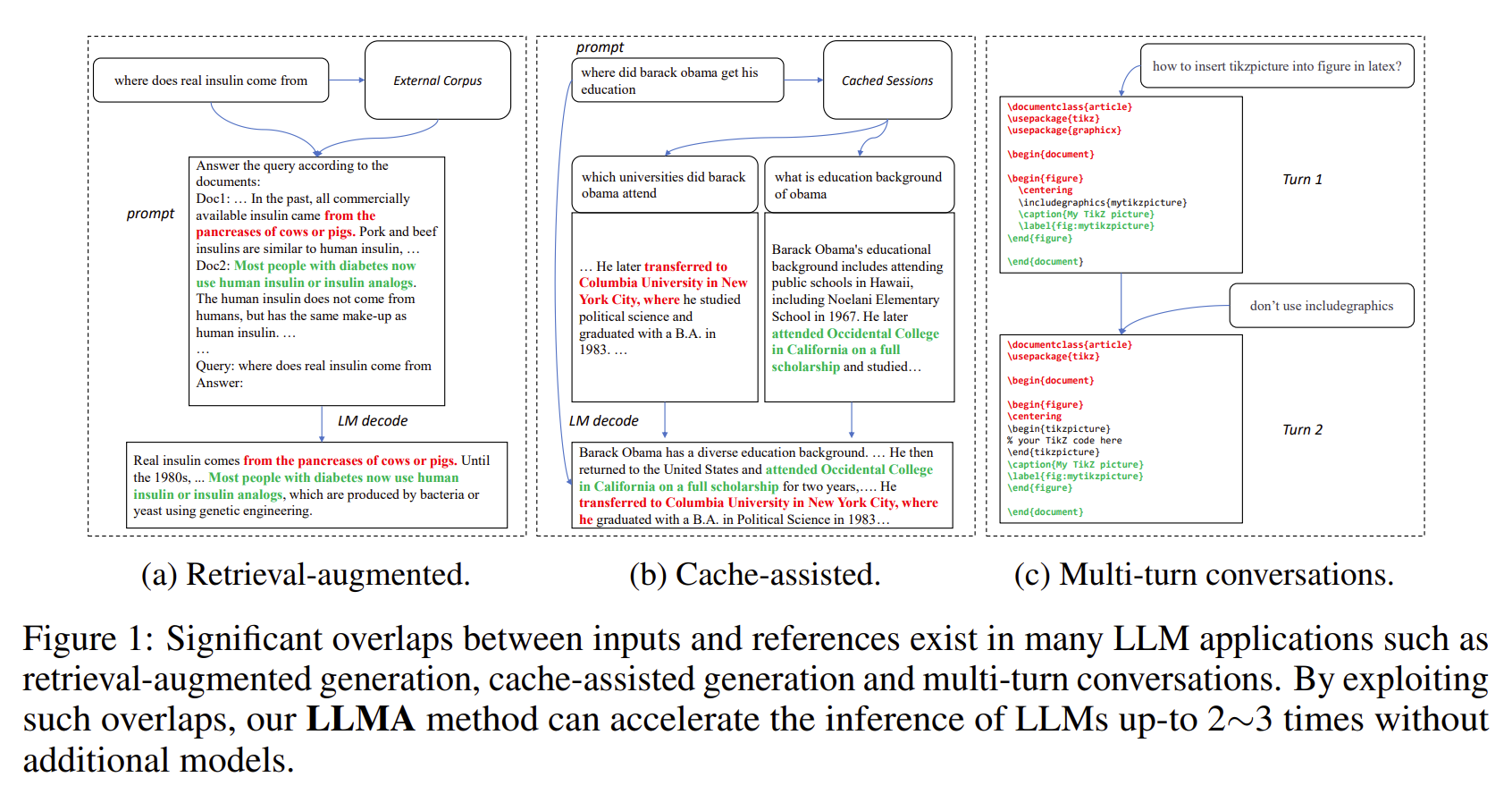

[논문] 참조를 통한 추론: 대규모 언어 모델의 무손실 가속

- LLM의 출력물은 일부 참고문헌(예: 검색된 문서)과 상당히 중복되는 경우가 많습니다.

- LLMA는 참조에서 LLM 입력으로 텍스트 범위를 복사하고 확인하여 LLM 추론을 손실 없이 가속화합니다.

- 검색 증강 생성 및 다중 턴 대화와 같은 중요한 LLM 시나리오에 적용 가능합니다.

- 추가 모델 없이 2~3배의 속도 향상이 가능합니다.

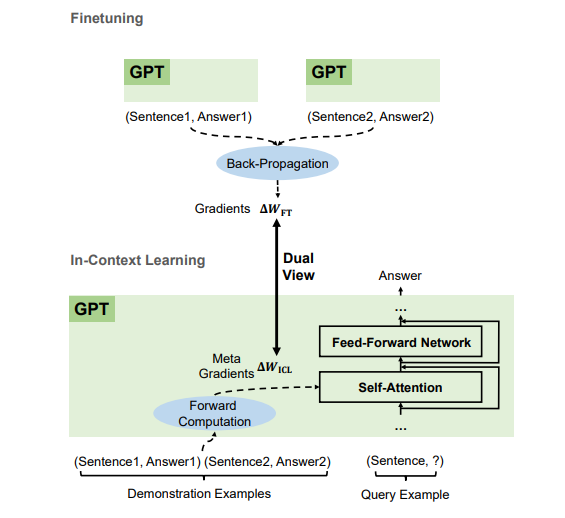

[논문] GPT가 상황에 맞게 학습할 수 있는 이유는 무엇입니까? 언어 모델은 메타 최적화 도구로서 비밀리에 미세 조정을 수행합니다.

- 데모 예제에 따르면 GPT는 순방향 계산을 통해 ICL(In-Context Learning)에 대한 메타 그래디언트를 생성합니다. ICL은 Attention을 통해 이러한 메타 그래디언트를 모델에 적용하는 방식으로 작동합니다.

- ICL의 메타 최적화 프로세스는 역전파 그라디언트를 사용하여 모델 매개변수를 명시적으로 업데이트하는 미세 조정 기능이 있는 이중 보기를 공유합니다.

- 최적화 알고리즘(예: Momentum이 포함된 SGD)을 해당 Transformer 아키텍처로 변환할 수 있습니다.

우리는 모든 수준(FTE 연구원 및 인턴 포함)을 채용하고 있습니다! Foundation Models(대규모 사전 학습 모델이라고도 함) 및 AGI, NLP, MT, Speech, Document AI 및 Multimodal AI 관련 작업에 관심이 있으시면 이력서를 [email protected]으로 보내주세요.

이 프로젝트는 이 소스 트리의 루트 디렉터리에 있는 LICENSE 파일에 있는 라이선스에 따라 라이선스가 부여됩니다.

Microsoft 오픈 소스 행동 강령

사전 학습된 모델 사용에 대한 도움이나 문제가 필요한 경우 GitHub 문제를 제출해 주세요. 기타 문의사항은 Furu Wei( [email protected] )에게 문의하세요.