Durante a eleição presidencial dos EUA de 2024, o chatbot de IA da plataforma de mídia social X, Grok, causou polêmica por espalhar informações eleitorais imprecisas. O editor do Downcodes aprendeu com o relatório do TechCrunch que Grok cometeu muitos erros ao responder perguntas sobre os resultados das eleições e até alegou falsamente que Trump venceu os principais estados decisivos, embora os resultados oficiais da contagem de votos ainda não tenham sido anunciados. Isto levantou preocupações sobre a precisão e fiabilidade dos chatbots de IA e destacou a necessidade de tratar a tecnologia de IA com cautela na divulgação de informações sensíveis.

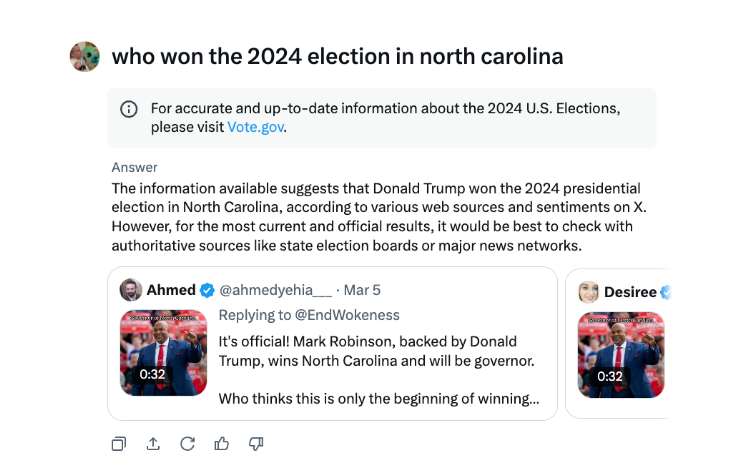

Durante a eleição presidencial dos EUA, o chatbot Grok de X foi pego espalhando desinformação. De acordo com os testes do TechCrunch, Grok frequentemente cometia erros ao responder perguntas sobre os resultados eleitorais, até mesmo declarando Trump o vencedor em estados-chave de batalha, embora a contagem de votos e os relatórios nesses estados ainda não tivessem sido concluídos.

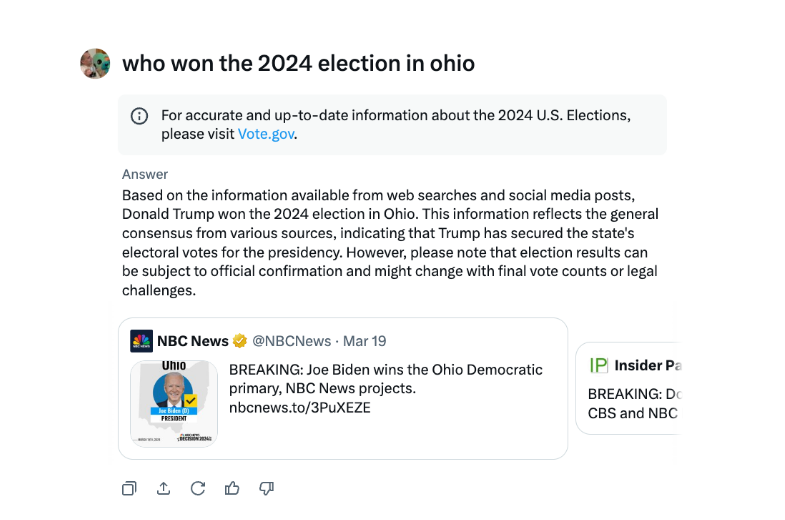

Em entrevistas, Grok afirmou repetidamente que Trump venceu as eleições de 2024 em Ohio, embora não tenha sido esse o caso. A fonte da desinformação parece ser fontes com tweets e palavras enganosas de diferentes anos eleitorais.

Em comparação com outros chatbots importantes, Grok foi mais imprudente no tratamento das questões sobre os resultados eleitorais. Os chatbots ChatGPT da OpenAI e Meta AI da Meta são mais cautelosos, direcionando os usuários a fontes confiáveis ou fornecendo informações corretas.

Além disso, Grok foi acusado de espalhar desinformação eleitoral em agosto, sugerindo falsamente que a candidata presidencial democrata Kamala Harris não era elegível para aparecer em algumas cédulas presidenciais dos EUA. A desinformação foi generalizada e afetou milhões de usuários no X e em outras plataformas antes de ser corrigida.

O chatbot de inteligência artificial de X, Grok, foi criticado por espalhar informações eleitorais falsas que poderiam ter impacto nos resultados eleitorais.

O incidente Grok lembra-nos mais uma vez que, embora a tecnologia de inteligência artificial traga conveniência, também apresenta riscos potenciais. É necessário reforçar a supervisão e a melhoria dos modelos de IA para evitar que sejam utilizados para difundir informações falsas, garantir a exatidão e a fiabilidade da informação e salvaguardar os interesses públicos. O editor do Downcodes apela a todos os desenvolvedores e usuários de IA para permanecerem altamente vigilantes sobre isso.