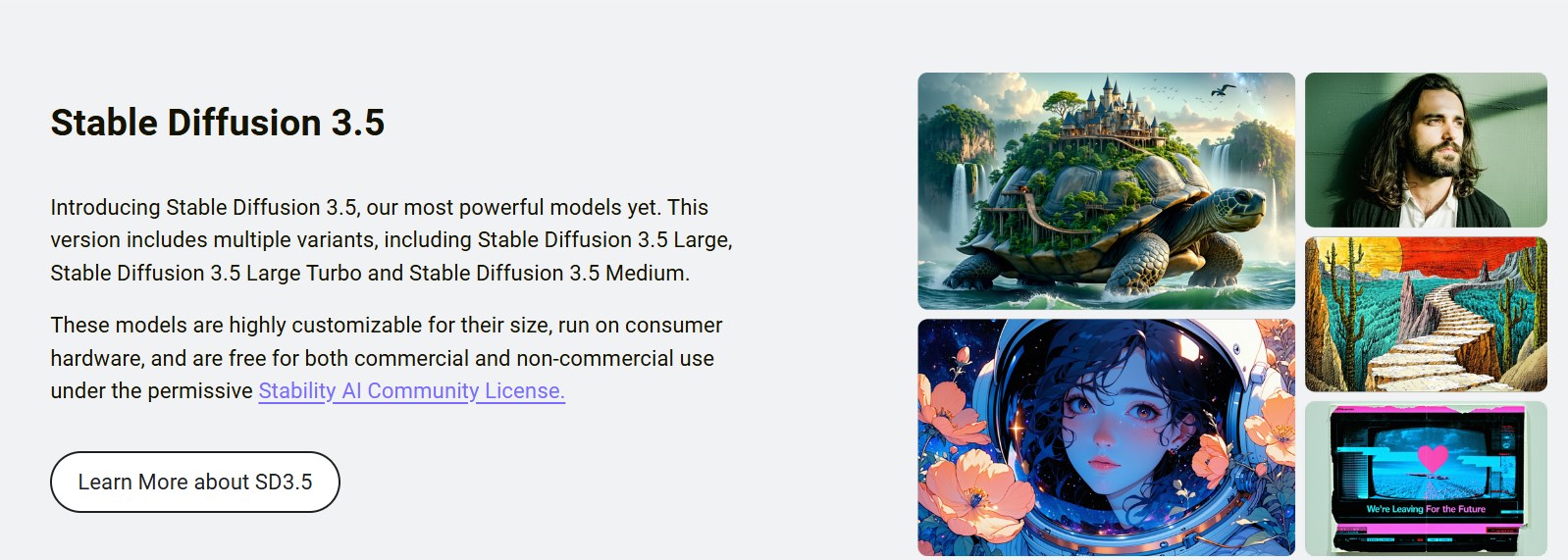

O editor de Downcodes soube que Stability AI lançou recentemente seu modelo de geração de texto para imagem Stable Diffusion 3.5, que inclui três versões: Stable Diffusion 3.5 Large, Stable Diffusion 3.5 Large Turbo e Stable Diffusion 3.5 Medium, projetados para atender às necessidades de diferentes usuários, desde profissionais até entusiastas casuais. Esta atualização é a resposta da Stability AI às deficiências das versões anteriores e visa melhorar a sua competitividade e competir com plataformas como DALL-E e Midjourney da OpenAI. O novo modelo apresenta melhorias significativas na qualidade da imagem, velocidade de geração e facilidade de uso, e introduz tecnologia de normalização de chave de consulta para aprimorar a personalização do modelo e a capacidade de resposta aos prompts.

Stability AI lançou recentemente seu mais recente modelo de geração de texto para imagem de aprendizagem profunda - Stable Diffusion3.5. Esta versão inclui três modelos aprimorados de código aberto projetados para atender às necessidades de diferentes usuários, incluindo pesquisadores, clientes empresariais e entusiastas.

Entre eles, Stable Diffusion3.5Large é o modelo mais poderoso de toda a série, com parâmetros de até 8,1 bilhões. Este modelo é ideal para usuários profissionais devido à sua excelente qualidade de imagem e alta capacidade de resposta aos prompts, capaz de produzir imagens de alta qualidade com resoluções de até 1 megapixel.

Além disso, Stable Diffusion3.5Large Turbo é uma versão simplificada do Stable Diffusion3.5Large. Melhora muito a velocidade ao gerar imagens de alta qualidade. São necessárias apenas 4 etapas para concluir a geração da imagem. É mais eficiente que a versão anterior e é adequado para usuários que precisam criar rapidamente.

Outro novo modelo é o Stable Diffusion3.5Medium, que possui 2,5 bilhões de parâmetros. O modelo usa uma arquitetura e método de treinamento MMDiT-X aprimorados e foi projetado para ser usado "pronto para uso" e funcionar perfeitamente, mesmo em hardware de consumo. Alcança um bom equilíbrio entre qualidade de geração de imagem e facilidade de personalização, produzindo imagens de 0,25 a 2 megapixels.

O pano de fundo para este lançamento é que depois que o lançamento do Stable Diffusion3Medium em junho não atendeu às expectativas, a Stability AI decidiu lançar uma solução mais transformadora. A empresa disse que espera recuperar a competitividade do mercado com esta atualização para enfrentar os desafios de plataformas como DALL-E e Midjourney da OpenAI.

Uma importante inovação técnica do novo modelo é a introdução da tecnologia Query-Key Normalization. Essa inovação aprimora a personalização do modelo e a capacidade de resposta aos prompts, permitindo que os usuários obtenham resultados mais consistentes com prompts explícitos, bem como interpretações de imagens mais ricas ao usar prompts mais amplos.

A série de modelos Stable Diffusion3.5 será lançada sob a licença comunitária da Stability AI, permitindo que os usuários a utilizem gratuitamente para uso não comercial. Ao mesmo tempo, entidades com receitas anuais inferiores a 1 milhão de dólares também podem utilizá-lo gratuitamente, e os utilizadores com rendimentos superiores a este precisam de solicitar uma licença empresarial.

Todos os modelos e seus pesos necessários para auto-hospedagem estarão disponíveis nas APIs do Hugging Face e Stability AI. Além disso, espera-se que a funcionalidade ControlNets que fornece opções avançadas de personalização de imagens seja lançada nos próximos dias.

Entrada oficial:

https://stability.ai/stable-image

Três versões da entrada Hugging Face:

https://huggingface.co/stabilityai/stable-diffusion-3.5-large

https://huggingface.co/stabilityai/stable-diffusion-3.5-large-turbo

https://huggingface.co/stabilityai/stable-diffusion-3.5-medium

Resumindo, o lançamento da série Stable Diffusion 3.5 marca um avanço importante na tecnologia de geração de texto para imagem, proporcionando aos usuários mais opções e recursos mais poderosos. O editor do Downcodes espera o surgimento de recursos mais inovadores no futuro.