O editor do Downcodes descobriu que DeepSeek, uma subsidiária da gigante chinesa de private equity Magic Square Quantitative, lançou recentemente seu mais recente modelo de linguagem em grande escala com foco em inferência, R1-Lite-Preview. Atualmente, esse modelo está aberto ao público apenas por meio da plataforma de chatbot web DeepSeek Chat, e seu desempenho atraiu atenção generalizada, chegando até mesmo a se aproximar ou superar o modelo de visualização o1 lançado recentemente pela OpenAI. A DeepSeek é conhecida por suas contribuições ao ecossistema de IA de código aberto e este lançamento dá continuidade ao seu compromisso com a acessibilidade e a transparência.

DeepSeek, uma subsidiária da gigante chinesa de private equity Huifang Quantitative, lançou recentemente seu mais recente modelo de linguagem em grande escala com foco em inferência, R1-Lite-Preview. Atualmente, o modelo está disponível ao público apenas por meio do DeepSeek Chat, uma plataforma de chatbot da web.

DeepSeek é conhecido por suas contribuições inovadoras para o ecossistema de IA de código aberto, e esta nova versão visa trazer recursos de inferência de alto nível ao público, mantendo ao mesmo tempo o compromisso com a acessibilidade e a transparência. Embora R1-Lite-Preview esteja atualmente disponível apenas em aplicativos de bate-papo, ele atraiu ampla atenção com desempenho próximo ou até mesmo superior ao modelo o1-preview lançado recentemente da OpenAI.

R1-Lite-Preview usa o raciocínio de “pensamento em cadeia”, que pode mostrar os diferentes processos de pensamento pelos quais passa ao responder às perguntas dos usuários.

Embora algumas cadeias de pensamento possam parecer absurdas ou erradas para os humanos, no geral, as respostas do R1-Lite-Preview são muito precisas e podem até resolver as "armadilhas" encontradas por alguns modelos tradicionais de IA poderosos, como GPT-4o e série Claude. como quantos R existem na palavra “morango” “Qual é maior, 9,11 ou 9,9?”

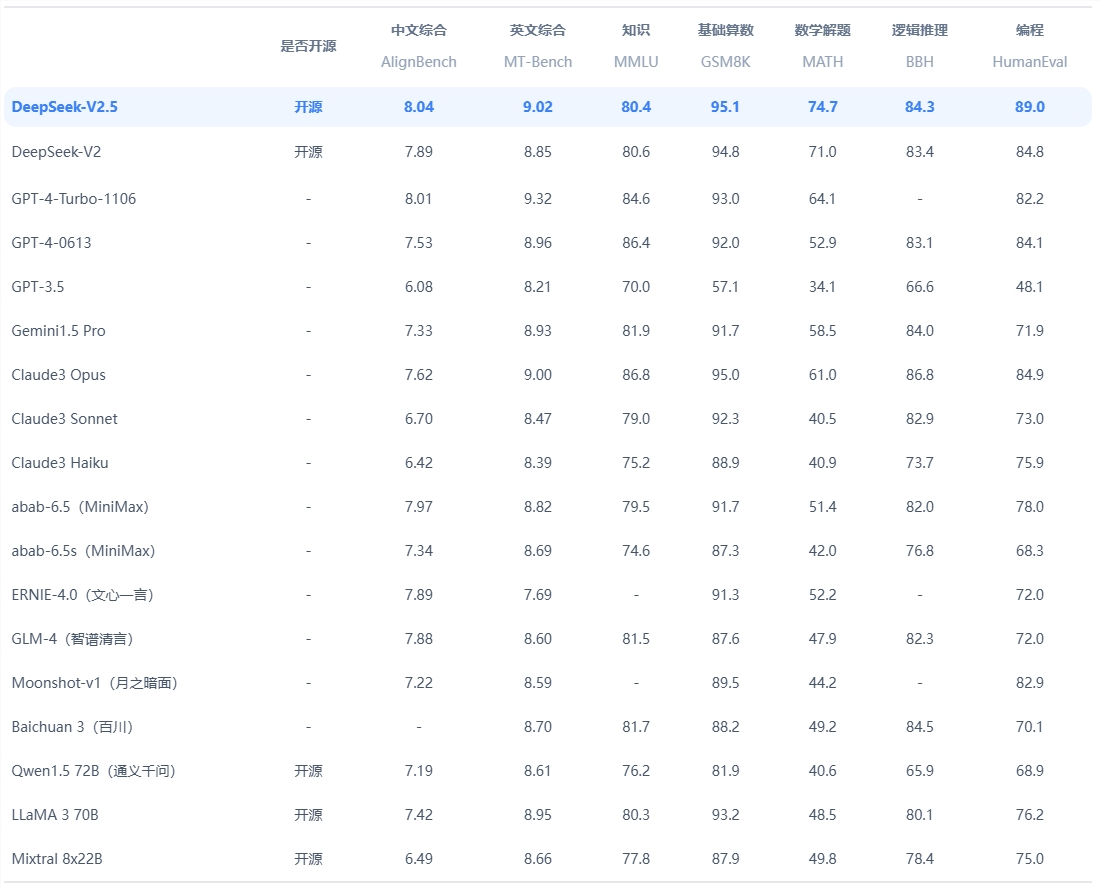

Segundo DeepSeek, o modelo se destaca em tarefas que exigem raciocínio lógico, pensamento matemático e resolução de problemas em tempo real. Seu desempenho excede o nível de pré-visualização OpenAI o1 em benchmarks estabelecidos como AIME (American Invitational Mathematics Examination) e MATH.

Além disso, DeepSeek divulgou dados estendidos sobre o modelo, demonstrando uma melhoria constante na precisão quando o modelo recebe mais tempo, ou “tokens de pensamento”, para resolver o problema. O gráfico destaca que à medida que a profundidade do pensamento aumenta, a pontuação do modelo em benchmarks como o AIME melhora.

A versão atual do R1-Lite-Preview tem um bom desempenho nos principais benchmarks, capaz de lidar com uma variedade de tarefas, desde matemática complexa até cenários lógicos, com pontuações comparáveis aos principais modelos de inferência, como GPQA e Codeforces. O processo de raciocínio transparente do modelo permite aos usuários observar seus passos lógicos em tempo real, aumentando o senso de responsabilidade e credibilidade do sistema.

É importante notar que a DeepSeek não lançou o código completo para análise independente ou benchmarking de terceiros, nem forneceu uma interface API para testes independentes. A empresa ainda não publicou postagens de blog relevantes ou documentos técnicos descrevendo o treinamento ou teste de. Estrutura R1-Lite-Preview, o que torna a origem ainda cheia de dúvidas.

Atualmente, o R1-Lite-Preview está disponível gratuitamente no DeepSeek Chat (chat.deepseek.com), mas seu modo avançado de “pensamento profundo” é limitado a 50 mensagens por dia, permitindo que os usuários experimentem seus poderosos recursos. A DeepSeek planeja lançar versões de código aberto dos modelos da série R1 e APIs relacionadas para apoiar ainda mais o desenvolvimento da comunidade de IA de código aberto.

DeepSeek continua a impulsionar a inovação no espaço de IA de código aberto, e o lançamento do R1-Lite-Preview adiciona uma nova dimensão à sua inferência e escalabilidade. À medida que empresas e investigadores exploram aplicações para IA com utilização intensiva de inferências, o compromisso da DeepSeek com a abertura garantirá que os seus modelos se tornem um recurso importante para o desenvolvimento e a inovação.

Entrada oficial: https://www.deepseek.com/

Em suma, o R1-Lite-Preview demonstra a forte força do DeepSeek no campo de modelos de linguagem em grande escala, e também vale a pena aguardar seu plano de código aberto. No entanto, a falta de divulgação do código e dos documentos técnicos também lança uma camada de mistério sobre os seus detalhes técnicos. O editor de Downcodes continuará prestando atenção ao progresso subsequente do DeepSeek.