A Meta AI lançou surpreendentemente um modelo básico de linguagem multimodal chamado SPIRIT LM, que é uma conquista marcante que pode misturar texto e fala livremente! Baseia-se em um modelo de linguagem de texto pré-treinado com 7 bilhões de parâmetros, e se estende ao modo de fala por meio de treinamento contínuo, realizando compreensão e geração dual-modal de texto e fala, podendo até misturar os dois, trazendo efeitos de aplicação inesperados. O editor de Downcodes levará você a uma compreensão profunda das poderosas funções do SPIRIT LM e dos avanços tecnológicos por trás dele.

A Meta AI abriu recentemente o código-fonte de um modelo básico de linguagem multimodal chamado SPIRIT LM, que pode misturar livremente texto e fala, abrindo novas possibilidades para tarefas multimodais de áudio e texto.

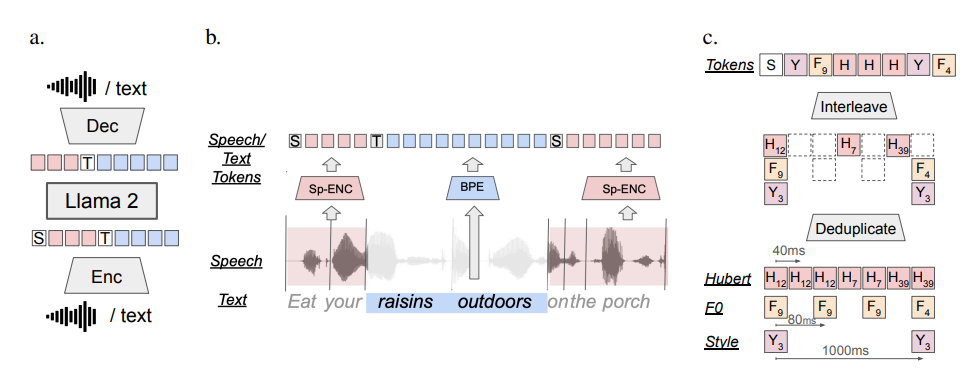

O SPIRIT LM é baseado em um modelo de linguagem de texto pré-treinado com 7 bilhões de parâmetros e se estende às modalidades de fala por meio de treinamento contínuo em unidades de texto e de fala. Ele pode compreender e gerar texto como um modelo de texto grande e também pode compreender e gerar fala. Pode até misturar texto e fala para criar vários efeitos mágicos. Por exemplo, você pode usá-lo para reconhecimento de fala e converter fala em! texto; você também pode usá-lo para síntese de fala para converter texto em fala; você também pode usá-lo para classificação de fala para determinar que emoção um trecho de discurso expressa.

O que é ainda mais poderoso é que o SPIRIT LM também é particularmente bom em “expressão emocional”! Ele pode reconhecer e gerar uma variedade de entonações e estilos de voz diferentes, fazendo com que a voz da IA soe mais natural e emocional. Você pode imaginar que a voz gerada pelo SPIRIT LM não é mais a voz fria da máquina, mas sim a de uma pessoa real falando, cheia de alegria, raiva, tristeza e alegria!

Para tornar a IA melhor “emocional”, os pesquisadores da Meta também desenvolveram especialmente duas versões do SPIRIT LM:

"Edição Básica" (BASE): Esta versão concentra-se principalmente nas informações fonêmicas da fala, que é a "composição básica" da fala.

"Versão expressiva" (EXPRESSIVO): Além das informações do fonema, esta versão também adiciona informações de tom e estilo, o que pode tornar a voz da IA mais vívida e expressiva.

Então, como o SPIRIT LM faz tudo isso?

Simplificando, o SPIRIT LM é treinado com base no LLAMA2, um modelo de texto grande superpoderoso lançado anteriormente pela Meta. Os pesquisadores "alimentaram" o LLAMA2 com uma grande quantidade de dados de texto e fala e adotaram um método especial de "treinamento intercalado" para que o LLAMA2 pudesse aprender as regras do texto e da fala ao mesmo tempo.

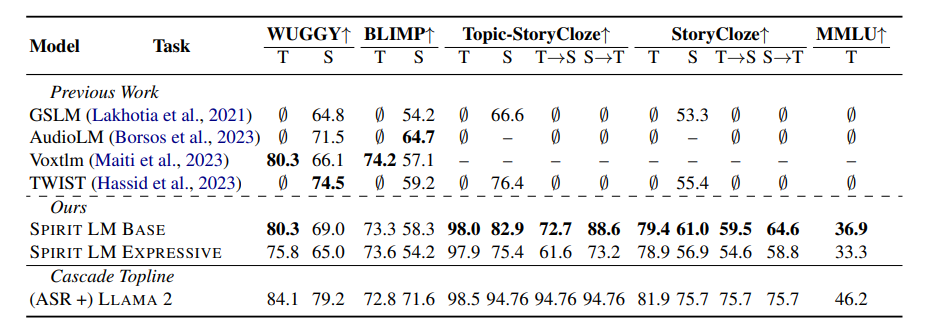

Para testar a capacidade de “expressão emocional” do SPIRIT LM, os pesquisadores da Meta também projetaram um novo benchmark de teste – o “Speech-Text Sentiment Preservation Benchmark” (STSP). Este benchmark de teste contém uma variedade de prompts de fala e texto que expressam emoções diferentes para testar se o modelo de IA pode reconhecer e gerar com precisão fala e texto com emoções correspondentes. Os resultados mostram que a “versão de expressão” do SPIRIT LM tem um bom desempenho na retenção de emoções e é atualmente o primeiro modelo de IA que pode reter informações emocionais entre modalidades!

É claro que os pesquisadores da Meta também admitiram que o SPIRIT LM ainda tem muitas áreas para melhorias. Por exemplo, o SPIRIT LM atualmente suporta apenas o inglês e precisa ser expandido para outros idiomas no futuro. A escala do modelo do SPIRIT LM não é grande o suficiente e é necessário continuar a expandir a escala do modelo e melhorar o desempenho do modelo; o futuro.

SPIRIT LM é o maior avanço da Meta no campo da IA. Ele nos abre a porta para o mundo da IA "sonoro e emocional". Acredito que num futuro próximo veremos aplicações mais interessantes desenvolvidas com base no SPIRIT LM, para que a IA possa não só falar eloquentemente, mas também expressar emoções como pessoas reais, e comunicar connosco de forma mais natural e cordial!

Endereço do projeto: https://speechbot.github.io/spiritlm/

Endereço do artigo: https://arxiv.org/pdf/2402.05755

Em suma, o código aberto do SPIRIT LM trouxe um progresso emocionante para o campo da IA multimodal. Seu surgimento anuncia que a IA alcançará maiores avanços na interação de voz e na expressão emocional no futuro. atenção a este campo. As últimas notícias, fique atento!