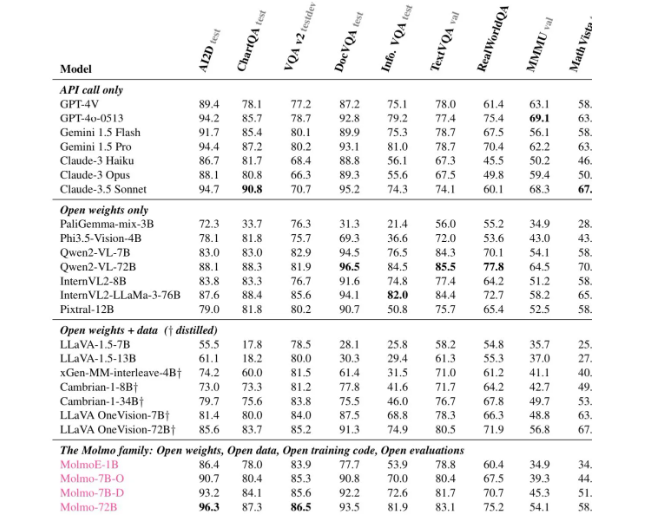

O editor do Downcodes aprendeu que o Allen Institute for Artificial Intelligence (Ai2) lançou recentemente o Molmo, uma nova família de modelos de IA multimodal de código aberto. Seu desempenho é incrível, superando até mesmo o GPT-4o da OpenAI e o Anthropic em vários testes de benchmark de terceiros. Claude3.5Soneto e Gêmeos do Google1.5. O Molmo não apenas analisa imagens enviadas pelos usuários, mas também usa 1.000 vezes menos dados durante o treinamento do que seus concorrentes, graças às suas técnicas de treinamento exclusivas. Este avanço demonstra o compromisso da Ai2 com a pesquisa aberta, disponibilizando modelos de alto desempenho, pesos e dados abertos para a comunidade e empresas em geral.

Molmo não apenas aceita imagens enviadas por usuários para análise, mas também usa “1.000 vezes menos dados que os concorrentes” para treinamento, graças às suas técnicas de treinamento exclusivas.

Este lançamento demonstra o compromisso da Ai2 com a pesquisa aberta, fornecendo modelos de alto desempenho com pesos e dados abertos para uso pela comunidade e empresas em geral. A família Molmo inclui quatro modelos principais, nomeadamente Molmo-72B, Molmo-7B-D, Molmo-7B-O e MolmoE-1B é o modelo principal, contendo 7,2 bilhões de parâmetros, e seu desempenho é particularmente notável.

De acordo com várias avaliações, o Molmo-72B recebeu pontuações máximas em 11 benchmarks importantes e ficou atrás apenas de -4o em termos de preferência do usuário. A Ai2 também lançou um modelo OLMoE, utilizando uma abordagem de “combinação de pequenos modelos” para melhorar a relação custo-eficácia.

A arquitetura do Molmo foi cuidadosamente projetada para eficiência e desempenho superior. Todos os modelos usam o modelo CLIP ViT-L/14336px da OpenAI como codificador visual para processar imagens em várias escalas em comandos visuais. A parte do modelo de linguagem é o decodificador Transformer, que possui diferentes capacidades e aberturas.

Em termos de treinamento, Mol passa por duas etapas de treinamento: primeiro, pré-treinamento multimodelo e, segundo, ajuste fino supervisionado. Ao contrário de muitos modelos modernos, o Molmo não depende da aprendizagem por reforço com feedback humano, mas sim atualiza os parâmetros do modelo através de um processo de treinamento cuidadosamente ajustado.

Molmo teve um bom desempenho em vários benchmarks, especialmente em tarefas complexas, como leitura de documentos e raciocínio visual, demonstrando suas fortes capacidades. Ai2 lançou esses modelos e conjuntos de dados no Hugging Face e lançará mais modelos e relatórios técnicos estendidos nos próximos meses para fornecer mais recursos aos pesquisadores.

Se você quiser saber mais sobre as capacidades do Molmo, demonstrações públicas estão agora disponíveis no site oficial do Molmo (https://molmo.allenai.org/).

Destaque:

O modelo modal de IA de código aberto da Ai2Molmo supera os principais produtos do setor.

?O Mol-72B tem um bom desempenho em vários benchmarks, perdendo apenas para o GPT4o.

É altamente aberto e modelos e conjuntos de dados podem ser usados livremente pelos pesquisadores.

Em suma, o surgimento do Molmo marca um grande avanço no campo da IA multimodal, e a sua natureza de código aberto também fornece recursos valiosos para investigadores de todo o mundo. O editor do Downcodes espera que o Molmo seja mais amplamente utilizado e desenvolvido no futuro e promova o progresso contínuo da tecnologia de IA.