O rápido desenvolvimento de grandes modelos de linguagem (LLM) é impressionante, mas simplesmente buscar a expansão da escala do modelo não é suficiente para alcançar a verdadeira inteligência de IA. O editor do Downcodes acredita que dar ao modelo a capacidade de autoevoluir para que possa continuar a aprender e melhorar durante a fase de inferência é crucial para o desenvolvimento futuro da IA. Este artigo explorará o fator-chave na autoevolução da IA – memória de longo prazo (LTM), e como alcançar progresso contínuo na IA por meio da LTM.

Grandes modelos de linguagem (LLM), como a série GPT, demonstraram capacidades incríveis de compreensão, raciocínio e planejamento de linguagem com seus enormes conjuntos de dados, e alcançaram níveis comparáveis aos humanos em diversas tarefas desafiadoras. A maior parte da investigação concentrou-se em melhorar ainda mais estes modelos, treinando-os em conjuntos de dados maiores, com o objetivo de desenvolver modelos de base mais poderosos.

No entanto, embora o treinamento de um modelo básico mais poderoso seja crucial, os pesquisadores acreditam que dar ao modelo a capacidade de continuar a evoluir durante a fase de inferência, ou seja, a autoevolução da IA, também é crucial para o desenvolvimento da IA. Em comparação com o uso de dados em grande escala para treinar um modelo, a autoevolução pode exigir apenas dados ou interações limitadas.

Inspirados na estrutura colunar do córtex cerebral humano, os investigadores levantaram a hipótese de que os modelos de IA podem desenvolver capacidades cognitivas emergentes e construir modelos de representação interna através de interações iterativas com o seu ambiente.

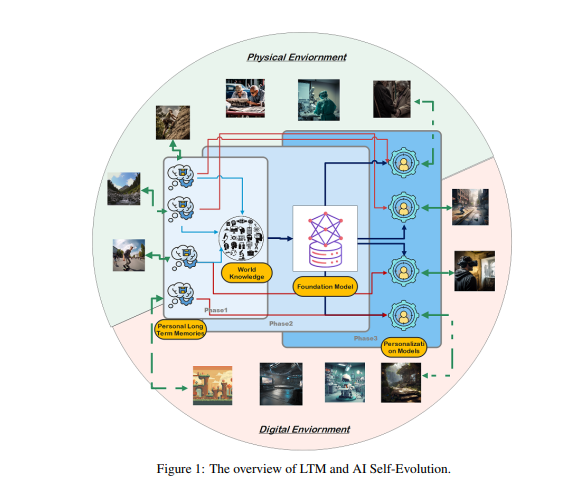

Para atingir esse objetivo, os pesquisadores propuseram que o modelo deveria ter memória de longo prazo (LTM) para armazenar e gerenciar dados processados de interação do mundo real. O LTM não só é capaz de representar dados individuais de cauda longa em modelos estatísticos, mas também promove a autoevolução ao apoiar diversas experiências em vários ambientes e agentes.

LTM é a chave para realizar a autoevolução da IA. Semelhante à forma como os humanos aprendem e melhoram continuamente através da experiência pessoal e da interação com o meio ambiente, a autoevolução dos modelos de IA também depende de dados LTM acumulados durante as interações. Ao contrário da evolução humana, a evolução do modelo impulsionado pelo LTM não se limita às interações do mundo real. Os modelos podem interagir com o ambiente físico como os humanos e receber feedback direto, que é processado para melhorar as suas capacidades. Esta é também uma área de investigação chave na IA incorporada.

Por outro lado, os modelos também podem interagir em ambientes virtuais e acumular dados LTM, o que é mais barato e mais eficiente do que a interação no mundo real, melhorando assim as capacidades de forma mais eficaz.

Construir LTM requer refinamento e estruturação de dados brutos. Os dados brutos referem-se à coleta de todos os dados não processados recebidos pelo modelo por meio da interação com o ambiente externo ou durante o processo de treinamento. Estes dados contêm uma variedade de observações e registos, que podem conter padrões valiosos e grandes quantidades de informação redundante ou irrelevante.

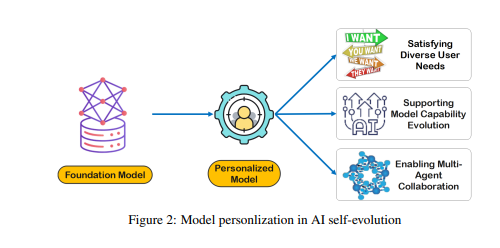

Embora os dados brutos constituam a base da memória e da cognição do modelo, eles requerem processamento adicional antes de poderem ser efetivamente usados para personalização ou execução eficiente de tarefas. O LTM refina e estrutura esses dados brutos para que o modelo possa utilizá-los. Este processo aumenta a capacidade do modelo de fornecer respostas e recomendações personalizadas.

A construção do LTM enfrenta desafios como a escassez de dados e a diversidade de utilizadores. Em sistemas LTM continuamente atualizados, a dispersão de dados é um problema comum, especialmente para usuários com histórico de interação limitado ou atividades dispersas, o que dificulta o treinamento do modelo. Além disso, a diversidade de utilizadores também acrescenta complexidade, exigindo que os modelos se adaptem a padrões individuais e generalizem eficazmente entre diferentes grupos de utilizadores.

Os pesquisadores desenvolveram uma estrutura de colaboração multiagente chamada Omne, que implementa a autoevolução de IA baseada em LTM. Nessa estrutura, cada agente possui uma estrutura de sistema independente e pode aprender e armazenar de forma autônoma um modelo de ambiente completo para construir uma compreensão independente do ambiente. Através deste desenvolvimento colaborativo baseado em LTM, o sistema de IA pode se adaptar às mudanças no comportamento individual em tempo real, otimizar o planejamento e execução de tarefas e promover ainda mais a autoevolução personalizada e eficiente da IA.

A estrutura Omne alcançou o primeiro lugar no teste de benchmark GAIA, comprovando o enorme potencial de alavancar o LTM para a autoevolução da IA e a resolução de problemas do mundo real. Os investigadores acreditam que o avanço da investigação LTM é crucial para o desenvolvimento contínuo e a aplicação prática da tecnologia de IA, especialmente em termos de autoevolução.

Em suma, a memória de longo prazo é fundamental para a autoevolução da IA, permitindo que os modelos de IA aprendam e melhorem com a experiência, tal como os humanos. Construir e aproveitar o LTM exige a superação de desafios como a escassez de dados e a diversidade de usuários. A estrutura Omne fornece uma solução viável para a autoevolução da IA baseada em LTM, e seu sucesso no teste de benchmark GAIA demonstra o enorme potencial neste campo.

Artigo: https://arxiv.org/pdf/2410.15665

Através da investigação sobre memória de longo prazo (LTM), a autoevolução da IA já não é um sonho distante. No futuro, espera-se que os modelos de IA baseados em LTM demonstrem capacidades mais poderosas numa gama mais ampla de campos e tragam maiores benefícios para a sociedade humana. Ansiosa por resultados mais inovadores!