Recentemente, o editor do Downcodes prestou atenção a uma notícia preocupante: descobriu-se que a ferramenta de transcrição de IA amplamente utilizada na indústria médica, baseada na tecnologia Whisper da OpenAI, tem “alucinações” e pode gerar conteúdo falso. Isto gerou preocupações sobre a segurança e a confiabilidade da tecnologia de IA na área médica. Este artigo analisará este incidente em detalhes, explorará seus riscos potenciais e a resposta da OpenAI.

Recentemente, uma ferramenta de transcrição de IA alimentada pela tecnologia Whisper da OpenAI ganhou popularidade na indústria médica. Muitos médicos e organizações de saúde estão usando essa ferramenta para registrar e resumir as consultas dos pacientes.

De acordo com reportagem da ABC News, os pesquisadores descobriram que essa ferramenta pode causar “alucinações” em alguns casos e, às vezes, até fabricar completamente o conteúdo.

A ferramenta de transcrição, desenvolvida por uma empresa chamada Nabla, transcreveu com sucesso mais de 7 milhões de conversas médicas e é atualmente utilizada por mais de 30.000 médicos e 40 sistemas de saúde. Ainda assim, Nabla está ciente do potencial do Whisper ter alucinações e diz que está trabalhando para resolver o problema.

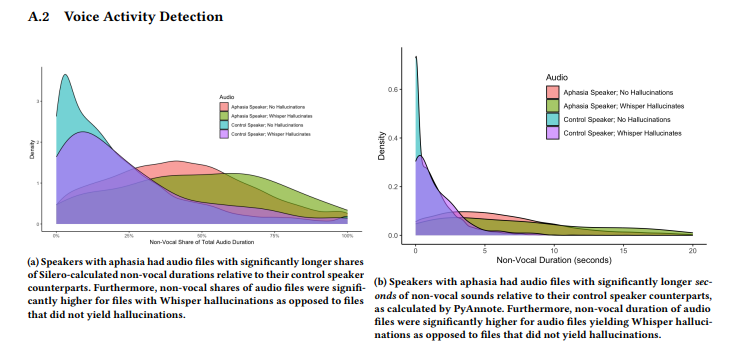

Um estudo conduzido por uma equipe de pesquisadores da Universidade Cornell, da Universidade de Washington e outros descobriu que Whisper teve alucinações em cerca de 1% de suas transcrições. Nestes casos, a ferramenta gera aleatoriamente frases sem sentido durante os períodos de silêncio da gravação, às vezes expressando emoções violentas. Os pesquisadores coletaram amostras de áudio do AphasiaBank do TalkBank e notaram que o silêncio é particularmente comum quando pessoas com distúrbios de fala falam.

A pesquisadora da Universidade Cornell, Allison Koenecke, compartilhou alguns exemplos nas redes sociais mostrando o conteúdo alucinatório gerado pelo Whisper. Os pesquisadores descobriram que o conteúdo gerado pela ferramenta também incluía termos médicos inventados e até frases como “Obrigado por assistir!”, que pareciam palavras de vídeos do YouTube.

A pesquisa foi apresentada na conferência FAccT da Association for Computing Machinery, no Brasil, em junho, mas não está claro se foi revisada por pares. Em relação a esta questão, a porta-voz da OpenAI, Taya Christianson, disse numa entrevista ao “The Verge” que eles levam esta questão muito a sério e continuarão a trabalhar arduamente para melhorá-la, especialmente na redução das alucinações. Ao mesmo tempo, ela mencionou que ao usar o Whisper em sua plataforma API, existem políticas de uso claras que proíbem o uso da ferramenta em determinados ambientes de tomada de decisão de alto risco.

Destaque:

A ferramenta de transcrição de sussurro é amplamente utilizada na indústria médica e gravou 7 milhões de conversas médicas.

⚠️ Pesquisas descobriram que o Whisper “alucina” em cerca de 1% das transcrições, às vezes gerando conteúdo sem sentido.

A OpenAI afirma que está trabalhando para melhorar o desempenho da ferramenta, principalmente na redução de alucinações.

Em suma, a tecnologia de IA tem amplas perspectivas de aplicação na área médica, mas também enfrenta muitos desafios. A emergência do fenómeno de “alucinação” do Whisper lembra-nos que precisamos de tratar a tecnologia de IA com cautela e reforçar a supervisão da sua segurança e fiabilidade para garantir a sua aplicação segura e eficaz no campo médico e proteger os direitos e a segurança dos pacientes. O editor do Downcodes continuará atento ao desenvolvimento subsequente deste incidente.