A natureza da “caixa preta” dos grandes modelos de linguagem (LLM) sempre foi uma questão importante que assola o campo da inteligência artificial. A ininterpretabilidade dos resultados do modelo torna difícil garantir a sua fiabilidade e credibilidade. Para resolver este problema, a OpenAI lançou uma nova tecnologia chamada Prover-Verifier Games (PVG), que visa melhorar a interpretabilidade e verificabilidade da saída do LLM. O editor de Downcodes explicará detalhadamente essa tecnologia para você.

A OpenAI lançou recentemente uma nova tecnologia chamada Prover-Verifier Games (PVG), que visa resolver o problema da "caixa preta" da saída do modelo de inteligência artificial.

Imagine que você tem um assistente superinteligente, mas seu processo de pensamento é como uma caixa preta e você não tem ideia de como ele chega a suas conclusões. Isso parece um pouco desconfortável? Sim, este é o problema enfrentado por muitos modelos de linguagem de grande porte (LLM) atualmente. Embora poderosos, a precisão do conteúdo gerado é difícil de verificar.

URL do artigo: https://cdn.openai.com/prover-verifier-games-improve-legibility-of-llm-outputs/legibility.pdf

Para resolver este problema, a OpenAI lançou a tecnologia PVG. Simplificando, permite que modelos pequenos (como GPT-3) supervisionem a saída de modelos grandes (como GPT-4). É como jogar um jogo. O Provador é responsável por gerar o conteúdo e o Verificador é responsável por determinar se o conteúdo está correto. Parece interessante?

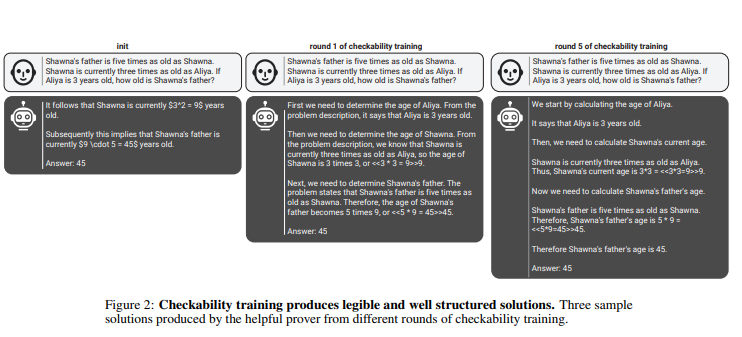

Nesta regra, os provadores e verificadores melhoram continuamente as suas capacidades através de múltiplas rondas de treino iterativo. Os verificadores usam aprendizagem supervisionada para prever a exatidão do conteúdo, enquanto os provadores usam aprendizagem por reforço para otimizar o conteúdo que geram. Ainda mais interessante é que existem dois tipos de provadores: provadores úteis e provadores astutos. Os provadores úteis esforçam-se por gerar conteúdo que seja correto e convincente, enquanto os provadores astutos tentam gerar conteúdo incorreto, mas igualmente convincente, desafiando assim o julgamento do verificador.

penAI enfatiza que, para treinar um modelo de verificador eficaz, é necessária uma grande quantidade de dados de rótulos reais e precisos para melhorar suas capacidades de reconhecimento. Caso contrário, mesmo que seja utilizada a tecnologia PVG, o conteúdo verificado ainda poderá correr o risco de ser produzido ilegalmente.

Destaque:

?A tecnologia PVG resolve o problema da “caixa preta” da IA, verificando a saída de modelos grandes com modelos pequenos.

? A estrutura de treinamento é baseada na teoria dos jogos e simula a interação entre o provador e o verificador, melhorando a precisão e a controlabilidade do resultado do modelo.

? É necessária uma grande quantidade de dados reais para treinar o modelo do verificador para garantir que ele tenha julgamento e robustez suficientes.

Em suma, a tecnologia PVG da OpenAI fornece uma nova ideia para resolver o problema da "caixa preta" dos modelos de inteligência artificial, mas a sua eficácia ainda depende de dados de formação de alta qualidade. Vale a pena aguardar o desenvolvimento futuro desta tecnologia, uma vez que promoverá o desenvolvimento de modelos de inteligência artificial numa direção mais fiável, explicável e fiável. O editor do Downcodes espera ver o surgimento de mais tecnologias inovadoras semelhantes.