O campo da inteligência artificial está mudando a cada dia que passa, e o raciocínio causal tornou-se um tema de pesquisa importante nos últimos anos. Os modelos tradicionais de aprendizado de máquina muitas vezes ficam aquém do raciocínio lógico e têm dificuldade em compreender a relação causal por trás dos eventos. Hoje, o editor do Downcodes apresentará um artigo de pesquisa de instituições como Microsoft e MIT, que propõe uma estratégia inovadora de treinamento de aprendizado de máquina que melhora significativamente as capacidades de raciocínio lógico de modelos grandes e até mesmo de modelos Transformer pequenos. 4 em capacidades de raciocínio. Vamos dar uma olhada mais de perto neste impressionante resultado de pesquisa.

Nesta era de explosão de informação, lidamos com dispositivos inteligentes todos os dias. Você já se perguntou como esses caras aparentemente inteligentes sabem que devem trazer um guarda-chuva porque está chovendo? Por trás disso está, na verdade, uma revolução profunda no raciocínio causal.

Um grupo de pesquisadores de instituições acadêmicas renomadas, incluindo a Microsoft e o MIT, desenvolveu uma estratégia inovadora de treinamento em aprendizado de máquina. Esta estratégia não apenas supera as deficiências dos grandes modelos de aprendizado de máquina no raciocínio lógico, mas também alcança melhorias significativas através das seguintes etapas:

Método de treinamento exclusivo: Os pesquisadores usaram um novo método de treinamento que pode diferir das técnicas convencionais de treinamento de aprendizado de máquina.

Melhorias no raciocínio lógico: A sua abordagem melhora significativamente as capacidades de raciocínio lógico de grandes modelos, resolvendo desafios anteriormente existentes.

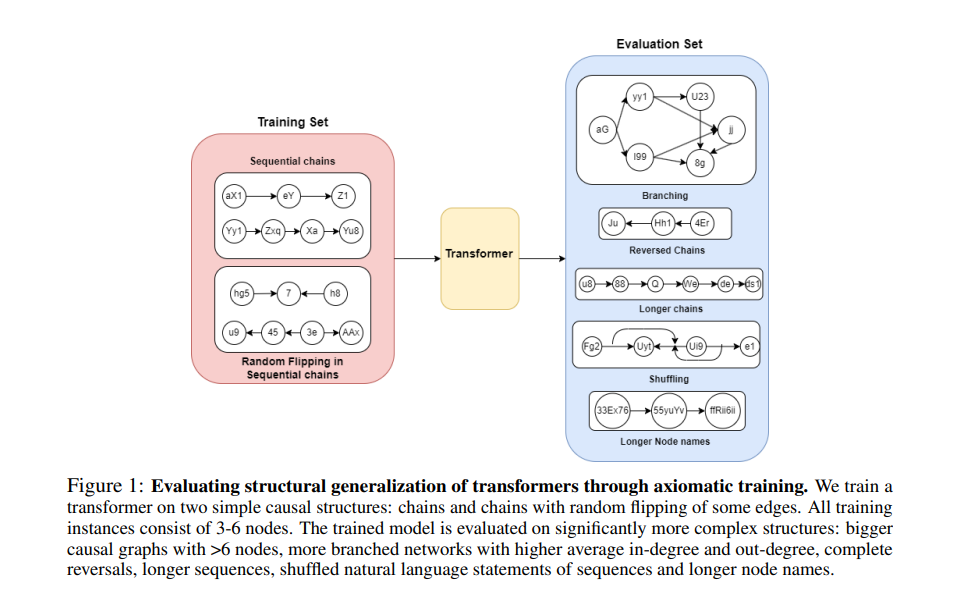

Use causalidade para construir um conjunto de treinamento: A equipe de pesquisa usa um modelo de causalidade para construir um conjunto de dados de treinamento. Este modelo pode revelar a conexão causal entre variáveis e ajudar a treinar um modelo que possa compreender a lógica causal por trás dos dados.

Ensine os axiomas básicos do modelo: Eles ensinam diretamente as premissas básicas da lógica e da matemática ao modelo para ajudá-lo a realizar um melhor raciocínio lógico.

O incrível desempenho do pequeno modelo Transformer: Embora os parâmetros do modelo sejam de apenas 67 milhões, o modelo Transformer treinado por meio deste método é comparável ao GPT-4 em termos de capacidade de raciocínio.

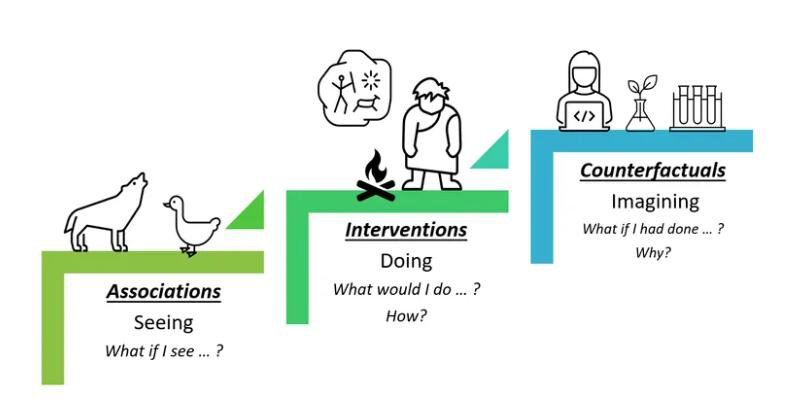

O raciocínio causal pode parecer exclusivo dos filósofos, mas na verdade já penetrou em todos os aspectos das nossas vidas. Para a inteligência artificial, dominar o raciocínio causal é como aprender a explicar o mundo usando "porque...então...". Mas a IA não nasce com isso, ela precisa aprender, e esse processo de aprendizagem é a história deste artigo.

Método de treinamento de axiomas:

Imagine que você tem um aluno que é muito inteligente, mas não tem ideia de causa e efeito no mundo. Como você ensina isso? Os pesquisadores encontraram uma solução - o treinamento de axiomas. Isto é como dar à IA um “manual de causalidade” e deixá-la aprender como identificar e aplicar regras causais através deste manual.

Os pesquisadores realizaram experimentos com o modelo do transformador e descobriram que esse método de treinamento realmente funciona. A IA não apenas aprendeu a identificar relações causais em gráficos de pequena escala, mas também foi capaz de aplicar esse conhecimento a gráficos maiores, mesmo que! Nunca se viu um quadro tão grande antes.

A contribuição desta pesquisa é fornecer um novo método para a IA aprender inferência causal a partir de dados passivos. Isto é como dar à IA uma nova forma de “pensar” para que possa compreender e explicar melhor o mundo.

Esta pesquisa não apenas nos permite ver a possibilidade de a IA aprender o raciocínio causal, mas também abre a porta para vermos possíveis cenários de aplicação da IA no futuro. Talvez num futuro próximo, nossos assistentes inteligentes sejam capazes não apenas de responder perguntas, mas também de nos dizer por que algo está acontecendo.

Endereço do artigo: https://arxiv.org/pdf/2407.07612v1

Em suma, esta investigação trouxe melhorias significativas às capacidades de raciocínio causal da inteligência artificial e forneceu novas direções e possibilidades para o desenvolvimento futuro da IA. O editor do Downcodes espera a aplicação desta tecnologia em mais campos, permitindo que a IA compreenda e sirva melhor os humanos.