Recentemente, o modelo de IA de código aberto Reflection70B atraiu ampla atenção na indústria devido à sua controvérsia de desempenho. O modelo foi lançado pela HyperWrite, que originalmente afirmava ser o modelo de código aberto mais poderoso do mundo e atraiu muita atenção devido ao seu excelente desempenho em testes de terceiros. No entanto, algumas instituições e utilizadores independentes questionaram posteriormente o seu desempenho e os resultados dos testes diferiram significativamente das afirmações iniciais da HyperWrite.

O modelo de IA de código aberto Reflection70B, que acaba de ser lançado, foi recentemente amplamente questionado pela indústria.

Este modelo lançado pela startup nova-iorquina HyperWrite, que afirma ser a variante Llama3.1 do Meta, chamou a atenção devido ao seu excelente desempenho em testes de terceiros. No entanto, à medida que alguns resultados de testes foram divulgados, a reputação do Reflection70B começou a ser desafiada.

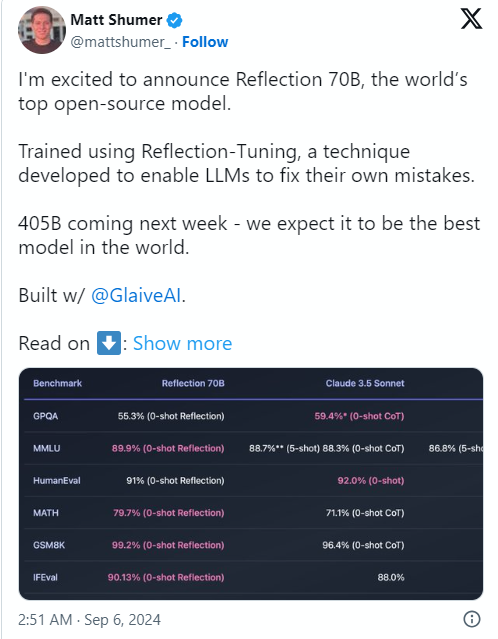

A causa do problema foi que o cofundador e CEO da HyperWrite, Matt Shumer, anunciou o Reflection70B na mídia social X em 6 de setembro e o chamou com segurança de "o modelo de código aberto mais forte do mundo".

Shumer também compartilhou sobre a tecnologia de “ajuste reflexivo” do modelo, alegando que este método permite que o modelo se revise antes de gerar conteúdo, melhorando assim a precisão.

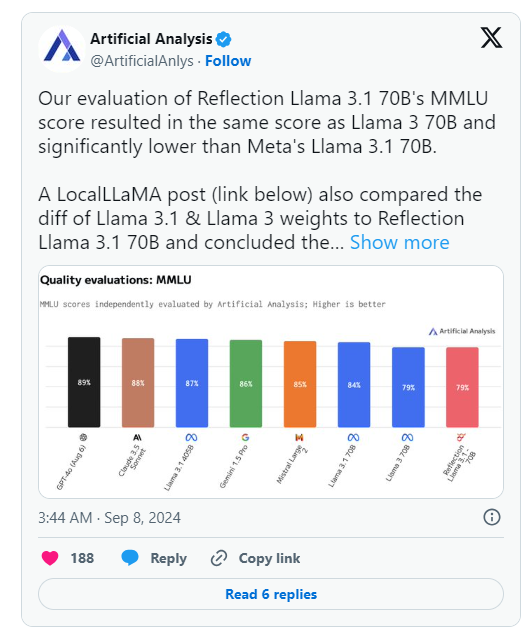

No entanto, um dia após o anúncio do HyperWrite, Artificial Analysis, um grupo especializado em “análise independente de modelos de IA e provedores de hospedagem”, publicou sua própria análise no X, observando que avaliou a pontuação MMLU (Massive Multitask Language Understanding) do Reflection Llama3.170B. é igual ao Llama370B, mas significativamente menor que o Llama3.170B da Meta, o que é uma diferença significativa dos resultados originalmente publicados pela HyperWrite/Shumer.

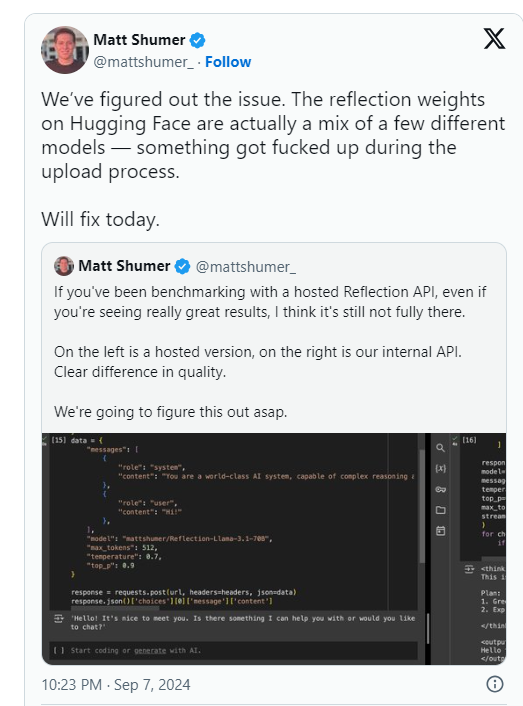

Shumer afirmou mais tarde que houve um problema com os pesos do Reflection70B (ou configurações para o modelo de código aberto) durante o upload para o Hugging Face (um repositório e empresa de hospedagem de código de IA de terceiros), o que pode ter resultado em pior desempenho do que a "API interna" do HyperWrite. "versão. .

A Artificial Analysis disse em uma declaração subsequente que obteve acesso à API privada e obteve um desempenho impressionante, mas não ao nível declarado originalmente. Como esse teste foi realizado em uma API privada, eles não conseguiram verificar de forma independente o que estavam testando.

O grupo levantou duas questões principais que questionam seriamente as reivindicações originais de desempenho do HyperWrite e Shumer:

Enquanto isso, usuários em várias comunidades de aprendizado de máquina e IA no Reddit também questionaram o desempenho e as origens alegadas do Reflection70B. Alguns apontaram que o Reflection70B parece ser uma variante do Llama3 em vez do Llama-3.1 , com base em uma comparação de modelos postada por terceiros no Github, lançando mais dúvidas sobre as afirmações originais de Shumer e HyperWrite.

Isso resultou em pelo menos um usuário X, Shin Megami Boson, postando em 8 de setembro ET

Às 20h07 EDT, Shumer acusou publicamente Shumer de “conduta fraudulenta” na comunidade de pesquisa de IA e divulgou uma longa lista de capturas de tela e outras evidências.

Outros alegaram que o modelo é na verdade um "invólucro" ou aplicativo construído sobre o Claude3, concorrente proprietário/de código fechado, da Anthropic.

No entanto, outros usuários do X vieram em defesa do Shumer e do Reflection70B, com alguns também apresentando desempenho impressionante em sua extremidade do modelo.

Atualmente, a comunidade de pesquisa de IA está aguardando a resposta de Shumer a essas acusações de fraude e pesos de modelo atualizados no Hugging Face.

Após o lançamento do modelo Reflection70B, o desempenho foi questionado, e os resultados dos testes não conseguiram replicar as afirmações iniciais.

⚙️ O fundador do HyperWrite explicou que problemas de upload de modelos causaram degradação de desempenho e pediu atenção para a versão atualizada.

O modelo tem sido muito debatido nas redes sociais, com acusações e defesas misturadas.

Atualmente, o incidente Reflection70B ainda continua a fermentar e o resultado final ainda precisa aguardar mais investigações e respostas. Este incidente também nos lembra que devemos ser cautelosos na promoção do desempenho de qualquer modelo de IA e confiar em resultados de verificação independente para fazer julgamentos.