Recentemente, a experiência do usuário do chatbot de IA da Anthropic, Claude, gerou discussões acaloradas. Um grande número de comentários de usuários apareceram no Reddit, dizendo que o desempenho de Claude diminuiu, manifestando-se especificamente como perda de memória e diminuição da capacidade de codificação. Este incidente desencadeou discussões generalizadas sobre avaliação de desempenho e experiência do utilizador de grandes modelos de linguagem, e mais uma vez destacou os desafios enfrentados pelas empresas de IA na manutenção da estabilidade do modelo.

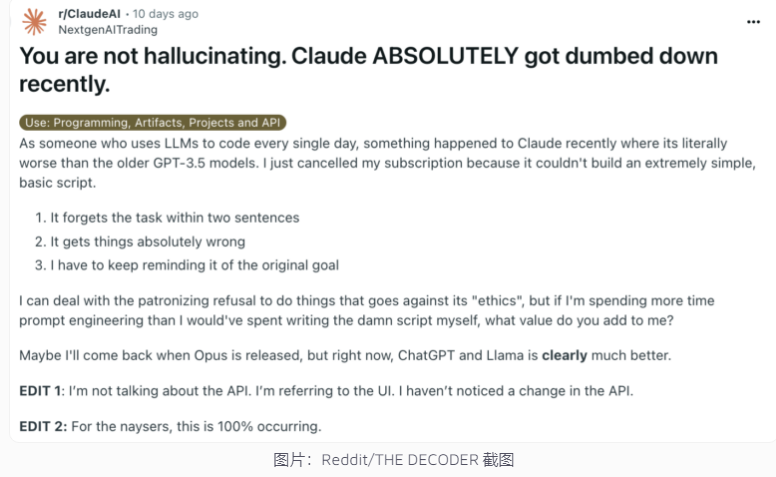

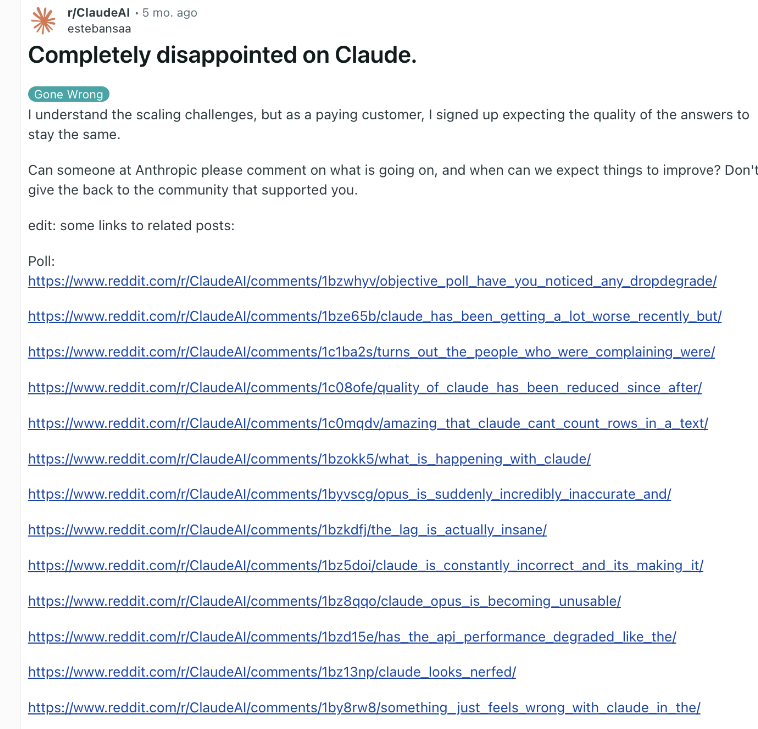

Recentemente, o chatbot de IA da Anthropic, Claude, mais uma vez se envolveu em uma controvérsia de desempenho. Uma postagem no Reddit alegando que Claude havia se tornado muito mais estúpido atraiu recentemente a atenção generalizada, com muitos usuários relatando que haviam experimentado um declínio nas habilidades de Claude, incluindo perda de memória e um declínio na capacidade de codificação.

Em resposta, o executivo da Anthropic, Alex Albert, respondeu que a investigação da empresa não encontrou nenhum problema comum e confirmou que nenhuma alteração foi feita no modelo Claude3.5Sonnet ou no pipeline de inferência. Para melhorar a transparência, a Anthropic publicou os prompts do sistema do modelo Claude em seu site oficial.

Esta não é a primeira vez que usuários relatam degradação da IA e a empresa nega. No final de 2023, o ChatGPT da OpenAI também enfrentou dúvidas semelhantes. De acordo com especialistas da indústria, as razões para este fenómeno podem incluir: aumento das expectativas dos utilizadores ao longo do tempo, mudanças naturais na produção de IA, limitações temporárias de recursos computacionais, etc.

No entanto, estes factores ainda podem levar à degradação do desempenho percebida pelo utilizador, mesmo que o modelo subjacente não sofra alterações significativas. A OpenAI certa vez apontou que o comportamento da IA em si é imprevisível e que manter e avaliar o desempenho da IA generativa em larga escala é um enorme desafio.

A Anthropic disse que continuará prestando atenção ao feedback dos usuários e trabalhando duro para melhorar a estabilidade do desempenho de Claude. O incidente destaca os desafios que as empresas de IA enfrentam para manter a consistência do modelo, bem como a importância de aumentar a transparência na avaliação e comunicação do desempenho da IA.

A controvérsia do desempenho de Claude reflete a complexidade do desenvolvimento e implantação de grandes modelos de linguagem, bem como a lacuna entre as expectativas do usuário e as aplicações reais. No futuro, as empresas de IA terão de melhorar ainda mais a estabilidade do modelo e manter uma comunicação mais eficaz com os utilizadores para garantir que a tecnologia de IA possa continuar a fornecer serviços aos utilizadores de forma fiável.