A API Anthropic introduz um novo recurso há muito aguardado - cache de dicas, que melhorará significativamente a eficiência e a economia dos modelos Claude. Esse recurso permite que os desenvolvedores armazenem em cache informações contextuais usadas com frequência entre chamadas de API, reduzindo assim cálculos redundantes e reduzindo custos e latência. Para cenários de aplicativos que precisam processar grandes quantidades de informações contextuais, como agentes de conversação, assistentes de codificação e processamento de grandes documentos, o cache de dicas trará enormes melhorias de desempenho. Esta atualização está atualmente em versão beta pública para Claude3.5 Sonnet e Claude3 Haiku, com planos de expansão para Claude3 Opus.

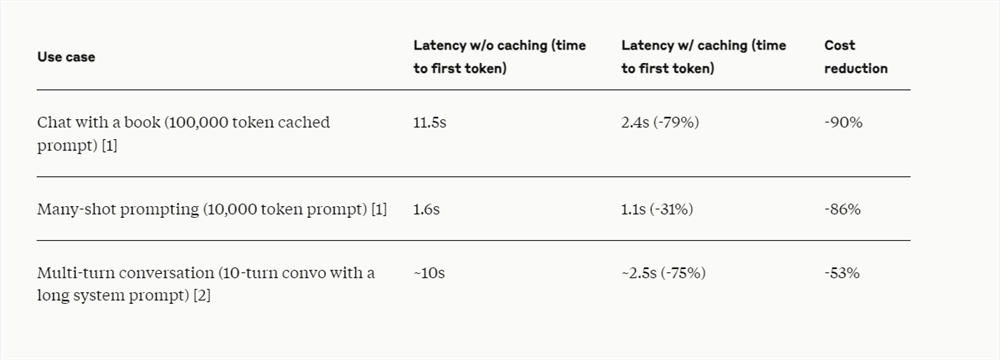

A API Anthropic lançou recentemente o cache de prompt, para que os desenvolvedores agora possam armazenar em cache informações contextuais comumente usadas entre chamadas de API. Com o cache de dicas, os clientes podem fornecer aos modelos Claude mais conhecimento prévio e resultados de exemplos, ao mesmo tempo que reduzem significativamente o custo de dicas longas, reduzindo taxas em até 90% e reduzindo a latência em até 85%.

Este recurso está atualmente disponível em versões beta públicas do Claude3.5Sonnet e Claude3Haiku e também oferecerá suporte ao Claude3Opus no futuro.

O recurso de cache de prompt é particularmente útil em cenários onde um grande número de contextos de prompt precisam ser referenciados repetidamente em diversas solicitações, como em proxies de conversação para reduzir o custo e a latência de conversas longas, especialmente quando contêm instruções complexas ou uploads de documentos; O preenchimento automático do assistente e as perguntas e respostas da base de código podem ser melhorados mantendo uma versão resumida da base de código no prompt ao trabalhar com documentos grandes. O cache de prompt permite incorporar material completo de formato longo sem aumentar adicionalmente os tempos de resposta; chamadas e iterações de ferramentas Cenários alterados de pesquisa de proxy e uso de ferramentas, o cache de prompt também pode melhorar significativamente o desempenho.

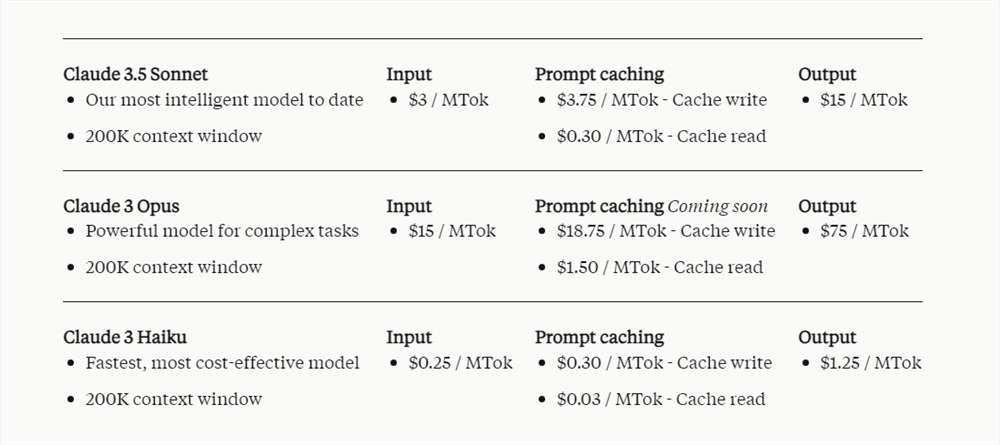

O preço do cache de dicas depende do número de tokens de entrada armazenados em cache e da frequência de uso. Escrever no cache custa 25% mais do que o preço base do token de entrada, enquanto usar conteúdo em cache custa significativamente menos, apenas 10% do preço base do token de entrada.

É relatado que a Notion, como cliente da Anthropic API, integrou a função de cache imediato em seu assistente de inteligência artificial Notion AI. Ao reduzir custos e aumentar a velocidade, o Notion otimiza as operações internas e traz uma experiência mais avançada e rápida aos usuários.

O lançamento da função de cache imediato reflete os esforços da Anthropic para otimizar o desempenho do modelo Claude e reduzir os custos do usuário, fornecendo aos desenvolvedores soluções de IA mais econômicas e melhorando ainda mais a praticidade do modelo Claude em vários cenários de aplicação. As histórias de sucesso do Notion também comprovam o valor prático desse recurso.