No campo do desenvolvimento de software, a aplicação de ferramentas de codificação de IA está a desencadear uma revolução silenciosa. As equipes de desenvolvimento utilizam amplamente a codificação assistida por IA. No entanto, a gestão da empresa carece de supervisão e controle eficazes sobre o uso de ferramentas de IA. Isto desencadeou um “jogo de gato e rato” entre os desenvolvedores e a administração em relação à aplicação de ferramentas de IA e aos riscos de segurança resultantes.

No mundo da tecnologia, existe um jogo de gato e rato entre desenvolvedores e gerenciamento. Os protagonistas deste jogo são aquelas ferramentas de codificação de IA que foram explicitamente proibidas pela empresa, mas ainda são usadas silenciosamente pelos desenvolvedores.

Embora 15% das empresas proíbam explicitamente o uso de ferramentas de codificação de IA, quase todas as equipes de desenvolvimento (99%) as utilizam, de acordo com uma nova pesquisa global da empresa de segurança em nuvem Checkmarx. Este fenómeno revela os desafios no controlo da utilização de IA generativa.

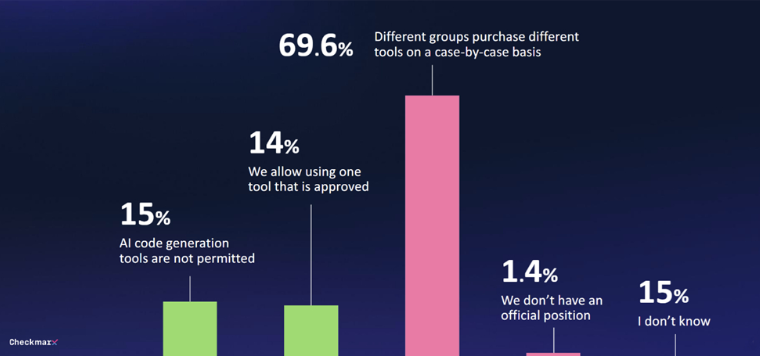

Apenas 29% das empresas possuem alguma forma de governança para ferramentas generativas de IA. Em 70% dos casos, não existe uma estratégia unificada e as decisões de compra são tomadas ad hoc por vários departamentos. Esta situação torna difícil para a gestão controlar o uso de ferramentas de codificação de IA.

Com a popularidade das ferramentas de codificação de IA, as questões de segurança tornaram-se cada vez mais proeminentes. 80% dos entrevistados estão preocupados com as ameaças potenciais que os desenvolvedores podem trazer ao usar a IA, especialmente 60% que expressam preocupação com as “alucinações” causadas pela IA.

Apesar das preocupações, o interesse no potencial da IA continua forte. 47% dos entrevistados estão abertos a permitir que a IA faça alterações de código não supervisionadas. Apenas 6% disseram que não confiariam nas medidas de segurança de IA em ambientes de software.

“As respostas desses CISOs globais revelam a realidade de que os desenvolvedores estão usando IA no desenvolvimento de aplicativos, mesmo que não consigam criar códigos seguros usando IA, o que significa que as equipes de segurança precisam enfrentar uma enxurrada de novos ataques vulneráveis”, disse Tzruya. ."

Um relatório recente do Índice de Tendências de Trabalho da Microsoft mostrou descobertas semelhantes, com muitos funcionários usando suas próprias ferramentas de IA quando nenhuma delas é fornecida. Muitas vezes, não discutem esta utilização, o que dificulta a integração sistemática da IA generativa nos processos de negócio.

Apesar das proibições explícitas, 99% das equipes de desenvolvimento ainda usam ferramentas de IA para gerar código. Apenas 29% das empresas estabeleceram mecanismos de governação para a utilização de IA generativa. Em 70% dos casos, as decisões sobre a utilização de ferramentas de IA por vários departamentos são tomadas numa base ad hoc. Ao mesmo tempo, as preocupações com a segurança estão a aumentar. 47% dos entrevistados estão abertos a permitir que a IA faça alterações de código não supervisionadas. As equipes de segurança enfrentam o desafio de lidar com grandes quantidades de códigos gerados por IA potencialmente vulneráveis.

Este “jogo de gato e rato” entre desenvolvedores e gerenciamento continua, e teremos que esperar para ver para onde vai o futuro das ferramentas de codificação de IA.

A aplicação de ferramentas de codificação de IA tornou-se uma tendência, mas os riscos de segurança que traz não podem ser ignorados. As empresas precisam de estabelecer um mecanismo de governação sólido para equilibrar as melhorias de eficiência trazidas pela IA com potenciais riscos de segurança, a fim de se adaptarem melhor a esta onda tecnológica.