O mais recente modelo RWKV-CLIP de código aberto de Green Deep Learning demonstrou forte desempenho no campo de aprendizagem de representação de linguagem visual com seu design inovador integrando a arquitetura Transformer e RNN. Este modelo resolve efetivamente o problema de dados ruidosos e melhora significativamente a robustez do modelo e o desempenho das tarefas downstream, combinando inteligentemente uma arquitetura de torre dupla, módulos de mistura espacial e de mistura de canais e uma estrutura diversificada de geração de descrição. Fez progressos revolucionários na correspondência e compreensão de imagem-texto, proporcionando uma nova direção para a pesquisa e aplicação de modelos de linguagem visual.

Gelingshentong abriu o código-fonte do modelo RWKV-CLIP, que é um aluno de representação de linguagem visual que combina as vantagens do Transformer e do RNN. O modelo melhora significativamente o desempenho em tarefas visuais e de linguagem, ampliando o conjunto de dados usando pares imagem-texto obtidos de sites por meio de tarefas de pré-treinamento de imagem e texto.

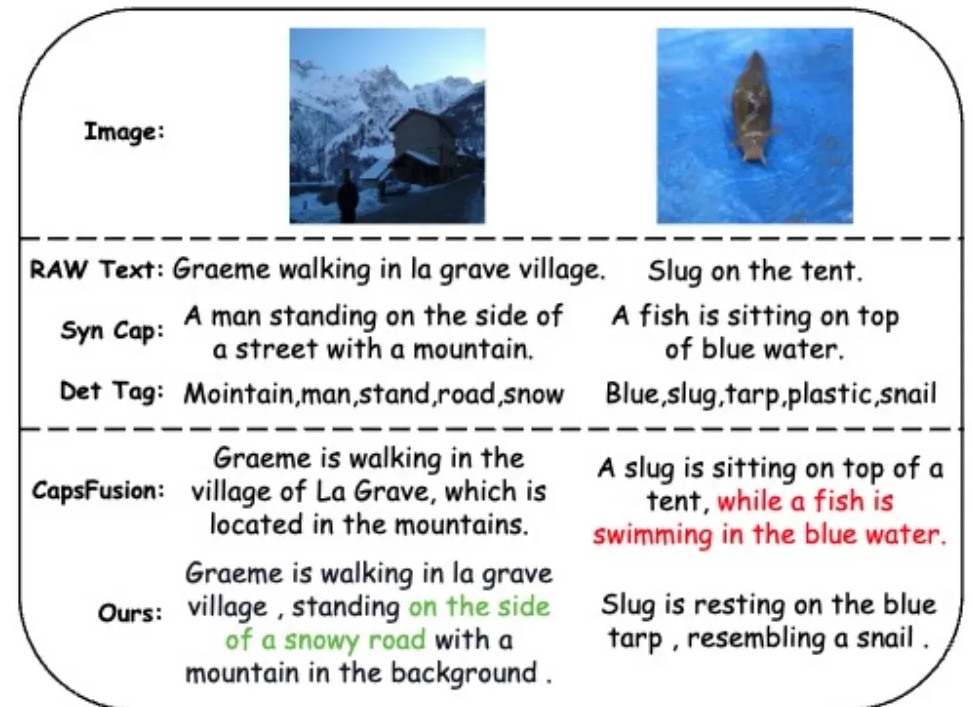

Para resolver o problema de dados ruidosos e melhorar a qualidade dos dados, a equipe de pesquisa introduziu uma estrutura diversificada de geração de descrição que aproveita grandes modelos de linguagem (LLMs) para sintetizar e refinar o conteúdo de texto baseado na web, legendas sintetizadas e tags detectadas.

O modelo RWKV-CLIP adota uma arquitetura de torre dupla, integrando o treinamento paralelo efetivo do Transformer e a inferência eficiente do RNN. O modelo é empilhado por vários módulos de combinação espacial e combinação de canais, que permitem o processamento aprofundado de imagens e texto de entrada. Na fase de mistura espacial, o modelo utiliza o mecanismo de atenção para realizar cálculos de complexidade linear global e fortalecer a interação de recursos no nível do canal. O estágio de combinação de canais refina ainda mais a representação do recurso. Em termos de aprimoramento de entrada, o modelo RWKV-CLIP aumenta a robustez do modelo selecionando aleatoriamente texto original, legendas sintéticas ou descrições geradas como entrada de texto.

Os resultados experimentais mostram que o RWKV-CLIP atinge desempenho de última geração em múltiplas tarefas downstream, incluindo detecção linear, classificação de disparo zero e recuperação de texto de imagem de disparo zero. Comparado com o modelo básico, o RWKV-CLIP alcança melhorias significativas de desempenho.

A análise intermodal do modelo RWKV-CLIP mostra que suas representações aprendidas exibem discriminabilidade mais clara dentro da mesma modalidade e exibem distâncias mais próximas no espaço da modalidade imagem-texto, indicando melhor desempenho de alinhamento entre modalidades.

Endereço do modelo: https://wisemodel.cn/models/deepglint/RWKV-CLIP

Em suma, o modelo RWKV-CLIP apresenta um grande potencial no campo da linguagem visual e o seu código aberto também fornece recursos valiosos para pesquisas relacionadas. Os desenvolvedores interessados podem visitar o link fornecido para baixar o modelo e realizar pesquisas e aplicações adicionais.