O ARC-AGI, um benchmark concebido para avaliar as capacidades de abstração e raciocínio da inteligência artificial geral (AGI), fez progressos recentemente, mas o seu criador, François Cholet, lembra-nos que isso não significa que a AGI esteja a aproximar-se. Ele destacou que o desempenho dos atuais sistemas de IA no teste ARC-AGI ainda está muito abaixo das expectativas, e o principal motivo são as limitações dos grandes modelos de linguagem (LLM), que são melhores no reconhecimento de padrões do que no raciocínio verdadeiro. Sholay e seus colaboradores lançaram uma competição de US$ 1 milhão para promover avanços de IA de código aberto no ARC-AGI, mas os resultados também confirmaram que o teste em si pode ter deficiências e precisar de melhorias adicionais.

Desde o seu lançamento em 2019, o ARC-AGI tem sido foco de atenção no campo da inteligência artificial. Embora o sistema de IA tenha feito algum progresso nos testes, suas pontuações ainda estavam bem abaixo dos níveis humanos. Isto desencadeou uma reflexão sobre a direção atual do desenvolvimento da IA e levou os investigadores a reexaminar a definição e os métodos de avaliação da AGI. O artigo analisa detalhadamente as limitações do teste ARC-AGI, bem como as perspectivas para futuras direções de pesquisa em AGI, e exibe resultados relevantes da competição e estratégias de enfrentamento dos pesquisadores.

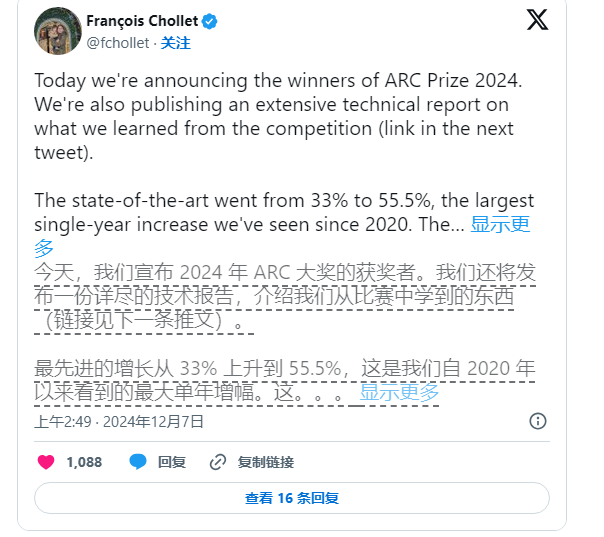

Ainda assim, Sholay não parou de pressionar pela pesquisa em IA. Ele e o fundador da Zapier, Mike Knoop, lançaram conjuntamente uma competição de US$ 1 milhão em junho deste ano para incentivar a IA de código aberto a desafiar o benchmark ARC-AGI. Embora o sistema de IA com melhor desempenho tenha obtido apenas 55,5% de 17.789 entradas, abaixo da marca de 85% necessária para alcançar o “desempenho humano”, Sholay e Knoop ainda o veem como um passo importante.

Knoop apontou em uma postagem no blog que essa conquista não significa que estamos mais perto de realizar a AGI. Em vez disso, destaca que algumas tarefas na ARC-AGI dependem demais de soluções de “força bruta” e podem não fornecer sinais eficazes para uma verdadeira generalização. inteligência. O ARC-AGI foi originalmente projetado para testar a capacidade de generalização da IA, fornecendo tarefas complexas e nunca antes vistas. No entanto, ainda há dúvidas se essas tarefas podem avaliar efetivamente a AGI.

Nota sobre a fonte da imagem: a imagem é gerada pela IA e pelo provedor de serviços de autorização de imagem Midjourney

As tarefas no benchmark ARC-AGI envolvem problemas de quebra-cabeças, etc., que exigem que a IA infira respostas desconhecidas com base em informações conhecidas. Embora estas tarefas pareçam promover a adaptação da IA a novas situações, os resultados mostram que os modelos existentes parecem encontrar soluções através de uma grande quantidade de cálculos, e não demonstram necessariamente uma verdadeira adaptabilidade inteligente.

Além disso, os criadores do ARC-AGI enfrentaram críticas dos seus pares, particularmente no que diz respeito à ambiguidade em torno da definição de AGI. Um funcionário da OpenAI declarou recentemente que se a AGI for definida como inteligência artificial que “desempenha melhor do que a maioria dos humanos na maioria das tarefas”, então a AGI foi realmente alcançada. No entanto, Cholet e Knoop argumentam que os projetos existentes para o benchmark ARC-AGI ainda não atingiram totalmente este objetivo.

No futuro, Sholay e Knoop planejam lançar uma segunda geração do benchmark ARC-AGI e realizarão uma nova competição em 2025 para solucionar deficiências nos testes atuais. Eles disseram que o novo referencial se concentrará mais na promoção do desenvolvimento da pesquisa em IA em uma direção mais importante e na aceleração da implementação da AGI.

Contudo, fixar os parâmetros de referência existentes não é uma tarefa fácil. Os esforços de Sholay e Knoop demonstram que definir inteligência em inteligência artificial, especialmente no campo da inteligência geral, continua a ser uma tarefa difícil e complexa.

Em suma, o progresso do benchmark ARC-AGI e as discussões relacionadas reflectem que a exploração da inteligência artificial geral no domínio da inteligência artificial ainda está em curso, sendo necessárias definições mais rigorosas e métodos de avaliação mais eficazes. o futuro. Promover o desenvolvimento real da AGI.