Os modelos de linguagem visual (VLMs) fizeram progressos significativos no campo da inteligência artificial, mas ainda enfrentam desafios no processamento de imagens de alta resolução e textos diversos. Os modelos existentes geralmente usam codificadores visuais estáticos, que são ineficientes e carecem de precisão em diferentes conjuntos de dados. A falta de diversidade e especificidade de tarefa no conjunto de dados de treinamento também limita seu desempenho, especialmente em tarefas de domínio especializado, como interpretação de gráficos.

Com o rápido desenvolvimento da inteligência artificial, a integração das capacidades visuais e de linguagem levou a um progresso revolucionário nos modelos de linguagem visual (VLMs). Esses modelos são projetados para processar e compreender dados visuais e textuais simultaneamente e são amplamente utilizados em cenários como descrição de imagens, resposta visual a perguntas, reconhecimento óptico de caracteres e análise de conteúdo multimodal.

Os VLMs têm desempenhado um papel importante no desenvolvimento de sistemas autónomos, na melhoria da interação humano-computador e em ferramentas eficientes de processamento de documentos, colmatando com sucesso a lacuna entre estas duas modalidades de dados. No entanto, ainda existem muitos desafios no processamento de dados visuais de alta resolução e diversas entradas de texto.

A pesquisa atual abordou parcialmente essas limitações, mas os codificadores visuais estáticos adotados pela maioria dos modelos carecem de adaptabilidade em altas resoluções e tamanhos de entrada variáveis. Ao mesmo tempo, a combinação de modelos de linguagem pré-treinados com codificadores visuais muitas vezes resulta em ineficiências porque não são otimizados para tarefas multimodais. Embora alguns modelos introduzam técnicas de computação esparsas para gerenciar a complexidade, a precisão em diferentes conjuntos de dados ainda é insuficiente. Além disso, os conjuntos de dados de formação dos modelos existentes muitas vezes carecem de diversidade e especificidade de tarefas, o que limita ainda mais o seu desempenho. Por exemplo, muitos modelos apresentam desempenho insatisfatório em tarefas especializadas, como interpretação de gráficos ou análise densa de documentos.

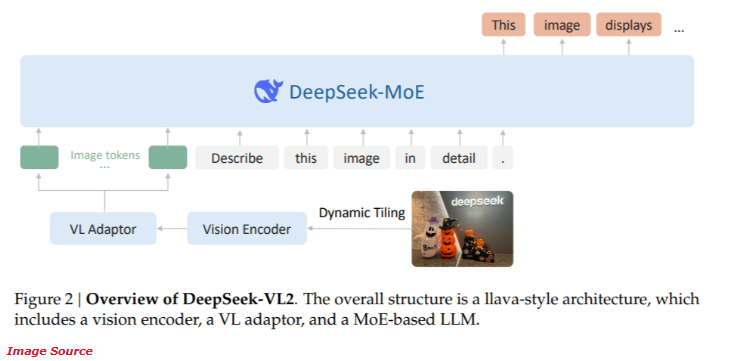

Recentemente, DeepSeek-AI lançou a nova série DeepSeek-VL2 de modelos de linguagem visual de especialistas híbridos (MoE) de código aberto. Esta série de modelos combina tecnologias inovadoras de ponta, incluindo fatiamento dinâmico de codificação visual, mecanismo de atenção latente de múltiplas cabeças e estrutura DeepSeek-MoE.

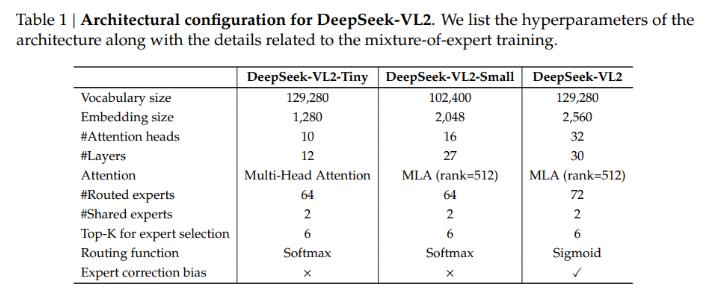

A série DeepSeek-VL2 oferece três configurações de parâmetros diferentes:

- DeepSeek-VL2-Tiny: 3,37 bilhões de parâmetros (1 bilhão de parâmetros de ativação)

- DeepSeek-VL2-Small: 16,1 bilhões de parâmetros (2,8 bilhões de parâmetros de ativação)

- DeepSeek-VL2: 27,5 bilhões de parâmetros (4,5 bilhões de parâmetros de ativação)

Essa escalabilidade garante sua capacidade de adaptação a diferentes necessidades de aplicativos e orçamentos de computação.

A arquitetura do DeepSeek-VL2 foi projetada para otimizar o desempenho e, ao mesmo tempo, reduzir os requisitos computacionais. O método de fatiamento dinâmico garante que imagens de alta resolução sejam processadas sem perder detalhes críticos, tornando-o ideal para análise de documentos e tarefas de localização visual. Além disso, o mecanismo de atenção latente de múltiplas cabeças permite que o modelo processe eficientemente grandes quantidades de dados de texto, reduzindo a sobrecarga computacional normalmente associada ao processamento de entrada de linguagem densa. O treinamento do DeepSeek-VL2 cobre diversos conjuntos de dados multimodais, permitindo que ele tenha um bom desempenho em uma variedade de tarefas, como reconhecimento óptico de caracteres, resposta visual a perguntas e interpretação de gráficos.

De acordo com os testes de desempenho, a configuração Small alcançou uma precisão de 92,3% na tarefa de reconhecimento óptico de caracteres, superando significativamente os modelos existentes. No teste de benchmark de posicionamento visual, o modelo melhorou a precisão em 15% em comparação com o produto da geração anterior.

Ao mesmo tempo, o DeepSeek-VL2 reduz os requisitos de recursos computacionais em 30%, mantendo a precisão de última geração. Esses resultados demonstram a superioridade deste modelo no processamento de imagens e textos de alta resolução.

Entrada do projeto: https://huggingface.co/collections/deepseek-ai/deepseek-vl2-675c22accc456d3beb4613ab

Destaque:

A série DeepSeek-VL2 oferece uma variedade de configurações de parâmetros para se adaptar às diferentes necessidades de aplicação.

A tecnologia de fatiamento dinâmico melhora a eficiência do processamento de imagens de alta resolução e é adequada para análises complexas de documentos.

O modelo tem um bom desempenho em tarefas de reconhecimento óptico de caracteres e localização visual, com precisão significativamente melhorada.

Os modelos da série DeepSeek-VL2 trouxeram novos avanços no campo dos modelos de linguagem visual com sua arquitetura inovadora e excelente desempenho. Suas vantagens em imagens de alta resolução e processamento de texto complexo fazem com que ele apresente grande potencial em muitos cenários de aplicação e mereça mais atenção e pesquisas.