Nos últimos anos, a tecnologia de avatar virtual de IA desenvolveu-se rapidamente, mas a sua interatividade ainda é um gargalo importante que restringe a sua aplicação. Muitos avatares virtuais de IA se comportam de maneira rígida nas conversas, carecem de realismo e não conseguem interagir naturalmente com os usuários. Para tanto, surgiu uma nova tecnologia chamada INFP. Ela visa resolver o problema atual de interação insuficiente entre avatares virtuais de IA em conversas entre duas pessoas, permitindo que personagens virtuais expressem emoções e ações de forma tão natural e suave quanto pessoas reais durante a conversa. conversa mude completamente a experiência de interação humano-computador.

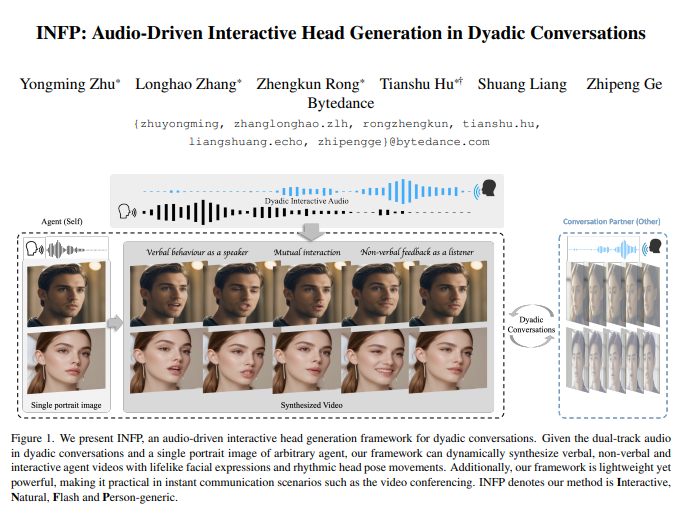

Recentemente, uma nova tecnologia chamada INFP (Interactive, Natural, Flash and Person-genérico) atraiu ampla atenção. Esta tecnologia visa resolver o problema da interação insuficiente entre os atuais avatares virtuais de IA em conversas entre duas pessoas, permitindo que personagens virtuais interajam como pessoas reais durante as conversas, ajustando dinamicamente as suas expressões e movimentos com base no conteúdo da conversa.

Diga adeus à “comédia stand-up” e dê as boas-vindas ao “refrão duplo”

No passado, os avatares de IA só podiam falar sozinhos, como um ator de “comediante stand-up”, ou só podiam ouvir estupidamente, sem qualquer feedback, como uma “pessoa de madeira”. Porém, nossas conversas humanas não são assim. Quando conversamos, olhamos um para o outro, acenamos com a cabeça, franzimos a testa e até fazemos piadas de vez em quando. Isso é interação real!

O surgimento do INFP é para mudar completamente essa situação embaraçosa! É como um maestro de “coro duplo”, que pode ajustar dinamicamente as expressões e movimentos do avatar da IA com base no áudio da conversa entre você e a IA, fazendo você se sentir bem! como É como conversar com uma pessoa real!

Os “segredos únicos” do INFP: dois truques, um é indispensável!

A razão pela qual o INFP é tão poderoso é principalmente devido aos seus dois “segredos únicos”:

Imitação de cabeça baseada em movimento:

Ele aprenderá primeiro expressões e movimentos humanos a partir de um grande número de vídeos de conversas reais, como um “mestre da imitação de ação”, comprimindo esses comportamentos complexos em “códigos de ação”.

Para tornar os movimentos mais realistas, prestará também especial atenção às duas “expressões” dos olhos e da boca, tal como lhes dará um “close-up”.

Também utilizará pontos-chave faciais para auxiliar na geração de expressões para garantir a precisão e naturalidade dos movimentos.

Em seguida, ele aplica esses “códigos de ação” a um avatar estático, tornando o avatar “vivo” instantaneamente, como mágica!

Geração de movimento guiado por áudio:

Este “gerador” é ainda mais poderoso. Ele pode entender o áudio da conversa entre você e a IA, assim como um mestre que consegue “identificar a localização ouvindo o som”.

Ele analisará quem está falando e quem está ouvindo no áudio e, em seguida, ajustará dinamicamente o status do avatar de IA para que ele possa alternar livremente entre “falar” e “ouvir” sem precisar alternar manualmente os papéis.

Está também equipado com dois “bancos de memória” que armazenam diversas ações ao “falar” e “ouvir” respetivamente, tal como duas “caixas de tesouro” para extrair as ações mais adequadas a qualquer momento.

Também pode ajustar o humor e a atitude do avatar de IA de acordo com seu estilo de voz, tornando a conversa mais animada e interessante.

Por fim, também utiliza uma tecnologia chamada “modelo de difusão” para transformar esses movimentos em animações suaves e naturais para que você não sinta nenhum atraso.

DyConv: Um enorme conjunto de dados de conversas cheio de "fofocas"!

Para treinar o INFP, a “super IA”, os pesquisadores também coletaram especialmente um grande conjunto de dados de conversas chamado DyConv!

Existem mais de 200 horas de vídeos de conversas neste conjunto de dados. As pessoas vêm de todo o mundo e o conteúdo das conversas também é diversificado.

A qualidade de vídeo do conjunto de dados DyConv é muito alta, garantindo que o rosto de todos esteja claramente visível.

Os pesquisadores também usaram o modelo de separação de fala mais avançado para extrair a voz de cada pessoa separadamente para facilitar o aprendizado da IA.

"Dezoito Artes Marciais" do INFP: Você não só pode falar, mas também pode...

O INFP pode não apenas mostrar seus talentos em conversas entre duas pessoas, mas também brilhar em outros cenários:

Modo "Geração de Cabeça Ouvinte": Pode fazer expressões e ações correspondentes com base no que a outra parte está dizendo, assim como um bom aluno que "ouve com atenção".

Modo "Talking Head Generation": pode fazer com que o avatar crie formatos de boca realistas com base no áudio, como um mestre "ventríloquo".

Para provar o poder do INFP, os pesquisadores realizaram um grande número de experimentos e os resultados mostraram:

Em vários indicadores, o INFP superou outros métodos semelhantes, como qualidade de vídeo, sincronização labial e diversidade de ação, e alcançou excelentes resultados.

Em termos de experiência do usuário, os participantes também concordaram que o vídeo gerado pelo INFP é mais natural e vívido e combina melhor com o áudio.

Os pesquisadores também realizaram experimentos de ablação para provar que cada módulo do INFP é essencial.

Endereço do projeto: https://grisoon.github.io/INFP/

O avanço na tecnologia INFP trouxe mudanças revolucionárias à experiência interativa dos avatares virtuais de IA, aproximando-os dos métodos reais de interação humana. No futuro, espera-se que a tecnologia INFP seja amplamente utilizada em muitos campos, como assistentes virtuais, educação on-line e entretenimento, proporcionando aos usuários uma experiência interativa mais natural, vívida e imersiva.