Imagine ser capaz de gerar música ou efeitos sonoros de alta qualidade com apenas alguns zumbidos ou batidas. Isso não é mais um sonho distante. Sketch2Sound, resultado de pesquisas inovadoras de IA, alcança geração de áudio de alta qualidade combinando imitação de som e prompts de texto. Ele utiliza habilmente os três principais sinais de controle de volume, brilho e tom extraídos da imitação de som e os integra ao modelo de difusão potencial de texto para áudio, orientando assim a IA para gerar sons que atendam a requisitos específicos, trazendo grandes benefícios para o campo de criação sonora.

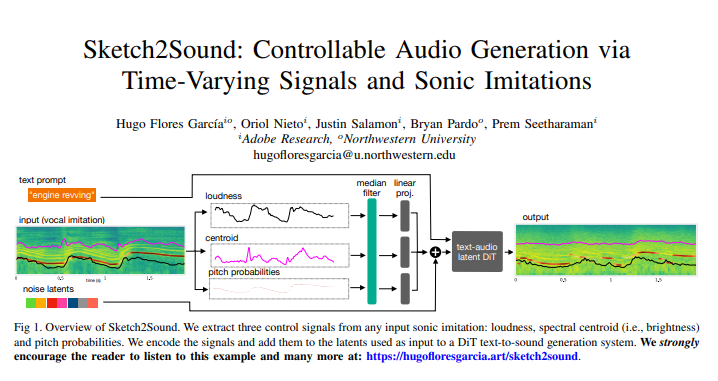

A tecnologia central do Sketch2Sound é sua capacidade de extrair três sinais de controle principais e variáveis no tempo de qualquer imitação de som (como uma imitação vocal ou um som de referência): volume, brilho (centróide espectral) e tom. Uma vez codificados, esses sinais de controle são adicionados ao modelo de difusão subjacente usado para geração de texto para som, orientando assim a IA para gerar sons que atendam a requisitos específicos.

O mais impressionante desta tecnologia é a sua leveza e eficiência. Sketch2Sound é construído no modelo de difusão latente de texto para áudio existente, exigindo apenas 40.000 etapas de ajuste fino e apenas uma camada linear para cada sinal de controle, tornando-o mais conciso e eficiente do que outros métodos (como ControlNet). Para permitir que o modelo sintetize a partir de imitações sonoras semelhantes a “esboços”, os pesquisadores também aplicaram um filtro mediano estocástico ao sinal de controle durante o treinamento, permitindo que ele se adaptasse a sinais de controle com características temporais flexíveis. Os resultados experimentais mostram que o Sketch2Sound pode não apenas sintetizar sons que estejam em conformidade com o sinal de controle de entrada, mas também manter a conformidade com os prompts de texto e obter qualidade de áudio comparável à linha de base do texto simples.

Sketch2Sound oferece aos artistas sonoros uma nova maneira de criar. Eles podem explorar a flexibilidade semântica das instruções textuais, combinada com a expressividade e precisão dos gestos vocais ou imitações, para criar composições sonoras sem precedentes. Isto é semelhante aos artistas tradicionais de Foley que criam efeitos sonoros através da manipulação de objetos, enquanto Sketch2Sound orienta a geração de som através da imitação sonora, trazendo um toque "humanizado" à criação sonora e melhorando o valor artístico das obras sonoras.

Sketch2Sound é capaz de superar suas limitações em comparação aos métodos tradicionais de interação de texto para áudio. No passado, os designers de som precisavam gastar muito tempo ajustando as características temporais dos sons gerados para sincronizá-los com efeitos visuais. Sketch2Sound pode naturalmente conseguir essa sincronização através da imitação de som, e não se limita à imitação da voz humana, qualquer tipo de som. a imitação pode ser usada para impulsionar esse modelo generativo.

Os pesquisadores também desenvolveram uma técnica para ajustar os detalhes temporais do sinal de controle aplicando filtros medianos de diferentes tamanhos de janela durante o treinamento. Isso permite que os artistas sonoros controlem o quão bem o modelo generativo adere à precisão do tempo do sinal de controle, melhorando assim a qualidade dos sons que são difíceis de imitar perfeitamente. Em aplicações práticas, os usuários podem encontrar um equilíbrio entre aderir estritamente à imitação de som e garantir a qualidade do áudio ajustando o tamanho do filtro mediano.

O princípio de funcionamento do Sketch2Sound é primeiro extrair três sinais de controle de volume, centróide do espectro e tom do sinal de áudio de entrada. Esses sinais de controle são então alinhados com os sinais latentes no modelo de texto para som, e o modelo de difusão latente é sintonizado através de uma camada de projeção linear simples para gerar o som desejado. Os resultados experimentais mostram que o condicionamento do modelo por meio do controle do sinal variável no tempo pode melhorar significativamente a conformidade com esse sinal, ao mesmo tempo que tem impacto mínimo na qualidade do áudio e na conformidade do texto.

Notavelmente, os pesquisadores também descobriram que os sinais de controle podem manipular a semântica dos sinais gerados. Por exemplo, ao usar o prompt de texto "ambiente florestal", se rajadas de volume aleatórias forem adicionadas à imitação de som, o modelo pode sintetizar cantos de pássaros nessas rajadas de volume sem o prompt adicional "pássaros", indicando que o modelo aprendeu Correlação entre explosões de volume e presença de pássaros.

Claro, existem algumas limitações no Sketch2Sound, como o fato de que o controle do centro de massa pode incorporar os tons da sala modelados pelos sons de entrada no áudio gerado, possivelmente porque os tons da sala são codificados pelo centro de massa quando há nenhum evento de som no áudio de entrada.

Resumindo, Sketch2Sound é um poderoso modelo de som generativo que pode gerar sons por meio de prompts de texto e controles que variam no tempo (volume, brilho, tom). Ele pode gerar sons por meio de imitação de som e curvas de controle de "esboço", e é leve e eficiente. Ele fornece aos artistas sonoros uma ferramenta controlável, baseada em gestos e expressiva que pode gerar sons com temporização flexível. perspectivas de aplicação nas áreas de criação musical e design de som de jogos no futuro.

Endereço do artigo: https://arxiv.org/pdf/2412.08550

O surgimento do Sketch2Sound anuncia uma nova era no campo da criação sonora. Ele oferece aos artistas liberdade e possibilidades criativas sem precedentes e também traz espaço de imaginação ilimitado para música, jogos, filmes e outros campos. Acredito que num futuro próximo esta tecnologia será mais utilizada e nos trará um mundo sonoro mais colorido.