A startup chinesa de inteligência artificial DeepSeek lançou seu mais recente modelo ultragrande DeepSeek-V3, que se tornou o foco da indústria com seu código-fonte aberto e desempenho poderoso. Com parâmetros 671B e uma arquitetura híbrida especializada, o DeepSeek-V3 supera os principais modelos de código aberto em vários benchmarks e até tem desempenho semelhante a alguns modelos de código fechado. Sua inovação reside em sua estratégia auxiliar de balanceamento de carga sem perdas e na tecnologia de previsão de vários tokens, que melhora significativamente a eficiência do treinamento do modelo e a velocidade de execução. O lançamento do DeepSeek-V3 marca um grande avanço na tecnologia de IA de código aberto, diminuindo ainda mais a lacuna com a IA de código fechado e abrindo caminho para o desenvolvimento da inteligência artificial geral (AGI).

Em 26 de dezembro de 2024, a startup chinesa de inteligência artificial DeepSeek lançou seu mais recente modelo ultragrande DeepSeek-V3, que é conhecido por sua tecnologia de código aberto e desafios inovadores que lideram os fornecedores de IA. DeepSeek-V3 possui parâmetros 671B e usa uma arquitetura mista de especialistas para ativar parâmetros específicos para lidar com uma determinada tarefa com precisão e eficiência. De acordo com benchmarks fornecidos pela DeepSeek, este novo modelo ultrapassou os principais modelos de código aberto, incluindo o Llama3.1-405B da Meta, e tem desempenho semelhante aos modelos fechados da Anthropic e OpenAI.

O lançamento do DeepSeek-V3 marca uma redução ainda maior da lacuna entre a IA de código aberto e a IA de código fechado. A DeepSeek, que começou como uma ramificação do fundo de hedge quantitativo chinês High-Flyer Capital Management, espera que esses desenvolvimentos abram caminho para a inteligência artificial geral (AGI), onde os modelos serão capazes de compreender ou aprender qualquer tarefa intelectual que um ser humano possa realizar. .

Os principais recursos do DeepSeek-V3 incluem:

Assim como seu antecessor DeepSeek-V2, o novo modelo é baseado na arquitetura básica de atenção latente multicabeças (MLA) e DeepSeekMoE, garantindo treinamento e inferência eficientes.

A empresa também lançou duas inovações: uma estratégia auxiliar de balanceamento de carga sem perdas e Multi-Token Prediction (MTP), que permite que os modelos prevejam vários tokens futuros simultaneamente, melhorando a eficiência do treinamento e permitindo que os modelos sejam executados três vezes mais rápido, por gerar 60 tokens por segundo .

Na fase de pré-treinamento, DeepSeek-V3 treinou em tokens diversos e de alta qualidade 14.8T e realizou expansão de comprimento de contexto em dois estágios e, finalmente, realizou pós-treinamento com ajuste fino supervisionado (SFT) e aprendizado por reforço (RL), para alinhar o modelo com as preferências humanas e desbloquear ainda mais o seu potencial.

Na fase de treinamento, o DeepSeek usa uma variedade de otimizações de hardware e algoritmo, incluindo a estrutura de treinamento de precisão mista FP8 e o algoritmo DualPipe para paralelização de pipeline, reduzindo os custos de treinamento. Todo o processo de treinamento do DeepSeek-V3 é concluído em 2788K horas de GPU H800 ou aproximadamente US$ 5,57 milhões, o que é muito menos do que as centenas de milhões de dólares normalmente gastos no pré-treinamento de grandes modelos de linguagem.

DeepSeek-V3 se tornou o modelo de código aberto mais forte do mercado. Vários benchmarks conduzidos pela empresa mostraram que ele superou o GPT-4o de código fechado na maioria dos benchmarks, exceto SimpleQA e FRAMES, com foco em inglês, onde o modelo OpenAI liderou com pontuações de 38,2 e 80,5, respectivamente (as pontuações do DeepSeek-V3 são 24,9 e 73,3). respectivamente). O DeepSeek-V3 teve um desempenho particularmente bom nos benchmarks de chinês e matemática, marcando 90,2 no teste Math-500, seguido pelos 80 de Qwen.

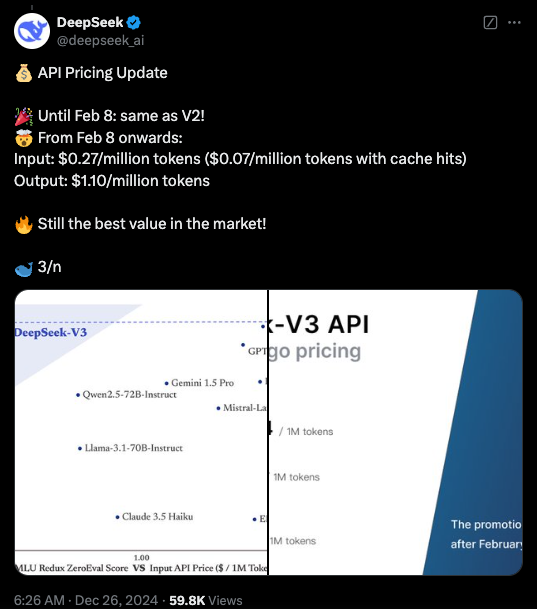

Atualmente, o código do DeepSeek-V3 está disponível sob uma licença do MIT no GitHub, e o modelo é fornecido sob a licença de modelo da empresa. As empresas também podem testar novos modelos por meio do DeepSeek Chat, uma plataforma semelhante ao ChatGPT, e acessar APIs para uso comercial. DeepSeek fornecerá a API pelo mesmo preço do DeepSeek-V2 até 8 de fevereiro. Depois disso, serão cobradas taxas de US$ 0,27 por milhão de tokens de entrada (US$ 0,07 por milhão de tokens para acessos de cache) e US$ 1,10 por milhão de tokens de saída.

Destaque:

DeepSeek-V3 é lançado, com desempenho superando Llama e Qwen.

Adote parâmetros 671B e arquitetura híbrida especializada para melhorar a eficiência.

As inovações incluem estratégias de balanceamento de carga sem perdas e previsão de vários tokens para maior velocidade.

Os custos de formação são significativamente reduzidos, promovendo o desenvolvimento de IA de código aberto.

O código aberto e o alto desempenho do DeepSeek-V3 terão um impacto profundo no campo da inteligência artificial, promoverão o desenvolvimento de tecnologia de IA de código aberto e promoverão sua aplicação em vários campos. A DeepSeek continuará a trabalhar no desenvolvimento de modelos de IA mais avançados e contribuirá para a realização da AGI. No futuro, temos motivos para esperar mais avanços do DeepSeek.