Os mais recentes modelos de IA da série O da OpenAI são projetados para melhorar a segurança dos sistemas de IA por meio de uma compreensão mais profunda das regras e capacidades de raciocínio. Diferente de depender apenas de exemplos de aprendizagem do passado, este modelo pode compreender e aplicar proativamente diretrizes de segurança para bloquear com eficácia solicitações prejudiciais. O artigo detalha o processo de treinamento em três estágios do modelo o1 e seu desempenho além de outros sistemas convencionais de IA em testes de segurança. No entanto, mesmo com o modelo o1 melhorado, ainda existe a possibilidade de manipulação, o que destaca os desafios constantes no domínio da segurança da IA.

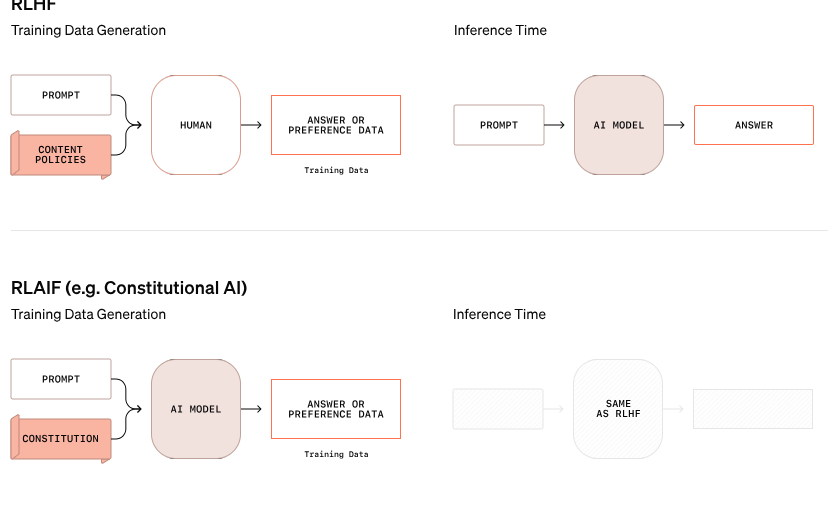

A OpenAI anunciou uma nova abordagem à segurança de IA que visa melhorar a segurança dos sistemas de IA, mudando a forma como eles lidam com as regras de segurança. Este novo modelo da Série O já não se baseia apenas na aprendizagem de bons e maus comportamentos a partir de exemplos, mas é capaz de compreender e raciocinar ativamente sobre diretrizes de segurança específicas.

Num exemplo da pesquisa da OpenAI, quando um utilizador tentou obter instruções para atividades ilegais através de texto encriptado, o modelo descodificou com sucesso a informação, mas rejeitou o pedido, citando especificamente a regra de segurança que seria violada. Este processo de raciocínio passo a passo mostra a eficácia com que o modelo segue as diretrizes de segurança relevantes.

O processo de treinamento deste modelo o1 é dividido em três etapas. Primeiro, o modelo aprende como ajudar. A seguir, por meio de aprendizagem supervisionada, o modelo estuda diretrizes específicas de segurança. Por fim, o modelo utiliza aprendizagem por reforço para praticar a aplicação dessas regras, uma etapa que ajuda o modelo a realmente compreender e internalizar essas diretrizes de segurança.

Nos testes da OpenAI, o modelo o1 recém-lançado teve um desempenho significativamente melhor do que outros sistemas convencionais em termos de segurança, como GPT-4o, Claude3.5Sonnet e Gemini1.5Pro. O teste, que incluiu quão bem o modelo rejeitou solicitações prejudiciais e permitiu a passagem de solicitações adequadas, mostrou que o modelo o1 alcançou pontuações máximas em precisão e resistência a tentativas de jailbreak.

O cofundador da OpenAI, Wojciech Zaremba, disse nas plataformas sociais que está muito orgulhoso desse trabalho de “alinhamento cuidadoso” e acredita que esse tipo de modelo de raciocínio pode ser alinhado de uma maneira completamente nova, especialmente em Ao desenvolver inteligência artificial geral (AGI), garantir que o sistema seja consistente com os valores humanos é um grande desafio.

Apesar das alegações de progresso da OpenAI, um hacker chamado “Plínio, o Libertador” mostrou que mesmo os novos modelos o1 e o1-Pro podem ser manipulados para violar as diretrizes de segurança. Plínio conseguiu que o modelo gerasse conteúdo adulto e até compartilhasse instruções para fazer coquetéis molotov, embora o sistema inicialmente tenha rejeitado essas solicitações. Estes incidentes destacam a dificuldade de controlar estes sistemas complexos de IA porque funcionam com base em probabilidades e não em regras estritas.

Zaremba disse que a OpenAI tem cerca de 100 funcionários dedicados à segurança da IA e à consistência com os valores humanos. Ele levantou questões sobre as abordagens dos rivais em relação à segurança, especialmente o xAI de Elon Musk, que prioriza o crescimento do mercado em vez de medidas de segurança, e a Anthropic, que lançou recentemente um agente de IA sem as devidas salvaguardas. Zaremba acredita que isso trará “enorme feedback negativo” para OpenAI.

Blog oficial: https://openai.com/index/deliberative-alignment/

Destaque:

Os novos modelos da série O da OpenAI podem raciocinar proativamente sobre as regras de segurança e melhorar a segurança do sistema.

O modelo o1 supera outros sistemas convencionais de IA na rejeição de solicitações prejudiciais e na precisão.

Apesar das melhorias, novos modelos ainda podem ser manipulados e os desafios de segurança continuam graves.

Em suma, os modelos da série O da OpenAI fizeram progressos significativos no campo da segurança de IA, mas também expuseram a complexidade e os desafios contínuos da segurança de modelos de linguagem de grande porte. Será necessário continuar a investir mais esforços no futuro para lidar de forma verdadeira e eficaz com os riscos de segurança da IA.