A equipe de Kunlun Wanwei Yan Shuicheng colaborou com a Universidade Tecnológica de Nanyang em Cingapura para lançar um projeto inovador chamado Q*, que visa melhorar significativamente as capacidades de raciocínio de pequenos modelos de linguagem. Ao contrário de outros modelos de linguagem grandes no mercado, o Q* concentra-se em melhorar o desempenho de modelos pequenos, tornando as suas capacidades de raciocínio comparáveis a modelos com parâmetros dezenas ou mesmo centenas de vezes maiores. Espera-se que o resultado desta pesquisa mude as limitações dos pequenos modelos em aplicações práticas e traga novas oportunidades de desenvolvimento para o campo da inteligência artificial. Através de algoritmos inovadores, Q* melhorou significativamente as capacidades de raciocínio de modelos pequenos e alcançou excelentes resultados, superando modelos grandes em vários testes de benchmark.

Recentemente, a equipe doméstica de Kunlun Wanwei Yan Shuicheng e a equipe de pesquisa da Universidade Tecnológica de Nanyang, em Cingapura, lançaram um projeto chamado Q*, com o objetivo de melhorar as capacidades de raciocínio de pequenos modelos. Este projeto é diferente do OpenAI, mas pode permitir que pequenos modelos atinjam as capacidades de raciocínio de modelos com parâmetros dezenas ou até centenas de vezes maiores que ele.

A equipe de pesquisa obteve resultados notáveis por meio do desempenho experimental do algoritmo Q*: no conjunto de dados GSM8K, Q* ajudou o Llama-2-7b a melhorar para uma precisão de 80,8%, superando o ChatGPT.

No conjunto de dados MATH, Q* ajudou o DeepSeek-Math-7b a melhorar para uma precisão de 55,4%, ultrapassando o Gemini Ultra.

No conjunto de dados MBPP, Q * ajudou o CodeQwen1.5-7b-Chat a aumentar a precisão para 77,0%, reduzindo a lacuna no nível de programação com o GPT-4. Estes resultados mostram o potencial do algoritmo Q* em melhorar as capacidades de raciocínio de pequenos modelos.

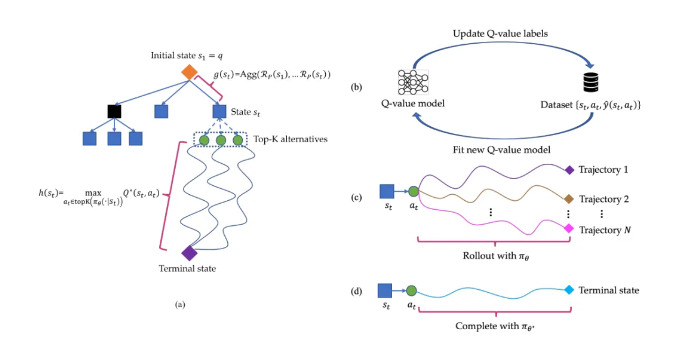

O princípio de funcionamento do algoritmo Q* é decompor a trajetória de raciocínio do modelo de linguagem grande em vários estados, conduzir o planejamento geral para cada estado e usar o algoritmo de busca A* para obter busca prioritária para tarefas de raciocínio complexas. Ao mesmo tempo, eles também treinaram um modelo de valor Q do agente por meio de aprendizagem supervisionada para obter o valor Q ideal do par estado-ação, melhorando assim o desempenho do modelo.

Destaque:

O projeto Q* não é lançado pela OpenAI. Através do algoritmo da equipe de pesquisa, a capacidade de raciocínio do modelo pequeno foi bastante melhorada.

O projeto alcançou resultados experimentais notáveis em múltiplos conjuntos de dados, demonstrando o potencial e a eficácia do algoritmo Q*.

Link do artigo: https://arxiv.org/abs/2406.14283

Os resultados da pesquisa do projeto Q* fornecem uma nova direção para o desenvolvimento de pequenos modelos. Seu algoritmo eficiente e efeito de melhoria significativo são dignos de atenção. No futuro, espera-se que este algoritmo seja aplicado em mais campos e promova o avanço da tecnologia de inteligência artificial. Um link para o artigo foi fornecido para que os leitores interessados possam saber mais detalhes.